Угроза раскрытия информации о модели машинного обучения доклад

Обновлено: 04.05.2024

Какие сюрпризы преподносит нам машинное обучение? Сложно ли его обмануть? И не закончится ли все это Скайнетом и восстанием машин? Давайте разберемся.

28 августа 2018

Искусственный интеллект врывается в нашу жизнь. В будущем, наверное, все будет классно, но пока возникают кое-какие вопросы, и все чаще эти вопросы затрагивают аспекты морали и этики. Какие сюрпризы преподносит нам машинное обучение уже сейчас? Можно ли обмануть машинное обучение, а если да, то насколько это сложно? И не закончится ли все это Скайнетом и восстанием машин? Давайте разберемся.

Разновидности искусственного интеллекта: Сильный и Слабый ИИ

Для начала стоит определиться с понятиями. Есть две разные вещи: Сильный и Слабый ИИ. Сильный ИИ (true, general, настоящий) — это гипотетическая машина, способная мыслить и осознавать себя, решать не только узкоспециализированные задачи, но еще и учиться чему-то новому.

Машинное обучение: что может пойти не так?

Если Сильного ИИ ждать еще непонятно сколько, то Слабый ИИ уже с нами и вовсю работает во многих областях народного хозяйства.

И таких областей с каждым годом становится все больше и больше. Машинное обучение позволяет решать практические задачи без явного программирования, а путем обучения по прецедентам. Подробнее вы можете почитать в статье «Простыми словами: как работает машинное обучение«.

1. Плохие намерения

Начать с того, что сама решаемая задача может быть недостаточно этичной. Например, если мы при помощи машинного обучения учим армию дронов убивать людей, результаты могут быть несколько неожиданными.

Как раз недавно по этому поводу разгорелся небольшой скандал. Компания Google разрабатывает программное обеспечение, используемое для пилотного военного проекта Project Maven по управлению дронами. Предположительно, в будущем это может привести к созданию полностью автономного оружия.

Так вот, минимум 12 сотрудников Google уволились в знак протеста, еще 4000 подписали петицию с просьбой отказаться от контракта с военными. Более 1000 видных ученых в области ИИ, этики и информационных технологий написали открытое письмо с просьбой к Google прекратить работы над проектом и поддержать международный договор по запрету автономного оружия.

2. Предвзятость разработчиков алгоритма

Даже если авторы алгоритма машинного обучения не хотят приносить вред, чаще всего они все-таки хотят извлечь выгоду. Иными словами, далеко не все алгоритмы работают на благо общества, очень многие работают на благо своих создателей. Это часто можно наблюдать в области медицины — важнее не вылечить, а порекомендовать лечение подороже.

На самом деле иногда и само общество не заинтересовано в том, чтобы полученный алгоритм был образцом морали. Например, есть компромисс между скоростью движения транспорта и смертностью на дорогах. Можно запрограммировать беспилотные автомобили так, чтобы они ездили со скоростью не более 20 км/ч. Это позволило бы практически гарантированно свести количество смертей к нулю, но жить в больших городах стало бы затруднительно.

3. Параметры системы могут не включать этику

И хорошо, если алгоритму поручили только составление бюджета. Потому что при более широкой постановке задачи может выйти, что самый выгодный способ повысить среднюю производительность труда — это избавиться от всего неработоспособного населения.

Выходит, что этические вопросы должны быть среди целей системы изначально.

4. Этику сложно описать формально

С этикой одна проблема — ее сложно формализовать. Во-первых, этика довольно быстро меняется со временем. Например, по таким вопросам, как права ЛГБТ и межрасовые / межкастовые браки, мнение может существенно измениться за десятилетия.

Во-вторых, этика отнюдь не универсальна: она отличается даже в разных группах населения одной страны, не говоря уже о разных странах. Например, в Китае контроль за перемещением граждан при помощи камер наружного наблюдения и распознавания лиц считается нормой. В других странах отношение к этому вопросу может быть иным и зависеть от обстановки.

Также этика может зависеть от политического климата. Например, борьба с терроризмом заметно изменила во многих странах представление о том, что этично, а что не очень — и произошло это невероятно быстро.

5. Машинное обучение влияет на людей

Представьте систему на базе машинного обучения, которая советует вам, какой фильм посмотреть. На основе ваших оценок другим фильмам и путем сопоставления ваших вкусов со вкусами других пользователей система может довольно надежно порекомендовать фильм, который вам очень понравится.

6. Ложные корреляции

Ложная корреляция — это когда не зависящие друг от друга вещи ведут себя очень похоже, из-за чего может возникнуть впечатление, что они как-то связаны. Например, потребление маргарина в США явно зависит от количества разводов в штате Мэн, не может же статистика ошибаться, правда?

Конечно, живые люди на основе своего богатого жизненного опыта подозревают, что маргарин и разводы вряд ли связаны напрямую. А вот математической модели об этом знать неоткуда, она просто заучивает и обобщает данные.

Известный пример: программа, которая расставляла больных в очередь по срочности оказания помощи, пришла к выводу, что астматикам с пневмонией помощь нужна меньше, чем людям с пневмонией без астмы. Программа посмотрела на статистику и пришла к выводу, что астматики не умирают, поэтому приоритет им незачем. А на самом деле такие больные не умирали потому, что тут же получали лучшую помощь в медицинских учреждениях в связи с очень большим риском.

7. Петли обратной связи

Хуже ложных корреляций только петли обратной связи. Это когда решения алгоритма влияют на реальность, что, в свою очередь, еще больше убеждает алгоритм в его точке зрения.

Вот пример неумышленных проблем с исходными данными: если в качестве обучающей выборки для алгоритма по найму сотрудников использовать данные, полученные из компании с расистскими практиками набора персонала, то алгоритм тоже будет с расистским уклоном.

Пример умышленного отравления машинного обучения: в лаборатории по анализу компьютерных вирусов математическая модель ежедневно обрабатывает в среднем около миллиона файлов, как чистых, так и вредоносных. Ландшафт угроз постоянно меняется, поэтому изменения в модели в виде обновлений антивирусных баз доставляются в антивирусные продукты на стороне пользователей.

9. Взлом машинного обучения

Отравление — это воздействие на процесс обучения. Но обмануть можно и уже готовую, исправно работающую математическую модель, если знать, как она устроена. Например, группе исследователей удалось научиться обманывать алгоритм распознавания лиц с помощью специальных очков, вносящих минимальные изменения в картинку и тем самым кардинально меняющих результат.

Надев специально раскрашенные очки, исследователи смогли обманывать алгоритм распознавания лиц и выдавать себя за других людей

Даже там, где, казалось бы, нет ничего сложного, машину легко обмануть неведомым для непосвященного способом.

Причем для того, чтобы математическая модель машинного обучения признала капитуляцию, необязательно вносить существенные изменения — достаточно минимальных, невидимых человеку правок.

Если к панде слева добавить минимальный специальный шум, то получим гиббона с потрясающей уверенностью

Кто виноват и что делать

В 2016 году Рабочая группа по технологиям больших данных при администрации Обамы выпустила отчет, предупреждающий о том, что в алгоритмы, принимающие автоматизированные решения на программном уровне, может быть заложена дискриминация. Также в отчете содержался призыв создавать алгоритмы, следующие принципу равных возможностей.

Но сказать-то легко, а что же делать? С этим не все так просто.

Во-первых, математические модели машинного обучения тяжело тестировать и подправлять. Если обычные программы мы читаем по шагам и научились их тестировать, то в случае машинного обучения все зависит от размера контрольной выборки, и она не может быть бесконечной.

К примеру, приложение Google Photo распознавало и помечало людей с черным цветом кожи как горилл. И как быть? За три года Google не смогли придумать ничего лучше, чем запретить помечать вообще любые объекты на фотографиях как гориллу, шимпанзе и обезьяну, чтобы не допускать повторения ошибки.

Во-вторых, нам сложно понять и объяснить решения машинного обучения. Например, нейронная сеть как-то расставила внутри себя весовые коэффициенты, чтобы получались правильные ответы. А почему они получаются именно такими и что сделать, чтобы ответ поменялся?

Исследование 2015 года показало, что женщины гораздо реже, чем мужчины, видят рекламу высокооплачиваемых должностей, которую показывает Google AdSense. Сервис доставки в тот же день от Amazon зачастую недоступен в черных кварталах. В обоих случаях представители компаний затруднились объяснить такие решения алгоритмов.

- Безопасность людей — наивысший приоритет по сравнению с уроном животным или собственности.

- В случае неизбежной аварии не должно быть никакой дискриминации, ни по каким факторам недопустимо различать людей.

Но что особенно важно в нашем контексте:

- Автоматические системы вождения становятся этическим императивом, если системы вызывают меньше аварий, чем водители-люди.

Очевидно, что мы будем все больше и больше полагаться на машинное обучение — просто потому, что оно в целом будет справляться со многими задачами лучше людей. Поэтому важно помнить о недостатках и возможных проблемах, стараться все предусмотреть на этапе разработки систем — и не забывать присматривать за результатом работы алгоритмов на случай, если что-то все же пойдет не так.

Существуют разные причины утечки данных. Некоторые из них очень очевидны, но некоторые сложно заметить с первого взгляда. В этой статье я объясню причины утечки данных, как она вводит в заблуждение, а также способы обнаружения и ее предотвращения.

Вы наверняка их знаете, но я лишь хочу упомянуть два термина, которые я буду часто использовать в этой статье:

- Целевая переменная: что пытается предсказать модель

- Фичи (функции): данные, используемые моделью для прогнозирования целевой переменной

Примеры утечки данных

Наиболее очевидной причиной утечки данных является включение целевой переменной в качестве функции, которая полностью уничтожает цель "прогнозирования". Вероятно, это может быть сделано по ошибке, но важно убедиться, что целевая переменная отличается от фичей.

Другой распространенной причиной утечки данных является включение тестовых данных в данные по обучению модели. Очень важно протестировать модели с новыми, ранее не использованными данными. А включение тестовых данных в тренировочный процесс не позволит достичь этой цели.

Эти два случая маловероятны, потому что их легко обнаружить. Более опасные причины - те, которые могут проникнуть "тайком".

Функции Giveaway - это функции, которые раскрывают информацию о целевой переменной и не будут доступны после развертывания модели.

- Пример. Предположим, мы строим модель для прогнозирования определенного состояния здоровья. Функция, указывающая, была ли у пациента операция, связанная с этим заболеванием, вызывает утечку данных и никогда не должна включаться в данные обучения. Указание на хирургическое вмешательство в высокой степени предсказывает состояние здоровья и, вероятно, эта информация будет доступна не во всех случаях. Если мы уже знаем, что пациент перенес операцию, что могло сказаться на состояние здоровья, нам может даже не понадобиться прогнозирующая модель для начала.

- Пример. Рассмотрим модель, которая прогнозирует, останется ли пользователь на сайте. Включение функций, предоставляющих информацию о будущих посещениях, приведет к утечке данных. Мы должны использовать только функции текущего сеанса, потому что информация о будущих сеансах обычно не доступна после развертывания модели.

Существует много этапов предварительной обработки для изучения или подчищения данных.

- Нахождение параметров для нормализации или масштабирования;

- Мин/Макс значения функции;

- Распределение переменной функции для оценки пропущенных значений;

- Удаление выбросов.

Эти шаги должны быть выполнены с использованием только обучающего набора данных. Если мы используем весь набор данных для выполнения этих операций, может произойти утечка данных. Применение методов предварительной обработки ко всему набору данных приведет к тому, что модель изучит не только тренировочный набор, но и тестовый. Мы все знаем, что тестовые данные должны быть новыми, ранее не использованными.

При работе с данными временных рядов мы должны уделять больше внимания утечке. Например, если мы каким-то образом используем данные из будущего при выполнении вычислений для текущих функций или прогнозов, это может привести к утечке.

Как обнаружить и избежать утечки данных

В целом, если модель слишком хороша и результат не очень похож на правду, то это уже должно вызывать подозрение. Возможно, модель каким-то образом запоминает связь между функциями и целью, вместо того чтобы обучаться и обобщать.

В процессе анализа исследовательских данных мы можем обнаружить функции, которые очень сильно коррелируют с целевой переменной. Конечно, некоторые функции более корреляционны, чем другие, но слишком высокая корреляция требует тщательной проверки и обработки. Мы должны уделять им пристальное внимание.

После обучения модели, если есть функции с очень большим влиянием, мы должны быть особенно внимательными. Они могут быть протекающими элементами.

Для того чтобы свести к минимуму или избежать утечки, нам следует попытаться, по возможности, отказаться от проведения проверки достоверности данных в дополнение к учебным и испытательным наборам данных. Набор проверки может использоваться в качестве последнего этапа и имитировать реальный сценарий.

При работе с данными временных рядов предельное значение по времени может быть очень полезным, поскольку оно не позволит нам получить какую-либо информацию после момента прогнозирования.

Обычно в процессе обучения используется перекрестная проверка, особенно когда данные ограничены. Перекрестная проверка разделяет данные на k сгибов и выполняет итерацию по всему набору данных k раз и каждый раз, используя k-1 кратное обучение и 1 сгиб для тестирования. Преимущество перекрестной проверки заключается в том, что она позволяет использовать весь набор данных как для обучения, так и для тестирования. Однако, если у вас возникнут подозрения относительно утечки данных, лучше масштабировать / нормализовать данные и вычислять параметры для каждого сгиба отдельно.

Заключение

Утечка данных является широко распространенной проблемой в прогнозировании аналитики. Мы обучаем модели с известными данными и ожидаем, что модель будет выполнять прогнозирование на ранее не использованных данных. Чтобы модель имела качественные показатели в этих прогнозах, она должна хорошо обобщать. Утечка данных не позволяет модели хорошо обобщать и, таким образом, вызывает ложные предположения о производительности модели. Для получения надежной и обобщенной модели прогнозирования мы должны уделять пристальное внимание выявлению и предотвращению утечки данных.

Какие угрозы, построенные на основе методов машинного обучения, возможны в реальных условиях и как их предотвратить?

- Ключевые слова / keywords:

- Безопасность

- Safety

- Глубинное обучение

- Deep Learning

- Кибератаки

- Cyber attacks

- Кибербезопасность

- Cybersecurity

- Машинное обучение

- Machine learning

Рост популярности решений на базе методов машинного обучения делает актуальными исследования в сфере вредоносного машинного обучения и интеграции средств предотвращения таких атак в системы и сервисы.

Конфронтационное, противоборствующее или вредоносное машинное обучение (Adversarial Machine Learning, AML) составляет предмет зарождающейся области исследований, занимающейся проблемами обеспечения безопасности с использованием алгоритмов машинного обучения в системах искусственного интеллекта, в том числе методами защиты от потенциальных угроз. В основном рассматриваются угрозы, связанные с возможностью изменения работы моделей машинного обучения путем преднамеренного внесения искажений во входные данные. AML имеет дело с уязвимостями, присутствующими в алгоритмах машинного обучения, поэтому его следует отличать от атак, совершаемых с помощью машинного обучения, равно как и от систем безопасности на его основе.

Каталог основных AML-атак

Жизненный цикл системы машинного обучения можно поделить на два основных этапа: собственно обучение, когда вводят обучающие данные и настройки для формирования обученной модели, и эксплуатация, когда обученную модель развертывают и она работает с сервисами. В особых случаях (например, при машинном обучении в режиме онлайн, когда модель постоянно обновляется за счет непрерывного ввода рабочих данных и откликов пользователя) рабочая и обучающая стадии чередуются. Классический пример онлайн-обучения — упомянутый механизм действия антиспам-фильтра. С учетом двухэтапного жизненного цикла системы машинного обучения можно выделить пять основных видов AML-атак (см. рисунок).

Атаки уклонения. Атакующий формирует вредоносные входные данные (образцы) таким образом, чтобы целевая модель машинного обучения выдавала неверные прогнозы. Типичный пример атаки уклонения, направленной против системы компьютерного зрения, — это распознавание содержащего вредоносные шумы изображения собаки в качестве изображения кошки. Другой пример атаки — применение специального рисунка на футболке или оправе очков, который позволяет обходить системы безопасности и биометрической аутентификации. Вероятность проведения атаки уклонения указывает на ограничения модели машинного обучения. Следует также отметить, что вредоносные образцы могут обладать переносимостью: образец, подготовленный для определенной модели, будет эффективным и с другими моделями, которые выполняют такую же или похожую задачу.

Атаки кражи моделей. Такие атаки проводятся на этапе эксплуатации. Отправляя запросы к целевой модели, атакующий может создать ее приблизительный аналог; при этом злоумышленники также могут получить параметры модели, используя уязвимости системы. Применение сочетания методов позволяет проводить мощные атаки уклонения в отношении целевой модели. Атака кражи модели может быть классифицирована как хищение интеллектуальной собственности.

Разные сервисы и приложения с механизмами машинного обучения уязвимы для различных типов угроз. Например, облачный сервис машинного обучения, использующий очень популярную модель, может быть подвергнут атаке кражи модели с целью непредусмотренного использования ее возможностей. А приложение для конечного устройства, применяющее небольшую модель машинного обучения, может стать мишенью для атаки хищения, в ходе которой атакующие извлекут параметры модели из устройства путем эксплуатации уязвимостей системы.

Примеры AML-атак

Перечисленные далее атаки изначально были разработаны в исследовательских лабораториях, после чего их эффективность была проверена в реальных условиях. Между результатами, полученными в лабораториях, и атаками реального мира имеются определенные различия, но некоторые атаки оказываются весьма успешными. Обычно они осуществляются путем манипуляций с реальными обучающими данными или с помощью воспроизведения исследовательских методов в реальных условиях.

Противодействие AML-угрозам

AML-атаки создают угрозы физической и информационной безопасности, а также конфиденциальности. Важность защиты систем машинного обучения от состязательных атак оценили не только исследователи, интерес к ней проявили бизнес и организации по стандартизации. Перечислим имеющиеся сегодня основные меры противодействия AML-угрозам.

Анализ угроз. В ходе первичного анализа составляется общий обзор потенциальных угроз в отношении сервисов на основе машинного обучения и определяются уязвимые интерфейсы, на которые нужно обратить внимание разработчикам и сервис-провайдерам. Microsoft совместно с некоммерческой организацией MITRE ведет опорную таблицу угроз AML, которую в рамках анализа безопасности можно использовать в качестве справочника по известным на сегодня методам атак против систем машинного обучения. Похожую таблицу, содержащую перечень известных атак и базовых рекомендаций по защите, публикует компания Tencent. По результатам анализа можно выбирать наиболее действенные средства защиты.

Предотвращение угроз. Отдел безопасности искусственного интеллекта Европейского института телекоммуникационных стандартов подготовил технический отчет по стратегии предотвращения угроз ETSI-SAI-005-GR. В нем описаны доступные методы предотвращения основных видов атак, в том числе санация данных, обнаружение вредоносных образцов и усиление модели. Кроме того, в документе описываются и обобщаются существующие методы защиты от AML-угроз, с опорой на которые можно строить стратегии предотвращения, обнаружения и реагирования.

Обеспечение безопасности на этапе проектирования. Подход security by design рекомендован в качестве проактивного механизма безопасности. Защита достигается путем внедрения процессов обеспечения безопасности в жизненный цикл разработки и эксплуатации системы машинного обучения. При этом можно пользоваться методами DevSecOps, реализованными для процессов разработки программного обеспечения. В контексте разработки систем машинного обучения соответствующий процесс дополняется средствами непрерывной интеграции, доставки и обучения, однако этой теме пока посвящено мало исследований. Основные этапы данного подхода: введение требований к безопасности, реализация механизмов обеспечения безопасности и верификация выполнения требований к безопасности. Первый из этих этапов может быть признан обязательным на законодательном уровне, выполнение двух остальных требует мощной технической поддержки, в том числе механизмов усиления и тестирования безопасности.

С учетом масштабов применения машинного обучения актуальны дальнейшие исследования в сфере AML и интеграции средств предотвращения атак в системы и сервисы на основе машинного обучения. При этом требуется нечто большее, чем просто обеспечение защищенности, — необходимо добиться того, чтобы системам машинного обучения можно было доверять, в связи с чем также требуются соответствующие исследования.

Литература

1. S. Thys, W. Van Ranst, T. Goedeme. Fooling automated surveillance cameras: Adversarial patches to attack person detection. In Proc. IEEE/CVF Conf. Comput. Vision Pattern Recognit. (CVPR) Workshops. — 2019. P. 49–55.

2. M. Barreno, B. Nelson, R. Sears, A. D. Joseph, J. D. Tyger. Can machine learning be secure? In Proc. ACM Symp. Inf., Comput. Commun. Security. — 2006. P. 16–25. doi:10.1145/1128817.1128824.

3. B. Biggio, F. Roli. Wild patterns: Ten years after the rise of adversarial machine learning // Pattern Recognit. — 2018. — Vol. 84. — P. 317–331. doi:10.1016/j.patcog.2018.07.023.

Hsiao-Ying Lin, Battista Biggio, Adversarial Machine Learning: Attacks From Laboratories to the Real World? IEEE Computer, May 2021, IEEE Computer Society. All rights reserved. Reprinted with permission.

Машинное обучение, Кибербезопасность,Глубинное обучение, Кибератаки,Machine Learning, Cybersecurity, Deep Learning, Cyberattacks

Дисклеймер Статья выражает личное мнение автора, основанное на приведённых в ссылках материалах. Это спорная область и конструктивное обсуждение приветствуется.

В настоящее время в научных кругах назревает понимание кризиса воспроизводимости. Могу поспорить, что основным его источником является применение в научных целях техник машинного обучения.

Адепты статистики и машинного обучения в научных кругах ведут нескончаемый горячий спор относительно кризиса воспроизводимости.

Один из исследователей ИИ, Али Рахими, назвал технологии машинного обучения разновидностью алхимии. Полный текст заявления можно прочитать в соответствующей статье его блога.

Типы и алгоритмы МО и сами могут стать предметом исследования. В научных источниках можно найти множество статей и материалов на тему методов машинного обучения, как раньше можно было найти работы по статистическим методам.

В феврале 2019 Дженевьера Аллен сделала тревожное заявление для Американской ассоциации содействия развитию науки: учёные, полагающиеся на машинное обучение, обнаруживают определённую систематику в данных, даже если алгоритм просто зацикливается на информационном шуме, который в ходе повторного эксперимента, как правило, не повторяется.

Указанная проблема характерна для множества научных дисциплин, поскольку машинное обучение применяется в различных областях исследования, таких как астрономия, геномика, энвайроментология, здравоохранение.

В качестве яркого примера она ссылается на исследования в области геномики, в которых обычно обрабатываются датасеты размером в сотни гигабайт и даже несколько терабайт. Аллен утверждает, что когда учёные используют плохо изученные алгоритмы машинного обучения для кластеризации профилей генома, это зачастую ведёт к получению правдоподобно выглядящих, но невоспроизводимых результатов.

При этом другая группа исследователей, используя те же методы анализа, может получить значительно отличающиеся результаты, таким образом оспаривая и дискредитируя первоначальный эксперимент. Это может происходить по нескольким причинам:

- недостаточное понимание алгоритма МО;

- недостаточное знакомство с исходными данными;

- неверная интерпретация результатов.

Недостаточное понимание алгоритма МО

Это серьёзная проблема при работе с нейросетями ввиду множества параметров (зачастую для глубоких нейросетей количество параметров может составлять миллионы). Помимо этих параметров надо принимать в расчёт и гиперпараметры — такие как скорость обучения, метод инициализации, количество итераций, архитектура нейросети.

Для решения проблемы мало осознать, что исследователь недостаточно хорошо понимает работу алгоритма. Как можно сравнить результаты, если в разных работах применялись отличающиеся по структуре нейронные сети? Многослойная нейронная сеть имеет очень сложную динамическую структуру. Поэтому даже добавление единственной переменной или смена одного гиперпараметра может значительно повлиять на результаты.

Недостаточное знакомство с исходными данными

Плохое понимание исходных данных также является серьёзной проблемой, но эта проблема существовала и во время работы с традиционными статистическими методами. Ошибки в сборе данных — такие как ошибки квантования, неточности считывания и использование замещающих переменных — самые распространённые затруднения.

Субоптимальные данные всегда будут проблемой, но понимать, какой алгоритм применить к какому типу данных — невероятно важно, это значительно повлияет на результат. Это можно продемонстрировать на примере простой регрессии.

При использовании регрессии LASSO это приведёт к приближению переменных, определённых в качестве незначительных, к нулю. Тем самым будет проведён отбор переменных с исключением избыточных.

Гребневая регрессия сжимает названные параметры до пренебрегаемо малых величин, но не исключает их из набора.

При использовании эластичной сети (комбинации LASSO и гребневой регрессии), мы снова получим совсем другие результаты.

Если мы не будем использовать регрессию, алгоритм очевидно будет страдать от переобучения, поскольку у нас будет больше переменных, чем точек данных, и алгоритм просто заполнит все точки данных.

Конечно, для линейной регрессии можно выполнить статистические тесты, которые помогут установить точность в виде доверительных интервалов, p-тесты и тому подобное. Однако такая роскошь не доступна для нейронных сетей, поэтому можем ли мы быть уверены в выводах? Лучшее, что мы можем сделать — точно определить архитектуру и гиперпараметры модели и предоставить открытый исходный код, чтобы другие исследователи могли проанализировать модель и использовать её самостоятельно.

Неверная интерпретация результатов

Ошибочная оценка результатов может быть весьма распространена в научном мире. Одна из причин — видимая корреляция не всегда отражает реальную взаимосвязь. Есть несколько причин, почему переменные А и B могут коррелировать:

- A может изменяться при изменении B;

- B может изменяться при изменении A;

- A и B могут изменяться при изменении общей базовой переменной, C;

- корреляция A и B может быть ложной.

Всё это может выглядеть забавными совпадениями, но смысл в том, что алгоритм машинного обучения, обработав эти переменные единым набором, воспримет их как взаимозависимые, не подвергая эту зависимость сомнению. То есть алгоритм будет неточным или ошибочным, поскольку ПО выделит в датасете паттерны, которых не существует в реальном мире.

Это примеры ложных корреляций, которые в последние годы опасно распространились в связи с использованием наборов данных из тысяч переменных.

Если у нас есть тысяча переменных и миллионы точек данных, определённые корреляции неизбежны. Алгоритмы могут сконцентрироваться на этом и предположить причинно-следственную связь, невольно реализуя технику p-hacking, не слишком одобряемую в академических кругах.

Что такое p-hacking

Суть p-hacking’а состоит в дотошном поиске в наборе данных статистически значимых корреляций и принятии их за научно обоснованные.

Чем больше у вас данных, тем вероятнее найти ложные корреляции двух переменных.

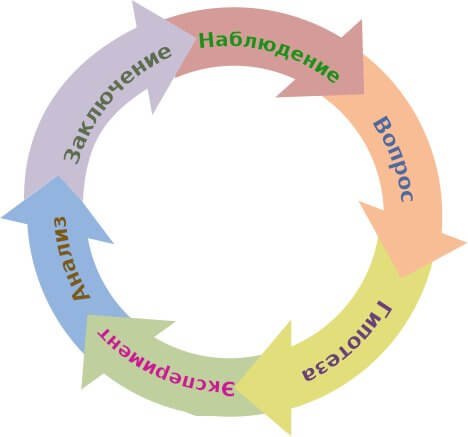

Обычно научный подход последовательно включает формулирование гипотезы, сбор данных и анализ собранных данных для подтверждения обоснованности гипотезы. В процессе же p-hacking’а сначала проводится эксперимент, и по его результатам формируются гипотезы, объясняющие полученные данные. Иногда это делают без злого умысла, но временами учёные прибегают к такому методу только для того, чтобы получить возможность опубликовать больше материалов исследований.

Форсирование корреляций

В настоящий момент автор не знает алгоритма машинного обучения, который мог бы прийти к заключению, что данные не подходят для того, чтобы делать обоснованные выводы. Предполагается, что это работа учёного.

Зачем использовать машинное обучение?

Хороший вопрос. Машинное обучение упрощают анализ данных и алгоритмы МО делают за пользователя громадную работу. В тех областях, где учёные имеют дело с действительно большими объёмами данных, традиционные методы статистического анализа оказываются неэффективными и применение МО — единственный разумный способ обработки информации. Однако следует учитывать, что увеличение продуктивности работы за счёт ускорения анализа данных может быть скомпрометировано недостаточным качеством полученных прогнозов.

Что можно сделать?

Конечно, не всё так трагично. Та же проблема всегда присутствовала при использовании традиционных статистических методов анализа. Она лишь усугубилась с появлением больших наборов данных и алгоритмов, которые находят корреляции автоматически и не настолько прозрачны, как стандартные методы. И это усиление выявило недостатки научного процесса, которые ещё предстоит преодолеть.

В то же время при разработке систем машинного обучения нового поколения предстоит проделать серьёзную работу, чтобы можно было точно определить достоверность и воспроизводимость результатов анализа.

Как говорится, плох тот рабочий, что винит в неудаче инструмент, и учёным следует уделять больше внимания применяемым алгоритмам МО, чтобы удостовериться в обоснованности выводов их исследований. Институт рецензирования предназначен для отсеивания необоснованных научных работ, но это также и задача каждого отдельно взятого исследователя. Учёные должны знать принципы работы применяемых ими методов, чтобы понимать ограничения этих инструментов. Если их познаний в этой области недостаточно — возможно, стоит заглянуть на кафедру статистики.

Рахими (тот учёный, что считает МО разновидностью алхимии) предлагает несколько подходов, которые позволят определить, как и когда лучше всего применять определённый алгоритм. Он утверждает, что при выборе алгоритма следует проводить исследования абляции — последовательно удаляя параметры, чтобы определить их влияние на выбранную модель МО. Он также предлагает делать анализ срезов — изучая производительность алгоритма, чтобы определить, как улучшения в определённых областях могут отразиться на чём-то ещё. Наконец, он предлагает прогонять алгоритм на разных наборах гиперпараметров, анализируя производительность системы для каждого из них. Таким образом можно повысить уверенность в результатах прогнозов, полученных с помощью МО.

Из-за природы научного процесса, если вышеописанные проблемы будут решены, ложные взаимоотношения, выведенные в результате исследований с применением машинного обучения будут выявлены и дискредитированы. Истинные же корреляции пройдут проверку временем.

Заключение

Машинное обучение в науке представляет проблему из-за того, что результаты недостаточно воспроизводимы. Однако учёные в курсе этой проблемы и работают над моделями МО, дающими более воспроизводимый и прозрачный результат. Настоящий прорыв произойдёт, когда эта задача будет решена для нейросети.

Даже Рахими, считающий МО алхимией, всё же признает его потенциал. Он отмечает, что алхимия породила металлургию, фармацевтику, технологии окраски тканей, современные процессы получения стекла. Но алхимики также верили в возможность трансмутации металлов в золото и в то, что пиявки — отличный способ для лечения заболеваний.

Как сказал физик Ричард Фейнман в своей речи перед выпускниками Калифорнийского технологического института в 1974 году:

Первый принцип [науки] заключается в том, чтобы не одурачить самого себя. И как раз себя-то одурачить проще всего.

Читайте также: