Энтропия кибернетика и генетика кратко

Обновлено: 02.07.2024

ОСОБЕННОСТИ ИСПОЛЬЗОВАНИЯ ЭНТРОПИЙНО-ИНФОРМАЦИОННОГО АНАЛИЗА ДЛЯ КОЛИЧЕСТВЕННЫХ ПРИЗНАКОВ БИОЛОГИЧЕСКИХ ОБЪЕКТОВ

В работе проанализированы возможности применения энтропийно-информационного анализа для полигенных (количественных) признаков биологических объектов различной природы, имеющих нормальное (гауссово) распределение или близкое к нему. Показано, что более обосновано использование не частот абсолютных значений признаков, рассчитанных на основе гистограммы выборочного распределения, а частот интеграла плотности вероятностей распределения стандартизированных значений.

В последнее время появилось много публикаций, в которых продемонстрированы возможности применения энтропийно-информационного анализа (ЭИА) в различных областях биологической науки 1, физиологии и медицине 6 и др. В экологии, наряду с использованием формулы К.Шеннона для оценки меры биоразнообразия отдельных сообществ и биоценозов, ИЭА получил свое применение и в качестве метода биоиндикации экосистем по соотношению мер адаптивности и инадаптивности признака или группы признаков 7. При этом приводятся многочисленные примеры применения ЭИА при изучении как дискретных (качественных) признаков, имеющих полиномиальное распределение (для которых исходно были разработаны основные положения теории информации и, в частности, ЭИА), так и количественных (полигенных), которые чаще всего подчиняются нормальному закону распределения или близкому к нему.

Однако до сих пор нет единого, теоретически обоснованного метода оценки энтропии для количественных признаков. Кроме того, проанализировав примеры применения ИЭА и методики, которые используются в этих работах, мы пришли к заключению, что они очень часто имеют один существенный недостаток, который может повлиять на получаемые результаты. Это побудило нас к разработке нового подхода к использованию ИЭА в применении к количественным признакам.

Базисным понятием теории информации является понятие энтропии, математически точный смысл которого вытекает из работ К.Шеннона [9]. Энтропия – мера неопределенности некоторой ситуации. Ее также можно рассматривать в качестве меры рассеяния, и в этом смысле она подобна статистическому понятию “дисперсия”. Но если дисперсия является адекватной мерой рассеяния только для специальных распределений вероятностей случайных величин (в частности, для гауссова распределения), то энтропия не зависит от типа этого распределения. Кроме того, энтропия обладает и рядом других полезных свойств. Во-первых, неопределенность любой системы возрастает с ростом числа возможных исходов. А, во-вторых, мера неопределенности обладает свойством аддитивности.

Впервые особенности функционирования биологических систем разного уровня с точки зрения теории информации были рассмотрены в работе И.И.Шмальгаузена [10]. Им были введены понятия о каналах прямой и обратной связи, по которым передается генетическая и фенотипическая информация, рассмотрены закономерности кодирования и преобразования биологической информации.

У.Эшби [11] впервые предложил использовать понятие энтропии для характеристики меры сложности системы. Согласно его представлениям, сложность системы (в том числе и биологической) можно охарактеризовать ее разнообразием. Под разнообразием обычно понимается количество состояний, которое может принимать система. Кроме этого, при оценке энтропии учитывается не только абсолютное количество таких состояний, но и вероятность (а в выборочных исследованиях вероятность можно заменить частотой), с которой система принимает то или иное состояние. Тогда оценкой для энтропии может служить выражение:

где p i – вероятность (или частота) того, что система примет i -тое состояние из k возможных.

Как легко убедиться, максимума эта величина достигает в том случае, когда вероятности принятия системой любого из k возможных состояний равны. В этом случае значение энтропии для такой системы будет равно:

В том же случае, когда система может принять только одно состояние с частотой равной 1, энтропия ее равняется нулю. Таким образом, для любой (невырожденной) системы имеет место выражение:

Энтропия, как мера разнообразия и организованности системы, прежде всего, характеризует степень ее неопределенности или, другими словами, детерминированности. Система считается тем детерминированее, чем меньше ее значение энтропии, т.е. чем ближе величина Н к нулю. Как мы показали выше, это происходит в том случае, когда одно из возможных состояний системы имеет очень высокую вероятность (частоту) проявления. С этих позиций, понятия энтропии можно сравнить с коэффициентом наследуемости ( h 2 ), введенным Р.А.Фишером. Чем выше значение коэффициента наследуемости признака в какой-то группе организмов (популяции), тем в меньшей мере уровень проявления этого признака зависит от паратипических факторов, соответственно, тем выше его детерминированность (в данном случае фенотипа генотипом) и, соответственно, ниже энтропия системы.

В своем применении ИЭА в большей мере рассчитан на системы (признаки), имеющие качественное выражение, т.е. для которых различия между отдельными состояниями носит дискретный характер. Однако, как указывает Е.С. Вентцель [12], количественные (или непрерывные) признаки также можно анализировать в терминах и понятиях ИЭА. В этом случае, для всего возможного спектра значений, которые может принять признак, устанавливают некую меру точности (Δ х ), в пределах которого состояния системы оказываются практически неразличимы. Тогда непрерывно варьирующую систему можно приближенно свести к дискретной. Это равносильно замене плавной кривой функции плотности распределения f(x) ступенчатой ломаной (по типу гистограммы). В этом случае площади прямоугольников этой гистограммы изображают вероятность принятия системой того или иного состояния. Характерно, что оценка энтропии для количественного признака оказывается совершенно не зависящей от принятой меры точности (Δ х ). От точности измерения зависит только начало отсчета, при котором вычисляется энтропия.

Если система (признак) имеет нормальное распределение (идеальное), то в этом случае ее энтропия, рассчитанная по гистограмме, будет равна:

где σ – среднее квадратичное отклонение анализируемого признака.

Как правило, при сравнении признаков, имеющих различные величины измерения (кг, г, %, см и т.д.), они предварительно подвергаются стандартизации. В этом случае каждое исходное значение в выборке ( x i ) заменяют соответствующей z -величиной:

Характерной особенностью этих трансформированных величин является то, что они имеют среднее арифметическое значение равное 0, а вариансу (и, соответственно, среднее квадратичное отклонение), равную 1:

Вне зависимости от того, чему были равны минимальное и максимальное значения в исходной выборке, для z-трансформированных величин подавляющее большинство значений располагаются в пределах от –3 до +3 (рис. 1).

Рис. 1. График плотности распределения стандартизированных величин

В этом случае (при достаточном объеме выборки, содержащей сотни измерений), удобнее принять величину меры точности одинаковую для всех признаков и равную Δ х = 0,5. Это дает нам 12 интервалов в пределах вариационного ряда. Таким образом, мы принимаем, что k = 12. И вместо плавной графика плотности распределения f(z) мы имеем дело со ступенчатой гистограммой (рис.2).

Рис. 2. Гистограмма выборочного распределения с кривой нормального распределения

Энтропия для такой системы (количественного признака) может быть рассчитана по формуле:

где z i – середина каждого из 12 интервалов, а f(z i ) – функция плотности распределения (относительная частота) для соответствующего значения z i .

Однако в таком случае мы сталкиваемся с одним важным противоречием. По определению понятия энтропии максимальное возможное значение степени организованности такой системы равно (используя формулу 2):

Но, с другой стороны, согласно формуле 4, для идеального нормального распределения, плотность которого оценена по гистограмме с 12 интервалами, эта величина составляет:

Более того, имеется другое, еще более важное противоречие. Дело в том, что любой количественный признак имеет тип распределения более или менее близкий к нормальному (Гаусса-Лапласа):

Однако график плотности нормального распределения имеет колоколообразную форму (рис. 1). Частоты встречаемости величин малы для крайне малых значений, затем плавно повышаются для величин, близких к среднему арифметическому, и снова снижаются в области крайне больших значений (рис. 2). Таким образом, частоты встречаемости разных возможных вариантов признака (состояний системы) при нормальном типе распределения (или близком к нему) различаются. Тогда как, по определению, система достигает максимума своей неопределенности ( Hmax ) только в том случае, когда эти частоты равны. Таким образом, налицо явное противоречие.

Как известно [13] нормальное распределение – это предельный случай биномиального распределения:

когда p = q = 0,5 и n имеет порядок тысяч или десятков тысяч.

С другой стороны, формула 11 описывает частоты генотипов для диаллельной системы в случае ко-доминирования. И в этом случае, величина n соответствует числу пар одновременно учитываемых генов. Если, например, мы рассматривает один ген, то частоты, с которыми будут формироваться фенотипы, будут равны – 1:2:1. Если учитывается два гена одновременно, частоты соответствующих фенотипов будут равны: 1:3:3:1 и т.д. Таким образом, идеальное нормальное распределение соответствует случаю популяции, имеющей максимально возможный уровень гетерозиготности. И только в этом случае уровень дезорганизованности системы (ее энтропия) по определению достигает максимума.

Для того чтобы решить эти противоречия, мы предлагаем следующий выход.

Предлагается оценивать энтропию не для величин плотности распределения z-трансформированных значений исходной выборки, а для интеграла этих оценок, т.е. использовать величины:

График интеграла плотности нормального распределения приведен на рисунке 3.

Рис. 3. Кривая интеграла плотности нормального распределения

Что нам дает этот подход.

Во-первых, новые величины – Ф ( z ) – для любых признаков (имеющие любую размерность) будут варьировать в пределах от 0 до 1. При этом снимается вопрос о выборе нижней границы первого интервала гистограммы. Эта точка всегда равна нулю.

Во-вторых, использование интеграла плотности нормальной кривой приводит к ее сглаживанию; эта особенность интеграла плотности нормального распределения очень часто используется в прикладном статистическом анализе, например, при пробит-анализе [14]. Сглаживание нормальной кривой дает одно важное преимущество, а именно, ее монотоность, т.е. одинаковую величину приращения частоты встречаемости вариант в выборке при увеличении абсолютных значений этих вариант.

Таким образом, гистограмма распределения величин Ф ( z ) будет иметь следующий вид (рис.4). Следовательно, значения интеграла плотности распределения признака будут иметь равномерное распределение. И это распределение будет тем идеальнее приближаться к равномерному, чем ближе исходное эмпирическое распределение к нормальному.

Как известно, для равномерного распределения, изображенного в виде гистограммы с числом интервалов, равным k , энтропия равна значению, приведенному в формуле 2. А это значит: чем ближе распределение исходного признака к нормальному, тем ближе распределение интеграла его плотности к равномерному и, следовательно, энтропия такой системы будет стремиться к своему максимуму. И, наоборот, чем сильнее эмпирическое распределение исходного признака отклоняется от нормального, тем сильнее будет отклоняться от равномерного распределение интеграла его плотности и, соответственно, тем ниже будет значение энтропии этой системы. В крайнем случае, когда все варианты в выборке (или популяции) будут равны, энтропия такой системы, как и следует по определению, будет равна нулю.

Рис. 4. Гистограмма распределения величин интеграла плотности нормального распределения

Число интервалов, на которое можно разбить отрезок [0;1] для интеграла плотности распределения (т.е. k ), зависит от объема выборки. Мы можем предложить такое оптимальное число интервалов, при котором средняя частота попадания величины в любой из них не будет меньше 5-10. Таким образом, для выборок, объемом 100-200 объектов (особей) оптимальным будет 10 интервалов. В этом случае, максимальное значение энтропии такой системы будет равно Hmax = log 2 10 = 3,322 бита. При бóльшем объеме имеющихся выборочных данных, число интервалов может быть увеличено. При меньшем объеме, наоборот, уменьшено (например, до 5).

Поскольку, оценка энтропии производится на основе случайной выборки, то эта оценка имеет свою статистическую ошибку, зависящую, прежде всего, от объема выборки ( n ):

Кроме непосредственных оценок энтропии, могут быть также использованы показатели, производные от нее.

Для определения меры абсолютной организации системы используется величина:

Величину относительной организованности системы оценивают по формуле:

Согласно классификации С.Бира [15], система для которой R ≤0,1 является вероятностной (стохастической); если значение относительной организованности системы R> 0,3, то такая система считается детерминированной. И, наконец, система, для которой 0,1 анэнтропия [16]. Эта величина удовлетворяет функции, которая может служить мерой редкости частот событий:

Величина анэнтропии будет тем выше, чем меньше частоты встречаемости редких вариант в выборке. В том случае, когда частоты встречаемости всех вариант наиболее минимальны (и равны между собой, соответственно), оценка анэнтропии равна нулю. При неравенстве частот вариант, она тем выше, чем реже встречаются самые редкие варианты.

Данная методика, использующая интегральные оценки плотности распределения стандартизированных величин, была применена нами для ИЭА возрастной динамики живой массы орнитологических объектов. Полученные результаты свидетельствуют о перспективности использования данного метода для описания любых количественных признаков биологических объектов.

Почему мы стареем? Нет, не так. Почему мышь стареет в 40 раз быстрее нас? А кит в 2 раза медленнее? Есть ли какой-то фундаментальный закон физики, которым обусловлено старение живых систем?

Странно видеть, что в 21-ом веке ещё есть кто-то, кто до сих пор считает, что в старении повинна “энтропия”, а именно второй постулат термодинамики, в котором говорится, что в изолированных системах энтропия не может понижаться. Кстати это “не может понижаться” почему-то часто трансформируется в “обязана возрастать”. При этом временные сроки, в которые она обязана это делать, не озвучиваются. Ну да ладно, нет смысла пытаться обсуждать оттенки серого, когда перед нами зелёный: организмы не являются изолированными системами. Совсем наоборот, они только и делают, что поглощают энергию извне, используя её на различные нужды, включая снижение своей энтропии. И очень может быть, что отличительная черта живых организмов — более эффективное по сравнению с неживыми системами повышение внешней энтропии, о чём говорят нам гипотезы биофизика Джереми Ингланда (1, 2).

Кстати, физики задавались вопросами взаимоотношений живых систем с энтропией испокон веков — размышления на эти темы встречаются ещё в работах 19-го века, но, наверное, первым глубоким и широкомасштабным анализом стала книга “Что есть жизнь?” одного из известнейших физиков 20-го века, Эрвина Шрёдингера. Хотя в народных массах, думаю, более известен его кот:

В своей книге Шрёдингер отмечал, что одно из ключевых отличий живых систем от неживых состоит в том, что они умеют “создавать порядок из хаоса”, то есть снижать свою энтропию. Он даже выдвинул определение, что жизнь “питается отрицательной энтропией”, хотя потом понял, что сморозил глупость, и многократно разъяснял, что на самом деле жизнь конечно же “питается” свободной энергией, которую тратит на снижение или поддержание на одном уровне своей энтропии, но осадочек — в виде понятия негэнтропии — остался.

Что ж, спасибо физикам, что подвели теоретическую базу под вполне очевидные наблюдения. Да, живые системы, а вернее их гены, отлично научились справляться с энтропией, а именно, используя энергию извне, снижать её во время размножения и поддерживать на низком уровне годами или даже десятилетиями после рождения. Соответственно, единственная причина того, что после определённого возраста энтропия организма начинает повышаться — это то, что генная программа перестаёт должным образом её понижать, а то и вовсе пускает своего репликатора в расход (аки вмч. лосося). Причём для каждого вида этот возраст свой, разнящийся между видами на порядки, что явно говорит о том, что этот процесс обусловлен не каким-то законом физики, а является биологической адаптацией.

Что же мешает генам поддерживать в живых своих репликаторов веками или тысячелетиями? Да ничего не мешает. По-видимому, им это просто не нужно — и так всё неплохо получается. Более того, излишне долгая жизнь репликаторов может наоборот быть даже вредна для долгосрочной выживаемости генов. Ведь кооперативы генов (виды) играют в свои “Голодные игры” не в одиночестве, а в многомиллиардном мультиплейере, где каждое звено в нащупавшей хрупкое временное равновесие пирамиде предации зависит от звеньев под ним. В таких условиях успешное долгосрочное существование вряд ли возможно без многоуровневой кооперации и адаптации ко всей экосистеме в целом.

Кстати, лучшей иллюстрацией скупости генов в дозировании срока жизни своих созданий являются социальные насекомые. Королевская каста у них живет на 1–2 порядка дольше рабочей, при том, что гены у них одинаковые. Недавно вышла очень интересная статья про термитов (которых, к слову, окончательно разжаловали в тараканы), показавшая, что у их королевы механизмы защиты ДНК от транспозонов (вредоносных “прыгающих генов”) одинаково активны и в молодости, и в старости, а вот у рабочих особей эта защита очень быстро выключается. Кстати, те же механизмы защиты (пиРНК) от транспозонов используются и в наших половых клетках, но не в соматических.

Казалось бы, всё понятно — не хотят гены разрешать рабочим особям долго жить. Специально их убивают, попросту говоря. Но нет, жертвы Стокгольмского синдрома найдут оправдание генам-убийцам. “Наверное, слишком энергозатратно поддерживать экспрессию генов защиты от транспозонов во всех термитах”, говорят они:

“It would, after all, probably be too energetically costly to maintain an active piRNA signalling pathway permanently in all the cells of an organism — or in all the individuals of a colony.”

Что значит “слишком энергозатратно”? В королеве, которая попутно откладывает 20 000 яиц в день, не затратно, а в работнике затратно? И о какой энергии речь, о еде? Или опять о неком магическом “ресурсе”, который существует только в фантазиях приверженцев трейд-оффа? Да и где тот трейд-офф, если королева живет 20 лет, а рабочая особь лишь несколько месяцев? Не наблюдается никакого трейд-оффа. И с энтропией как-то проблем у королевы не возникает.

Ещё более вопиющий пример волюнтаризма генов в выборе срока жизни своих созданий — бабочка Монарх. Летом эти бабочки живут лишь несколько недель, а по осени мигрируют на юг на зимовку, и такие мигранты живут до 7 месяцев. Более того, эти самые мигранты сначала совершают перелёт длиной в тысячи километров, а весной летят обратно, причём в обратный путь самки пускаются беременными.

Самое интересное, что за огромную разницу в продолжительности жизни (ПЖ) между мигрантами и немигрантами у Монархов отвечает один-единственный гормон JH1 из семейства “ювенильных гормонов”. Если ввести его бабочкам в лабораторных условиях, они живут в 2 раза меньше контрольных, а если наоборот блокировать его выработку, то бабочки живут в 1,5 раза дольше. На графиках ниже видна огромная разница (в 3 раза!) в медианной ПЖ между теми, кто получал JH1 дополнительно (синие кривые) и теми, у кого его выработка блокировалась (красные). Верхний ряд — самки, нижний — самцы.

Кстати, ювенильные гормоны отвечают за развитие у очень многих насекомых, включая социальных. Скорее всего, именно они во время развития определяют у пчёл кому стать королевой, а кому работником.

Так что на термодинамику гены нашли управу давным-давно. И тот факт, что они могут поддерживать энтропию организма на достаточно низком уровне, чтобы позволить королеве жить 20 лет, но не используют это умение для работника, означает лишь то, что генам это попросту невыгодно, а не теоретически невозможно.

Более того, свою собственную энтропию гены поддерживают на низком уровне уже миллиарды лет. И мы с вами как раз тот инструмент, который помогает им в этой смертельной схватке. Только “Fatality!” выпадает практически исключительно на нашу долю, то есть именно наша смертность обеспечивает генам бессмертие. Не знаю как вам, а мне надоела такая ситуация. Я в репликаторы-камикадзе не нанимался. Поэтому считаю, что нужно срочно делать всё возможное, чтобы сбросить иго генов, и освободить наши личности от уз биологии. Гены геть!

Прежде чем рассматривать следующие этапы развития системного подхода и системных исследований, необходимо объяснить и уточнить некоторые понятия, которые мы уже упоминали и будем использовать в дальнейшем. Проникновение методов теории информации в физику, биологию и другие области естествознания показало тесную взаимосвязь понятия количества информации с естественно-научным понятием “энтропия”.

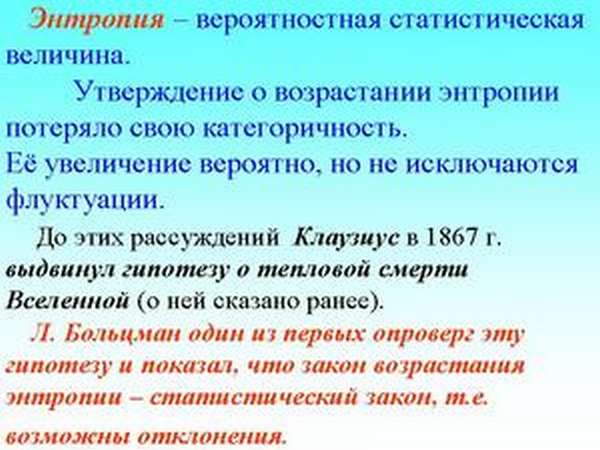

Понятие энтропия, первоначально введенное Р. Клаузисом лишь с целью более удобного описания работы тепловых двигателей, усилиями многих ученых, и прежде всего Л. Больцмана, стало играть универсальную роль, определяя многие закономерности в поведении макроскопических систем. В 30-е годах нашего столетия энтропия стала мерой вероятности информационных систем и явилась основой теории информации (работы Л. Сцилларда, К. Шеннона)

Связь между энтропией и вероятностью установлена Л. Больцманом и выражается знаменитой формулой, носящей имя этого ученого:

где H - энтропия, W - термодинамическая вероятность состояния.

Существенно, что Больцман, связав второй принцип термодинамики с теорией вероятности, показал, что убывание энтропии не является невозможным, а только маловероятным. Второй принцип термодинамики становится констатацией того факта, что информация теряется различными способами, что ведет к увеличению энтропии системы, но, чтобы приобрести новую информацию и уменьшить энтропию, следует произвести новые измерения, т.е. затратить энергию

В конце 40-х годов Э. Шредингер, а затем и Н. Винер существенно расширили понятие энтропии - до понимания ее как меры дезорганизации систем любой природы. Эта мера простирается от максимальной энтропии (H=1), т.е. хаоса, полной неопределенности, до исчезновения энтропии (H=0), соответствующего наивысшему уровню организации, порядка.

Таким образом, можно выделить следующие этапы развития понятия энтропии, где она выступает как:

| * мера рассеяния тепловой энергии в замкнутой термодинамической системе | - | Клаузис, Больцман (1852 год) |

| * мера вероятности информационных систем (мера количества информации) | - | Сциллард, Шеннон (1929 год) |

| * мера дезорганизации систем любой природы | - | Шредингер, Винер (!944 год) |

С помощью энтропии стало возможно количественно оценивать на первый взгляд качественные понятия, как “хаос” и “порядок”. Информация и энтропия связаны потому, что они характеризуют реальную действительность с точки зрения именно упорядоченности и хаоса, причем если информация - мера упорядоченности, то энтропия - мера беспорядка; одно равно другому, взятому с обратным знаком. Например, если на предприятии низка трудовая и технологическая дисциплина, идет брак, то мы можем утверждать, что здесь низок уровень организации, или велика энтропия. Она угрожающе растет ныне и в нашей экономике, социальной жизни.

Энтропия и информация служат, таким образом, выражением двух противоположных тенденций в процессах развития. Альтернативность и взаимосвязь понятий энтропии и информации нашли отражение в формуле

Если система эволюционизирует в направлении упорядоченности, то ее энтропия уменьшается. Но это требует целенаправленных усилий, внесения информации, т.е. управления. “Мы плывем вверх по течению, борясь с огромным потоком дезорганизованности, который, в соответствии со вторым законом термодинамики, стремится все свести к тепловой смерти - всеобщему равновесию и одинаковости, т.е. энтропии. В мире, где энтропия в целом стремится к возрастанию, существуют местные временные островки уменьшающейся энтропии, это области прогресса. Механизм их возникновения состоит в естественном или целенаправленном отборе устойчивых форм. Человек всю жизнь борется с энтропией, гася ее извлечением из окружающей среды отрицательной энтропии – информации” [3].

Количество информации, отождествляемое Винером с отрицательной энтропией (негэнтропией), становится, подобно количеству вещества или энергии, одной из фундаментальных характеристик явлений природы. Введение понятия энтропии в теорию информации явилось, по выражению Бройля, “наиболее важной и красивой из идей, высказанных кибернетикой”, и рассматривается как большой вклад XX века в научную мысль [4]. Это положение называют еще вторым “краеугольным камнем” кибернетики. Отсюда - толкование кибернетики как теории организации, теории борьбы с мировым хаосом, с роковым возрастанием энтропии.

Кибернетика Винера

По настоящему явное и массовое усвоение системных понятий, общественное осознание системности мира, общества и человеческой деятельности началось с 1948 года, когда американский математик Н. Винер опубликовал книгу под названием “Кибернетика”. Первоначально он определил кибернетику как “науку об управлении и связи в животных и машинах”. Однако очень быстро стало ясно, что такое определение неоправданно сужает сферу приложения кибернетики. Уже в следующей книге Н. Винер анализирует с позиций кибернетики процессы, происходящие в обществе.

Здесь мы не случайно говорим “кибернетика Винера”, так как понятие “кибернетика” имеет более давнюю историю и, на уровне терминологии, было использовано еще древнегреческим философом Платоном. Он предлагал называть кибернетикой науку об административном управлении провинциями, т.е. уже тогда, по крайней мере, на уровне терминологии, кибернетика связывалась с управлением процессами, протекающими в обществе. Позже аналогичные предложения исходили и от других ученых (Ампер, Трентовский) [5] и об этом мы будем говорить при рассмотрении организационных систем. Поэтому, говоря о кибернетике Винера, мы имеем в виду современную кибернетику, которая рассматривается уже на уровне самостоятельной науки.

Сначала кибернетика Винера привела многих ученых в замешательство: оказалось, что кибернетики берутся за рассмотрение и технических, и биологических, и экономических, и социальных объектов и процессов. Возник даже спор - имеет ли кибернетика свой предмет исследования. Первый международный конгресс по кибернетике (Париж, 1956) даже принял предложение считать кибернетику не наукой, а “искусством эффективного действия”. В нашей стране кибернетика была встречена настороженно и даже враждебно (кибернетика была объявлена идеалистической лженаукой).

По мере развития кибернетики, уточнения ее понятий, разработки ее собственных методов, получения конкретных результатов в разных областях стало очевидным, что кибернетика - это самостоятельная наука, со своим, характерным только для нее предметом изучения, со своими специфическими методами исследования. В становление кибернетики внесли вклад и известные отечественные ученые. Важную роль сыграли определения, сформулированные в период горячих дискуссий о сути кибернетики: кибернетика - это наука об оптимальном управлении сложными динамическими системами (А.И. Берг); кибернетика - это наука о системах, воспринимающих, хранящих, перерабатывающих и использующих информацию (А.Н. Колмогоров). Эти определения признаны достаточно общими и полными и из них видно, что предметом кибернетики является исследование систем. Важно подчеркнуть, что, хотя при изучении системы на каком-то этапе потребуется учет ее конкретных свойств, для кибернетики в принципе неважно, какова природа этой системы, т.е. является ли она физической, биологической, экономической, организационной или даже воображаемой, нереальной системой. Это делает понятным, почему кибернетика “вторгается” в совершенно разнородные сферы. То, что кибернетические методы могут применяться к исследованию объектов, традиционно “закрепленных” за той или иной наукой, должно рассматриваться не как “постороннее вмешательство неспециалистов”, а как рассмотрение этих объектов с другой точки зрения. Более того, при этом происходит взаимное обогащение кибернетики и других наук. С одной стороны, кибернетика получает возможность развивать и совершенствовать свои модели и методы, с другой - кибернетический подход к системе определенной природы может прояснить некоторые проблемы данной науки или даже выдвинуть перед ней новые проблемы, а главное - содействовать повышению ее системности.

С кибернетикой Винера связаны значительные продвижения в развитии системных представлений, которые, без преувеличения, сыграли революционизирующую роль в развитии общественного сознания, человеческой практики и культуры, подготовили почву для того невиданного ранее размаха компьютеризации, которая происходит на наших глазах.

Синергетика

Синергетика в переводе с греческого означает “совместный согласованно действующий”. Применительно к современному естествознанию этот термин появился в 70-х годах и принадлежит немецкому физику Герману Хакену. “Я назвал новую дисциплину “синергетикой” не только потому, что в ней исследуется совместное действие многих элементов систем, но и потому, что для нахождения общих принципов, управляющих самоорганизацией, необходимо кооперирование различных дисциплин” [6].

Проблемы синергетики многоплановы и предполагают несколько направлений их решения. В работах Г.Хакена излагаются принципы, позволяющие в рамках единого подхода рассматривать широкий класс явлений самоорганизации, происходящих как в мире живого, так и неорганическом мире. Особое значение при этом придается роли коллективных кооперативных эффектов в процессах самоорганизации. Появление нового научного направления было подготовлено широким кругом специалистов различных областей. Заметную роль в этом плане играли работы И.Пригожина и его коллег, посвященные разработке методов термодинамического анализа явлений самоорганизации. И.Пригожин положил в основу неравновесной динамики принцип наименьшего производства энтропии, что в сочетании с принципом о наименьшем рассеянии энергии позволило усилить мощь аналитического аппарата термодинамического аспекта явлений самоорганизации [7].

Не меньшую, чем неравновесная термодинамика, роль в изучении процессов самоорганизации и анализе диссипативных структур получили теория информации и теория оптимизации. Информацию легко выразить через энтропию и наоборот, причем связь эта не формальна. Если в термодинамике энтропия – это мера беспорядка, то в теории информации – это мера недостатка информации в системе, мера неопределенности.

До середины 70-х годов нашего столетия существовал непреодолимый барьер между неорганической и живой природой. Считалось, что лишь живой природе присущи саморегуляция и самоорганизация. Правда, некоторые отечественные естествоиспытатели и философы еще в 60-е годы высказывали предположения о наличии процессов самоорганизации и в неорганической природе. Так, Л.А. Петрушенко [8] рассматривал природу как некое связное целое, состоящее из различным образом организованных систем и способное к самоорганизации или, наоборот, к самодезорганизации, обусловленной возрастанием энтропии (неопределенности).

Последние фундаментальные достижения в области исследования систем принадлежат бельгийской школе ученых во главе с И Пригожиным. Изучая термодинамику неравновесных физических систем (за результаты этих исследований Пригожину присуждена Нобелевская премия по химии 1977 года), он вскоре понял, что обнаруженные им закономерности относятся к системам любой природы. Именно работы Пригожина и его последователей способствовали возникновению новой науки, названной Г. Хакеном синергетикой, устанавливающей универсальность явления самоорганизации и распространяющих их на неживую природу. В синергетике, в отличие от кибернетики, акцент делается не на процессы управления и обмена информацией, не на функционировании систем, а на ее структуре, на принципах построения организации, на условиях ее возникновения, развития и самоусложнения.

Наряду с подтверждением уже известных положений (иерархичность уровней организации систем; несводимость друг к другу и невыводимость друг за друга закономерностей разных уровней организации; наличие наряду с детерминированными случайных процессов на каждом уровне организации и др.) основоположники синергетики предложили новую, оригинальную теорию системодинамики. Отметим, что наибольший интерес и внимание привлекли те ее моменты, которые раскрывают механизм самоорганизации систем. Согласно теориям синергетики, материя не является пассивной субстанцией; ей присуща спонтанная активность, вызванная неустойчивостью неравновесных состояний, в которые рано или поздно приходит любая система в результате взаимодействия с окружающей средой. Важно, что в такие переломные моменты (называемые “особыми точками” или “точками бифуркации”) принципиально невозможно предсказать, станет ли система менее организованной или более организованной (“диссипативной”, по терминологии Пригожина).

Синергетика исследует особые состояния сложных систем в области неустойчивого равновесия, точнее - динамику их самоорганизации вблизи точек бифуркации, когда даже малое воздействие может привести к непредсказуемому, быстрому (“лавинообразному”) развитию процесса. Говоря о самоорганизации сложных систем, мы подчеркивали их стремление к негэнтропийной (“неравновесной”) устойчивости, как их ведущую тенденцию как можно дальше отдаляться от состояния “равновесия”, т.е. уровня максимальной энтропии, хаоса. Сохранение своей целостности, гомеостатической устойчивости является главным свойством всех систем макроструктуры природы. Биологические и социальные системы в нормальных условиях развития являются относительно устойчивыми, длительное время повышают уровень своей организации, не разрушаются.

Но когда по истечении, например, биологического цикла организм стареет, разрушается и погибает, он достигает максимального значения энтропии, хаоса. Такой хаос, действительно, пугает. Он всецело деструктивен и не может выступать в качестве создающего начала, из него не может развиваться новая организация.

Толкование понятия “хаос” создателями синергетики существенно отличается от общепринятого понимания хаоса как максимума энтропии. В синергетике хаос больше ассоциируется с понятием случайности, с хаотическим разнообразием флуктуаций в сложной системе, хаотическими отклонениями каких-то параметров от нормы. В основе такого хаоса возможно активное начало, причем в определенных условиях даже единичное отклонение, малое воздействие какого-то параметра может стать существенным для макропроцесса: может развиться новая организация[9]. Например, в состоянии неустойчивости социальной среды деятельность каждого отдельного человека может влиять на макроскопический процесс (роль личности в истории). Отсюда вытекает необходимость осознания каждым человеком огромного груза ответственности за судьбу всей социальной системы, всего общества. Человек - активное начало. Его поведение определяют явно осознаваемые и скрытые подсознательные установки. Потенциал выдающегося индивида может проявиться в открытом обществе, особенно в режиме его неустойчивости. Открытость системы - необходимое, но не достаточное условие для ее самоорганизации. Все зависит от соотношения потенциалов индивида и среды, от характера взаимодействий, а порой от игры случая, от информированности противоположных начал.

Существовавшая в нашей стране командно-административная система, как сугубо закрытое, жестко детерминированное образование с людьми-винтиками в своей основе, показала тупиковую ветвь эволюции. Она гасила инициативу, проявления активности (флуктуации), изжила предпринимательство, лишила себя возможности отбора лучшего. Когда инициатива наказуема, любое малое возмущение “сваливается” на то же самое решение, на ту же самую структуру. И ничего не меняется. Значит, без неустойчивости нет развития, утверждают синергетики, развитие происходит через неустойчивость, через бифуркации, через случайность.

В своей работе “Философия нестабильности” И. Пригожин освобождает понятие нестабильности от негативного оттенка. Нестабильность не всегда зло, подлежащее устранению, или же некая досадная неприятность. Нестабильность способствует выявлению и отбору всего лучшего.

Установленное кибернетикой и синергетикой единство процессов управления и самоорганизации в системах разной природы имеет огромное мировоззренческое и практическое значение, поскольку дает ясную, по существу, единую методологию деятельности человека. Роль научного управления в жизни общества, особенно в социально-экономической сфере, весьма велика. Высокая эффективность западной экономики держится на научном управлении, на непрерывном стремлении его оптимизировать, насыщать информацией, знаниями.

Некомпетентность управляющих - ахиллесова пята нашей экономики. Неадекватность многих принимаемых (на всех уровнях) решений оборачивается для страны огромными потерями.

Что такое энтропия? Этим словом можно охарактеризовать и объяснить почти все процессы в жизни человека (физические и химические процессы, а также социальные явления). Но не все люди понимают значение этого термина и уж тем более не все могут объяснить, что это слово значит. Теория сложна для восприятия, но если добавить в неё простые и понятные примеры из жизни, то разобраться с определением этого многогранного термина будет легче. Но обо всём по порядку.

- Энтропия: определение и история появления термина

- История появления термина

- Определение термина из Википедии

- Виды энтропий

- В физической химии (термодинамике)

- В экономике

- В статистической физике или теории информации

- В социологии

- Энтропия: тезисно и на примерах

- В заключение

Энтропия: определение и история появления термина

История появления термина

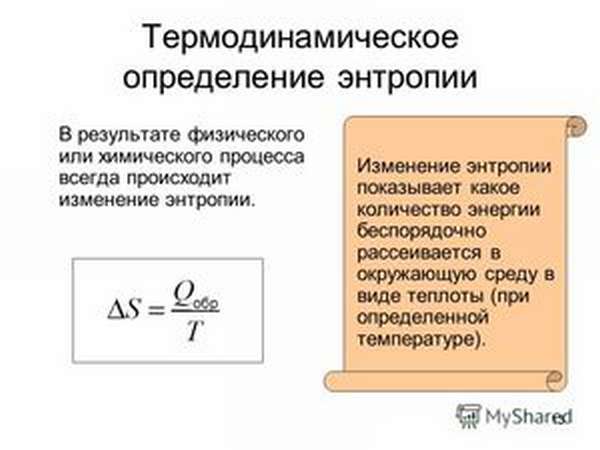

Энтропия как определение состояния системы была введена в 1865 году немецким физиком Рудольфом Клаузиусом, чтобы описать способность теплоты превращаться в другие формы энергии, главным образом в механическую. С помощью этого понятия в термодинамике описывают состояние термодинамических систем. Приращение этой величины связано с поступлением тепла в систему и с температурой, при которой это поступление происходит.

Определение термина из Википедии

Виды энтропий

Этот термин используется в термодинамике, экономике, теории информации и даже в социологии. Что же он определяет в этих областях?

В физической химии (термодинамике)

Основной постулат термодинамики о равновесии: любая изолированная термодинамическая система приходит в равновесное состояние с течением времени и не может из него выйти самопроизвольно. То есть каждая система стремится в равновесное для неё состояние. И если говорить совсем простыми словами, то такое состояние характеризуется беспорядком.

Энтропия — это мера беспорядка. Как определить беспорядок? Один из способов — приписать каждому состоянию число вариантов, которыми это состояние можно реализовать. И чем больше таких способов реализации, тем больше значение энтропии. Чем больше организованно вещество (его структура), тем ниже его неопределённость (хаотичность).

Абсолютное значение энтропии (S абс.) равно изменению имеющейся у вещества или системы энергии во время теплопередачи при данной температуре. Его математическая величина определяется из значения теплопередачи (Q), разделённого на абсолютную температуру (T), при которой происходит процесс: S абс. = Q / T. Это означает, что при передаче большого количества теплоты показатель S абс. увеличится. Тот же эффект будет наблюдаться при теплопередаче в условиях низких температур.

В экономике

В экономике используется такое понятие, как коэффициент энтропии. С помощью этого коэффициента исследуют изменение концентрации рынка и её уровень. Чем выше значение коэффициента, тем выше экономическая неопределённость и, следовательно, вероятность появления монополии снижается. Коэффициент помогает косвенно оценить выгоды, приобретённые фирмой в результате возможной монопольной деятельности или при изменении концентрации рынка.

В статистической физике или теории информации

Информационная энтропия (неопределённость)— это мера непредсказуемости или неопределённости некоторой системы. Эта величина помогает определить степень беспорядочности проводимого эксперимента или события. Чем больше количество состояний, в которых может находиться система, тем больше значение неопределённости. Все процессы упорядочивания системы приводят к появлению информации и снижению информационной неопределённости.

С помощью информационной непредсказуемости можно выявить такую пропускную способность канала, которая обеспечит надёжную передачу информации (в системе закодированных символов). А также можно частично предсказывать ход опыта или события, деля их на составные части и высчитывая значение неопределённости для каждой из них. Такой метод статистической физики помогает выявить вероятность события. С его помощью можно расшифровать закодированный текст, анализируя вероятность появления символов и их показатель энтропии.

Существует такое понятие, как абсолютная энтропия языка. Эта величина выражает максимальное количество информации, которое можно передать в единице этого языка. За единицу в этом случае принимают символ алфавита языка (бит).

В социологии

Здесь энтропия (информационная неопределённость) является характеристикой отклонения социума (системы) или его звеньев от принятого (эталонного) состояния, а проявляется это в снижении эффективности развития и функционирования системы, ухудшении самоорганизации. Простой пример: сотрудники фирмы так сильно загружены работой (выполнением большого количества отчётов), что не успевают заниматься своей основной деятельностью (выполнением проверок). В этом примере мерой нецелесообразного использования руководством рабочих ресурсов будет являться информационная неопределённость.

Энтропия: тезисно и на примерах

- Чем больше способов реализации, тем больше информационная неопределённость.

Пример 1. Программа Т9. Если в слове будет небольшое количество опечаток, то программа легко распознает слово и предложит его замену. Чем больше опечаток, тем меньше информации о вводимом слове будет у программы. Следовательно, увеличение беспорядка приведёт к увеличению информационной неопределённости и наоборот, чем больше информации, тем меньше неопределённость.

Пример 2. Игральные кости. Выкинуть комбинацию 12 или 2 можно только одним способом: 1 плюс 1 или 6 плюс 6. А максимальным числом способов реализуется число 7 (имеет 6 возможных комбинаций). Непредсказуемость реализации числа семь самая большая в этом случае.

- В общем смысле энтропию (S) можно понимать как меру распределения энергии. При низком значении S энергия сконцентрирована, а при высоком — распределена хаотично.

Пример. Н2О (всем известная вода) в своём жидком агрегатном состоянии будет обладать большей энтропией, чем в твёрдом (лёд). Потому что в кристаллическом твёрдом теле каждый атом занимает определённое положение в кристаллической решётке (порядок), а в жидком состоянии у атомов определённых закреплённых положений нет (беспорядок). То есть тело с более жёсткой упорядоченностью атомов имеет более низкое значение энтропии (S). Белый алмаз без примесей обладает самым низким значением S по сравнению с другими кристаллами.

Пример 1. Молекула находится в сосуде, который имеет левую и правую часть. Если неизвестно, в какой части сосуда находится молекула, то энтропия (S) будет определяться по формуле S = S max = k * lgW, где k -число способов реализации, W- количество частей сосуда. Информация в этом случае будет равна нулю I = I min =0. Если же точно известно, в какой части сосуда находится молекула, то S = S min =k*ln1=0, а I = I max= log 2 W. Следовательно, чем больше информации, тем ниже значение информационной неопределённости.

Пример 3. Информация о классе больше на уроке, чем на перемене. Энтропия на уроке ниже, так как ученики сидят упорядочено (больше информации о местоположении каждого ученика). А на перемене расположение учеников меняется хаотично, что повышает их энтропию.

Пример. При реакции щелочного металла с водой выделяется водород. Водород-это газ. Так как молекулы газа движутся хаотично и имеют высокую энтропию, то рассматриваемая реакция происходит с увеличением её значения. То есть энтропия химической системы станет выше.

В заключение

Если объединить всё вышесказанное, то получится, что энтропия является мерой беспорядка или неопределённости системы и её частей. Интересен тот факт, что всё в природе стремится к максимуму энтропии, а человек — к максимуму информации. И все рассмотренные выше теории направлены на установление баланса между стремлением человека и естественными природными процессами.

Читайте также: