Принцип работы поисковых систем кратко

Обновлено: 06.07.2024

Основная задача оптимизации сайта это повышение позиций сайта в поисковой выдаче поисковых систем. Позиции сайта в выдаче определяются согласно алгоритмам поисковых систем. По алгоритмам, поисковики собирают нужные страницы сайтов, обрабатывают их и заносят в базу поисковой выдаче, ранжируя по соответствию поисковым запросам.

SEO оптимизация сайта

Цель SEO оптимизации сайта, повышение позиций страниц сайта в поисковой выдаче поисковых систем. Всем знакомы названия популярных поисковых систем мира: Google, Yahoo, MSN и Рунета: Яндекс, Рамблер, Апорт. Именно, поисковые системы, осуществляют поиск в сети по запросу пользователя, выявляя по своим алгоритмам, наиболее подходящие страницы сайтов.

Работа поисковых систем основана на взаимосвязанной работе нескольких специальных программ. Перечислим основные компоненты поисковых систем и их принципы работы.

Каждая поисковая система имеет свой алгоритм поиска запрашиваемой пользователем информации. Алгоритмы эти сложные и чаще держатся в секрете. Однако общий принцип работы поисковых систем можно считать одинаковым. Любой поисковик:

- Сначала собирает информацию, черпая её со страниц сайтов и вводя её в свою базы данных;

- Индексирует сайты и их страницы, и переводит их из базы данных в базу поисковой выдачи;

- Выдает результаты по поисковому запросу, беря их из базы проиндексированных страниц;

- Ранжирует результаты (выстраивает результаты по значимости).

Как работают поисковики

Всю работу поисковых систем выполняют специальные программы и комбинации этих программ. Перечислим основные составляющие алгоритмов поисковых систем:

Реализация механизмов поиска у поисковиков может быть самая различная. Например, комбинация программ Spider+ Crawler+ Indexer может быть создана, как единая программа, скачивающая и анализирующая веб-страницы и находящая новые ресурсы по найденным ссылкам. Тем не менее, нижеупомянутые общие черты программ присущи всем поисковым системам.

Программы поисковых систем

Spider

Crawler

Indexer

Программа Indexer (индексатор) делит страницу на составные части, далее анализирует каждую часть в отдельности. Выделению и анализу подвергаются заголовки, абзацы, текст, специальные служебные html-теги, стилевые и структурные особенности текстов, и другие элементы страницы. Именно, поэтому, нужно выделять заголовки страниц и разделов мета тегами (h1-h4,h5,h6), а абзацы заключать в теги

Database

База данных поисковых систем хранит все скачанные и анализируемые поисковой системой данные. В базе данных поисковиков хранятся все скачанные страницы и страницы, перенесенные в поисковой индекс. В любом инструменте веб мастеров каждого поисковика, вы можете видеть и найденные страницы и страницы в поиске.

Search Engine Results Engine

Search Engine Results Engine это инструмент (программа) выстраивающая страницы соответствующие поисковому запросу по их значимости (ранжирование страниц). Именно эта программа выбирает страницы, удовлетворяющие запросу пользователя, и определяет порядок их сортировки. Инструментом выстраивания страниц называется алгоритм ранжирования системы поиска.

Важно! Оптимизатор сайта, желая улучшить позиции ресурса в выдаче, взаимодействует как раз с этим компонентом поисковой системы. В дальнейшем все факторы, которые влияют на ранжирование результатов, мы обязательно рассмотрим подробно.

Web server

Web server поисковика это html страница с формой поиска и визуальной выдачей результатов поиска.

Повторимся. Работа поисковых систем основана на работе специальных программ. Программы могут объединяться, компоноваться, но общий принцип работы всех поисковых систем остается одинаковым: сбор страниц сайтов, их индексирование, выдача страниц по результатам запроса и ранжирование выданных страниц по их значимости. Алгоритм значимости у каждого поисковика свой.

Поисковые системы (ПС) уже давно являются обязательной частью интернета и нашей повседневной жизни. Сегодня они громадные и сложнейшие механизмы, которые представляют собой не только инструмент для нахождения любой необходимой информации, но и довольно увлекательные сферы для бизнеса.

Многие пользователи поиска никогда не думали о принципах их работы, о способах обработки пользовательских запросов, о том, как построены и функционируют данные системы. Данный материал поможет людям, которые занимаются оптимизацией и продвижение своих сайтов, понять устройство и основные функции поисковых машин.

Функции и понятие ПС

Рассмотрим поподробнее само значение запроса для поиска, взяв для примера систему Яндекс.

Для того чтобы получить правильные ответы на подобные вопросы, разработчики поиска постоянно улучшают принципы ранжирования и его алгоритмы, добавляют им новые возможности и функции и любыми средствами пытаются сделать быстрее работу системы.

Основные характеристики поисковых систем

Полнота.

Точность.

Актуальность.

Это значимая составляющая поиска, которую характеризует время, проходящее с момента опубликования информации в интернете до занесения ее в индексную базу поисковика.

Скорость поиска.

Наглядность.

Наглядное представление результатов является важнейшим элементом удобства поиска. По множеству запросов поисковая система находит тысячи, а в некоторых случаях и миллионы разных документов. Вследствие нечеткости составления ключевых фраз для поиска или его не точности, даже самые первые результаты запроса не всегда имеют только нужные сведения.

Это значит, что человеку часто приходится осуществлять собственный поиск среди предоставленных результатов. Разнообразные компоненты страниц выдачи ПС помогают ориентироваться в поисковых результатах.

История развития поисковых систем

Когда интернет только начал развиваться, число его постоянных пользователей было небольшим, и объем информации для доступа был сравнительно невеликим. В основном доступ к этой сети имели лишь специалисты научно-исследовательских сфер. В то время, задача нахождения информации не была столь актуальна как сейчас.

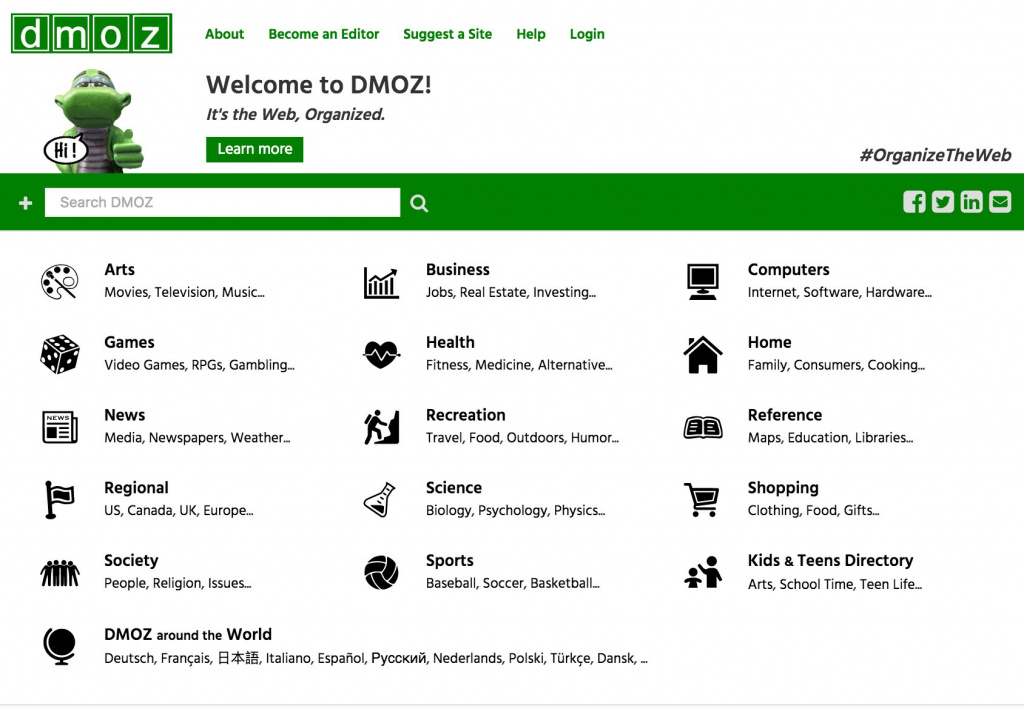

Ведь даже сегодняшние, громадные по своим объемам каталоги имеют информацию о незначительно части сайтов в интернете. Самым известным и большим каталогом в мире был DMOZ (прекратил работу 14 марта 2017 года) имеет информацию о пяти миллионах сайтов, когда база Google содержит информацию о более чем 25 миллиардов страниц.

Самой первой настоящей поисковой системой стала WebCrawler, возникшая еще в 1994-ом году.

В следующем году появились AltaVista и Lycos. Причем первая была лидером по поиску информации очень длительное время.

В 1997-ом году Сергей Брин вместе с Ларри Пейджем создал машину поисковую Google как исследовательский проект в Стэндфордском университете. Сегодня именно Google, самая востребованная и популярная поисковая система в мире.

В сентябре 1997-ом году была анонсирована (официально) ПС Yandex, которая в настоящий момент является самой популярной системой поиска в Рунете.

Доля поисковых систем

- Google — 70,83 %;

- Bing — 12,61 %;

- Baidu — 11,83 %;

- Yahoo! — 2,30 %;

- Яндекс — 1,41 %;

- DuckDuckGo — 0,42 %;

Принципы работы поисковой системы

Модуль индексирования.

Данный компонент состоит из трех программ-роботов:

Crawler, исследуя найденные ссылки, ищет новые документы, еще не ставшие известными поисковой системе.

Indexer (робот-индексатор) – это программа, анализирующая страницы, которые скачали пауки.

Индексатор полностью разбирает страницу на составные элементы и проводит их анализ, применяя свои морфологические и лексические виды алгоритмов.

Анализ проводится над разнообразными частями страницы, такими как заголовки, текст, ссылки, стилевые и структурные особенности, теги html и др.

Таким образом, модуль индексирования дает возможность проходить по ссылкам заданного количества ресурсов, скачивать страницы, извлекать ссылочную массу на новые страницы из полученных документов и делать подробный их анализ.

База данных

База данных (или индекс поисковика) - комплекс хранения данных, массив информации в котором сохраняются определенным образом переделанные параметры каждого обработанного модулем индексации и скачанного документа.

Поисковый сервер

Это самый важный элемент всей системы, потому что от алгоритмов, лежащих в основе ее функциональности, прямо зависит скорость и, конечно же, качество поиска.

Поисковые системы

Порядка 95% интересующей пользователя информации в интернете он находит в поисковых сервисах, Google, Yandex, Bing, Yahoo, DuckDuckGo и т.д (Смотрите — Рейтинг поисковых систем интернета). Но сам сайт, где вводится запрос — это лишь обертка, под которой скрывается сложный программно-аппаратный комплекс, анализирующий миллиарды сайтов ежедневно и составляющий на их основе базы данных. В статье я расскажу, как работают алгоритмы поисковых систем, как именно идет поиск и ранжирование нужной информации и почему мы так быстро получаем ответ на свои запросы.

Работа поисковых систем

Условно считается, что история создания поисковых систем берет свое начало с 1989 года. Именно тогда был создан сервис Арчи, главная задача которого была индексация информации, которую можно найти в интернете (в пространстве WWW). Система изобретена и создана программистом Аланом Эмтеджем. И алгоритмы, которые он в ней использовал, в базовом понимании используются и по сегодняшний день. Правда, данный сервис был локальным.

А уже в 1996 году была создана программа BackRub. Её главное преимущество — она выполняет глобальную индексацию. Уже в 1998 году система будет переименована в Google. А сейчас это — самый популярный сервис в мире для поиска информации в интернете (по данным аналитиков, его использует порядка 85% всех интернет-пользователей).

Общий принцип работы любой поисковой системы условно можно разделить на следующие этапы:

- Сбор информации. Специальная программа сканирует веб-пространство, открывает каждый доступный для неё сайт и анализирует его по заданным алгоритмам.

- Все документы закачиваются на сервер поисковой системы и создается база данных, которая содержит информацию о сайте.

- На основе полученных по сайту данных проводится построения индекса. То есть определяется, какие данные на нём содержатся, к какой группе запросов относятся данный контент их можно отнести и так далее.

- Программа определяет релевантность страницы, в момент когда она получает пользовательский поисковый запрос, на его основе предоставляет перечень сайтов, которые по результатам индексирования содержат запрашиваемую информацию.

- Сервис проводит ранжирование результатов выдачи. То есть выстраивает порядок ссылок, которые будут показаны пользователю, отправившему запрос.

Описанный принцип работы информационно поисковых систем — это лишь условное пояснение, как работает тот же Google или Яндекс. Но вот алгоритмы, которые они используют для обхода, сайтов, индексации и ранжирования, обычным пользователям неизвестны, каждая поисковая система применяет свои алгоритмы и постоянно их совершенствует, так как обработка информации занимает большое количество ресурсов сервера, расходы на который лежат на поисковой системе.

Понятно лишь одно — каждый сайт анализируется по более чем 1000 критериев. И именно благодаря этому пользователь, отправивший поисковый запрос, в 99% случаев в ответ получает ссылку, на страницу с полезной информацией.

Поисковые системы бывают нескольких подвидов и существуют и другие вариации таких сервисов:

- управляемые человеком (то есть каталог сайтов, каждый пункт которого и общая их база данных сформированы вручную пользователем, яркий пример каталог Rambler, );

- гибридные поисковые системы (где часть работы выполняет человек, часть — программа,принцип работы поисковой системы Google как раз таковой);

- мета-системы (которые не составляют базу данных, а дают результат сразу из нескольких поисковых сервисов пример Vivisimo).

И многие рядовые пользователи ошибочно полагают, что особенности работы поисковых систем таковы, что поиск оптимальных результатов для выдачи выполняется в режиме реального времени. Нет, выполнить анализ значительной части веб-пространства за несколько секунд — невозможно. Даже суперкомпьютерам для этого понадобится несколько месяцев, а то и лет. Поэтому без предварительной обработки информации, и постоянного ранжирования не обойтись.

Общие принципы обработки информации

Spider

Робот закачивающий веб страницы на сервер, он скачивает интернет-сайт, что в дальнейшем будет проиндексирован. Причем, загружает он все страницы и готовит полученные данные для анализа следующей программой. Если пользователя на загружаемом сайте интересует только контент (текст, картинки, мультимедиа), то spider работает именно с исходным кодом и html документами.

Crawler

Indexer

Программа которая проводит индексацию, всех полученных данных от Spider и Crawler. То есть делит загруженную страницу на составные части (по html-тегам) и формирует список данных, которые здесь представлены.

Database

Вторая база данных — это результаты индексации. Та самая информация, на основе которой определяется условный рейтинг сайта, а также составляется перечень поисковых запросов, в ответ на которые можно предоставить ссылку.

Search Engine Results Engine

Алгоритм, который выполняет окончательное ранжирование сайтов при получении конкретного поискового запроса. Именно этот алгоритм выбирает ссылки, которые будут показаны пользователю, а также определяет режим их сортировки с 1 места по 10 место , и так 100 места.

Web server

Сервер, на котором хранится сайт поискового сервиса. Именно его открывает пользователь, там же он вводит свой запрос и просматривает результаты выдачи.

Принципы работы поисковой системы

Сбор данных

После создания сайта и получения на него ссылки, система автоматически анализирует его с помощью инструментов Spyder и Crawling. Информация собирается и систематизируется из каждой страницы.

Индексация

Индексация выполняется с определенной периодичностью. И по её прохождению сайт добавляется в общий каталог поисковой системы. Результата этого процесса — создание файла индекса, который используется для быстрого нахождения запрашиваемой информации на ресурсе.

Обработка информации

Система получает пользовательский запрос, анализирует его. Определяются ключевые слова, которые в дальнейшем и используются для поиска по файлам индекса. Из базы данных извлекаются все документы, схожие на пользовательский запрос.

Ранжирование

Из всех документов, отобранных для выдачи, составляется список, где каждому сайту отведена своя позиция. Выполняется на основании ранее вычисленных показателей релевантности.

На этом этапе принцип работы поисковых систем немного разнится. Формула ранжирования — тоже уникальная. Но ключевые факторы, влияющие на релевантность сайта, следующие:

- индекс цитируемости (как часто сторонние ресурсы ссылаются на информацию из конкретной страницы);

- авторитетность домена (определяется на основании его истории изменения);

- релевантность текстовой информации по запросу;

- релевантность иных форматов контента, представленных на странице;

- качество оптимизации сайта.

СПРАВКА! Если вам необходимо заказать продвижение сайта в поисковых системах, я могу Вам помочь, сделать качественный SEO аудит сайта и составить план продвижения.

Основные характеристики поисковых систем

Главный параметр — это наглядность. То есть насколько точная информация представлена в выдаче на усмотрение самого пользователя, который и отправлял запрос. Но есть и другие характеристики для оценки поисковых систем.

Полнота

Условный параметр, который указывает соотношение от общего числа документов, дающих ответ на пользовательский запрос, от их количества, представленного системой в выдаче. Чем выше соотношение — тем более полный анализ производится сервисом.

Точность

Актуальность

Имеется ввиду время, прошедшее с момента публикации данных на сайте до его добавления в каталог индексации. Чем быстрее этот процесс будет завершен, тем более актуальную информацию пользователю представят в выдаче. Для современных сервисов, типа Bing или Google периодичность обновления базы данных индексации составляет до 3-х месяцев. Для релевантных сайтов — несколько дней.

Скорость поиска

Наглядность

Пользовательская оценка в работе сервиса. Во многом зависит от того, какие ссылки рядовой пользователь увидит в ТОП выдачи. Ведь именно их он изучает в первую очередь. И полученная на них информация должна на 100% ответить на его запросы.

Выводы

Постоянная индексация и ранжирование — это основной принцип работы поисковых интернет систем. А за написание алгоритмов и программ, которые выполняют большую часть всей этой работы, отвечают тысячи программистов. Именно благодаря их работе каждый пользователь за несколько секунд может отыскать в веб-пространстве необходимую для него прямо сейчас информацию.

Если Вам понравилась статья поделитесь ей в социальных сетях, так же рекомендую прочитать статью — методах продвижения сайта в интернете.

Если вы хотите более глубоко понимать принцип работы поисковых систем рекомендую посмотреть видео от Сергея Кокшарова и почитать его SEO блог

24 января 2 августа Игорь Серов SEO учебник yahoo, анализировать сайт, база данных, бот, механизм поисковой оптимизации, поисковый паук, поисковый робот, поисковых роботов, программа seo анализа, работа поисковиков, ссылка

Вступление

Каждая поисковая система имеет свой алгоритм поиска запрашиваемой пользователем информации. Алгоритмы эти сложные и чаще держатся в секрете. Однако общий принцип работы поисковых систем можно считать одинаковым. Любой поисковик:

- Сначала собирает информацию, черпая её со страниц сайтов и вводя её в свою базы данных;

- Индексирует сайты и их страницы, и переводит их из базы данных в базу поисковой выдачи;

- Выдает результаты по поисковому запросу, беря их из базы проиндексированных страниц;

- Ранжирует результаты (выстраивает результаты по значимости).

Работа поисковых систем – общие принципы

Вся работа поисковых систем выполняют специальные программы и комбинации этих программ.

Перечислим основные составляющие алгоритмов поисковых систем:

Реализация механизмов поиска у поисковиков может быть самая различная. Например, комбинация программ Spider+ Crawler+ Indexer может быть создана, как единая программа, скачивающая и анализирующая веб-страницы и находящая новые ресурсы по найденным ссылкам. Тем не менее, нижеупомянутые общие черты программ присущи всем поисковым системам.

Программы поисковых систем

Spider

Crawler

Indexer

Программа Indexer (индексатор) делит страницу на составные части, далее анализирует каждую часть в отдельности. Выделению и анализу подвергаются заголовки, абзацы, текст, специальные служебные html-теги, стилевые и структурные особенности текстов, и другие элементы страницы. Именно, поэтому, нужно выделять заголовки страниц и разделов мета тегами (h1-h4,h5,h6), а абзацы заключать в теги

Database

База данных поисковых систем хранит все скачанные и анализируемые поисковой системой данные. В базе данных поисковиков хранятся все скачанные страницы и страницы, перенесенные в поисковой индекс. В любом инструменте веб мастеров каждого поисковика, вы можете видеть и найденные страницы и страницы в поиске.

Search Engine Results Engine

Search Engine Results Engine это инструмент (программа) выстраивающая страницы соответствующие поисковому запросу по их значимости (ранжирование страниц). Именно эта программа выбирает страницы, удовлетворяющие запросу пользователя, и определяет порядок их сортировки. Инструментом выстраивания страниц называется алгоритм ранжирования системы поиска.

Важно! Оптимизатор сайта, желая улучшить позиции ресурса в выдаче, взаимодействует как раз с этим компонентом поисковой системы. В дальнейшем все факторы, которые влияют на ранжирование результатов, мы обязательно рассмотрим подробно.

Web server

Web server поисковика это html страница с формой поиска и визуальной выдачей результатов поиска.

Повторимся. Работа поисковых систем основана на работе специальных программ. Программы могут объединяться, компоноваться, но общий принцип работы всех поисковых систем остается одинаковым: сбор страниц сайтов, их индексирование, выдача страниц по результатам запроса и ранжирование выданных страниц по их значимости. Алгоритм значимости у каждого поисковика свой.

Поисковики выдают нам нужный результат за доли секунды. Как они это делают? Существуют базовые принципы работы для всех поисковиков.

Откройте книгу или справочник, загляните в ящик библиотечного каталога. Везде есть система быстрого доступа к информации. Например, книга имеет оглавление, предметный указатель, примечания (ссылки). Эта схема доступа и легла в основу поисковых систем.

В поисковых системах каталог — это список адресов страниц в Интернете, рассортированный по рубрикам (тематикам). Развитие поисковиков началось именно с составления каталогов сайтов, когда их количество было относительно небольшим, и собрать все страницы можно было вручную.

Количество документов по мере повышения доступности Интернета увеличивалось лавинообразно, поэтому родилась необходимость в поиске по каталогу в пределах рубрик. Так каталоги уступили место поисковым системам – автоматическим каталогам с поиском.

Это упорядоченный по алфавиту перечень ключевых слов, терминов в тексте с указанием страниц, где этот термин употребляется. Такой перечень нужен, чтобы найти информацию, если из оглавления непонятно, о чем данная глава.

Применительно к Интернету, предметный указатель называется индексом. Поисковой системой анализируется содержание страницы и производится индексация – формируется список слов с указанием страниц, на которых эти слова встречаются. При введении поискового запроса слова из него сопоставляются с базой проиндексированных страниц, и формируется список документов, отвечающих критериям поиска. Современные поисковики знают не только о присутствии слова на странице, но и о его координатах – положении относительно других слов.

По ним читатель книги узнает о других страницах или источниках с полезной информацией. Тот же принцип используется поисковыми системами.

Ссылка (гиперссылка) говорит поисковому роботу о странице, куда нужно перейти для пополнения базы данных. Это может быть страница внутри сайта (внутренняя перелинковка), документ на другом сайте (внешняя ссылка). Благодаря ссылкам происходит непрерывное обновление информации о появившихся документах. Без ссылок поисковая машина не узнает о новом ресурсе. Есть несколько способов добавления ссылок в поисковую систему.

Алгоритмы работы поисковых систем используют эти три принципа. Есть отличия в способах ранжирования, формировании выдачи и других тонкостях, но с рациональностью и обоснованностью основных правил согласны все разработчики.

Внутренности поисковиков

Если говорить о главном, то основные программные блоки поисковых систем это:

- Spider – поисковый робот, который как паук бегает по всем страницам и скачивает их содержимое для создания базы данных. В одной системе может быть несколько роботов. Например, в Яндексе используются основной и быстрый роботы. Основной отвечает за скачивание всего Интернета в целом, а быстрый (Orange) реагирует на новые документы для оперативного появления их в индексе системы.

- Crawler – часть алгоритма, которая проходит по всем добавленным в базу страницам и собирает гиперссылки. Список ссылок добавляется в базу адресов страниц. Так происходит пополнение списка сайтов и составление маршрута обхода для поискового робота – система отправляет паука для индексации документа по найденной ссылке. Если на страницу не ведет ни одной ссылки, то поисковой системе может потребоваться много времени, чтобы случайно узнать о документе. Чтобы ускорить индексацию страниц, веб-разработчики могут сообщить о новом ресурсе поисковику через панель вебмастера. Такой функционал предусмотрен в Google, Яндексе, других поисковых системах. Также о новых документах робот может узнать из карты сайта с перечнем адресов всех страниц.

- Индексный робот – часть кода, которая работает над составлением индекса. Для этого текст разбивается на слова, которые в алфавитном порядке заносятся в базу данных с информацией об адресе страницы, где это слово встречается.

- База данных – хранилище, в одной части которого находятся все документы, которые выкачал робот, в другой – проиндексированные страницы.

- Search engine results page (SERP) – блок программы, с которой взаимодействует пользователь. Алгоритм сравнивает слова из пользовательского запроса с индексом, находит соответствие и показывает результаты в виде списка ссылок релевантных страниц и сниппетов (кратких описаний). Если в запросе несколько слов, то ищутся документы, где присутствуют все эти слова. Дальше пользователь переходит по ссылке, попадая на ресурс с нужной информацией.

Не все так просто

На первый взгляд, понимание принципов работы дает возможность с высокой долей вероятности влиять на расположение того или иного документа на вершине выдачи. В самом начале развития поисковых систем так и было: на положение в результатах можно было повлиять добавлением ключевых слов в текст и наращиванием числа внешних ссылок на нужные страницы.

Это работало, пока не появились сложные алгоритмы ранжирования.

Чтобы в результаты поиска не попал цифровой мусор и бессмысленный контент с кучей ключей, документы проходят несколько этапов фильтрации поисковых систем. То есть прежде, чем пользователь увидит документ, этому документу предстояло пройти поисковый кастинг.

1. Фильтрация до индексации

Это первый этап просеивания крупного мусора. К нему относятся неработающие и устаревшие ссылки, дубли. В итоге остаются ссылки с корректными адресами, куда планировщик направляет поисковых роботов для выкачивания контента. Скачиваются все страницы с работающими адресами. Кроме качественных материалов, в фильтрацию попадают переспамленные документы, малопопулярные ресурсы, профили в социальных сетях, служебные страницы. На втором этапе фильтрации удаляются бесполезные с точки зрения содержимого страницы. Прошедшие отбор документы индексируются и попадают в базу данных поисковика.

2. Фильтрация на этапе поиска

После введения поискового запроса пользователем системе нужно в реальном времени отсортировать список страниц, отвечающих запросу и расположить их по релевантности. На эту операцию уходят доли секунды, так как продолжительное ожидание может заставить пользователя обратиться в другую поисковую систему. Обеспечение скорости зависит и от программного кода, и от технических характеристик оборудования, которое используется поисковой системой. Для ускорения процесса могут применяться разные алгоритмы, в том числе – метапоисковая выдача. Это когда на популярные запросы пользователю выдается список сайтов, сформированный заранее на основе таких же запросов от других пользователей с похожими характеристиками (регион, возраст, пол и так далее).

3. Ранжирование

Работа поисковика не заканчивается на формировании подборки подходящих документов. Нужно расположить страницы внутри выборки по степени убывания релевантности.

Сначала проводится черновое ранжирование. Оно позволяет на дозапросном этапе выстроить все документы рубрики по степени соответствия запросам. Такие списки могут включать миллионы сайтов. Окончательное ранжирование производится после обращения пользователя.

Читайте также:

- Мотивация родителей на сотрудничество со школой

- Проследите по карте процесс включения русских земель в состав московского государства кратко

- Внешняя политика испании в 19 веке кратко

- Современные подходы к организации воспитательного процесса в доу на основе отечественных традиций

- Глобальная энергетическая безопасность это кратко