Линеаризуемые функции для построения уравнения множественной регрессии кратко

Обновлено: 05.07.2024

Цель данной главы - дать достаточно полное изложение материала, необходимого для изучения основных вопросов, связанных с построением моделей классической множественной линейной регрессии. Основное внимание уделяется проблемам оценки параметров, проверки адекватности и достоверности моделей.

3.1. Модель множественной линейной регрессии: содержательная интерпретация и предпосылки

Модель множественной линейной регрессии (или коротко - множественная линейная регрессия) предназначена для проверки и изучения связи (объяснения поведения) между одной зависимой переменной (эндогенной) и несколькими независимыми (экзогенными) переменными. Предполагается, что такая связь теоретически может быть описана (специфицирована) линейной зависимостью (функцией) вида:

где Y - зависимая (объясняемая, эндогенная) переменная - регрессанд, U - случайная составляющая модели, xj - независимые (объясняющие, экзогенные) переменные - регрессоры.

Очевидно, что модель множественной линейной регрессии является обобщением модели парной линейной регрессии на многомерный случай.

В данном разделе мы будем рассматривать классическую модель множественной линейной регрессии . Это означает, что независимые переменные (регрессоры) предполагаются не случайными (детерминированными) величинами. Обобщения данной модели на случай, когда эта предпосылка не выполняется, будут рассмотрены в последующих разделах.

Модель ( 3.1 ) связывает зависимую и независимые переменные в отдельных наблюдениях (реализациях) переменных

Переменные y и u в уравнении ( 3.2 ) являются реализациями случайных величин Y и U. Отметим, что единственным источником неопределенности (случайности) в уравнениях ( 3.1 ) и ( 3.2 ) является случайная составляющая модели U. Переменная x1 = xi1 = 1 (для всех i=1,2,…n) и называется вспомогательной переменной для свободного члена . Она вводится для удобства записи уравнений многомерной линейной регрессии. Таким образом, коэффициент регрессии в уравнениях ( 3.1 ), ( 3.2 ) является свободным членом, который называется также параметром сдвига .

Для статистической оценки параметров регрессионной модели необходим набор (множество) данных наблюдений зависимой и независимых переменных. Эти данные могут быть пространственными - в этом случае наблюдаются различные объекты, но наблюдения относятся к одному и тому же моменту или периоду времени. Данные могут быть представлены в виде временных рядов наблюдений зависимой (объясняемой) и независимых (объясняющих) переменных - в этом случае наблюдается поведение одного объекта в различные (но одинаковые для всех переменных) моменты времени. Для каждого из этих наблюдений согласно линейной модели можно записать уравнения

Запись уравнений с использованием векторов и матриц

Данную систему уравнений удобно записать в векторно-матричном виде. Для этого введем следующие обозначения:

вектор - столбец (столбцовая матрица) наблюдений зависимой переменной (регрессанда)

матрица наблюдений независимых переменных (регрессоров)

вектор - столбец коэффициентов (параметров)

вектор - столбец реализаций случайной составляющей в отдельных наблюдениях

Таким образом, здесь y - вектор - столбец размерности n, элементы которого - наблюдения зависимой переменной (регрессанда); X - матрица размерности (n x k), ее столбцы содержат наблюдения независимых переменных (регрессоров), i-ый столбец матрицы X (кроме первого) содержит n наблюдений i - го регрессора, первый столбец этой матрицы состоит из единиц; - вектор - столбец размерности k, его элементы - коэффициенты уравнения регрессии; u - вектор - столбец размерности n, его элементы - реализации случайной составляющей модели в каждом наблюдении.

С использованием введенных обозначений, систему ( 3.3 ) из n уравнений можно записать более компактно

Отметим, что матричная форма записи уравнений линейной регрессии существенно проще и, как мы увидим в дальнейшем, ее использование позволяет получить и записать многие результаты для оценок в компактном виде. Основные правила действий с матрицами и векторами, которые необходимо при этом знать, приведены в приложении.

Предпосылки классической многомерной линейной регрессионной модели

Сформулируем предпосылки, которые необходимы при выводе формул для оценок параметров модели, изучения их свойств и тестирования качества модели. Эти предпосылки обобщают и дополняют основные предпосылки классической модели парной линейной регрессии (условия Гаусса-Маркова), но часть из них существенны именно для многомерной модели.

Предпосылка 1 . Независимые переменные не случайны и измеряются без ошибок. Это означает, что матрица наблюдений X - детерминированная.

Предпосылка 2. (первое условие Гаусса-Маркова) Математическое ожидание случайной составляющей в каждом наблюдении равно нулю

Предпосылка 3. (второе условие Гаусса-Маркова) Теоретическая дисперсия случайной составляющей одинакова для всех наблюдений

Напомним, что это свойство случайной составляющей называется гомоскедастичностью.

Предпосылка 4. (третье условие Гаусса-Маркова) Случайные составляющие модели некоррелированы для различных наблюдений. Это означает, что теоретическая ковариация

Предпосылки 3,4 можно записать, используя векторные обозначения

здесь , причем (это означает, что - симметричная матрица), In - единичная матрица размерности n (напомним, что единичная матрица - это квадратная матрица, у которой по диагонали стоят элементы, равные единице, а остальные равны нулю), верхний индекс T - означает транспонирование. Матрица называется теоретической матрицей ковариаций(или ковариационной матрицей) .

Предпосылка 5. (четвертое условие Гаусса-Маркова). Случайная составляющая и объясняющие переменные некоррелированы (для модели нормальной регрессии это условие означает и независимость). В предположении, что объясняющие переменные не случайные, эта предпосылка в классической регрессионной модели всегда выполняется.

Предпосылка 6. Коэффициенты регрессии - постоянные величины.

Предпосылка 7. Уравнение регрессии идентифицируемо . Это означает, что параметры уравнения в принципе оцениваемы. Или, другими словами, решение задачи оценивания параметров существует и единственно.

Предпосылка 8. Регрессоры не коллинеарны . В этом случае матрица наблюдений регрессоров должна быть полного ранга (ее столбцы должны быть линейно независимы). Данная предпосылка тесно связана с предыдущей, так как при применении для оценивания коэффициентов регрессии метода наименьших квадратов ее выполнение гарантирует идентифицируемость модели (если количество наблюдений больше количества оцениваемых параметров).

Предпосылка 9. Количество наблюдений больше количества оцениваемых параметров, то есть n>k.

Все эти предпосылки одинаково важны, и только при их выполнении можно применять классическую регрессионную модель на практике.

Предпосылка о нормальности случайной составляющей. При построении доверительных интервалов для коэффициентов модели и прогнозов зависимой переменной, проверке статистических гипотез относительно коэффициентов, построении процедур для анализа адекватности (качества) модели в целом необходимо дополнительное предположение о нормальном распределении случайной составляющей. С учетом этой предпосылки модель ( 3.1 ) называется классической линейной многомерной нормальной моделью регрессии.

В эмпирических социально-экономических исследованиях сформулированные предпосылки далеко не всегда выполняются. При их нарушении необходимо строить так называемые обобщенные модели линейной регрессии , которые будут рассмотрены в последующих разделах. При изучении регрессионных моделей и, особенно, при применении их на практике очень важно (в решающей степени) понимать роль и значение этих предпосылок. От того, на сколько корректно (правильно) и осознанно используются возможности регрессионного анализа, зависит успех всего эконометрического моделирования и, в конечном счете, обоснованность принимаемых решений.

Рассмотрим ряд понятий, связанных с моделью многомерной линейной регрессии.

Математическое ожидание регрессанда

С учетом предпосылки 1 в линейной функции регрессии случайными являются только переменные U, относительно которых выполнена предпосылка 2. Применяя к обеим частям уравнения ( 3.2 ) оператор математического ожидания, получим

Математическое ожидание ( 3.5 ) регрессанда определяет систематическую часть уравнения регрессии (регрессанда).

Эмпирическая линейная функция регрессии

Систематическая часть уравнения регрессии, в которой вместо теоретических значений параметров стоят некоторые их оценки, называется эмпирической линейной функцией регрессии.

Эмпирическая функция регрессии записывается в виде

где коэффициенты bj, (j=1,2,…,k) - оценки теоретических значений параметров модели. Переменная является точечным прогнозом зависимой переменной Y при некоторых заданных значениях независимых переменных (регрессоров). Эмпирическая линейная регрессионная функция определяет регрессионную гиперплоскость в линейном k-мерном пространстве.

Ошибки (остатки) регрессионного уравнения

называется ошибкой (остатком) уравнения в i-ом наблюдении.

Ошибки являются вычисляемыми величинами и поэтому их можно считать известными при каждом фиксированном наборе наблюдений и заданных значениях параметров модели. Очевидно, величины ошибок (при фиксированных наблюдениях) зависят только от выбора коэффициентов b, которые являются оценками истинных (теоретических) значений коэффициентов . Чем точнее оценки, тем, вообще говоря, меньше остатки модели (при условии ее правильной спецификации), тем лучше данная модель соответствует наблюдаемой выборке, и тем лучше модель "настроена" именно на данную выборку. Оценки параметров классической многомерной линейной модели чаще всего строятся с использованием обычного (классического) многомерного метода наименьших квадратов .

Основная цель множественной регрессии – построить модель с большим числом факторов, определив при этом влияние каждого из них в отдельности, а также совокупное их воздействие на моделируемый показатель.

- уравнение множественной регрессии, матрица парных коэффициентов корреляции, средние коэффициенты эластичности для линейной регрессии;

- множественный коэффициент детерминации, доверительные интервалы для индивидуального и среднего значения результативного признака;

Инструкция . Укажите количество данных (количество строк), количество переменных x нажмите Далее . Полученное решение сохраняется в файле Word . Если данных много, можно вставить их из MS Excel . Для этого укажите количество переменных x нажмите Вставить из Excel .

При вычислении параметров уравнения множественной регрессии используется матричный метод. Для множественной регрессии с двумя переменными (m = 2), можно воспользоваться методом решения системы уравнений.

Построение уравнения множественной регрессии начинается с решения вопроса о спецификации модели, который в свою очередь включает 2 круга вопросов: отбор факторов и выбор уравнения регрессии.

- теоретический анализ взаимосвязи результата и круга факторов, которые оказывают на него существенное влияние;

- количественная оценка взаимосвязи факторов с результатом. При линейной форме связи между признаками данный этап сводится к анализу корреляционной матрицы (матрицы парных линейных коэффициентов корреляции). Научно обоснованное решение задач подобного вида также осуществляется с помощью дисперсионного анализа - однофакторного, если проверяется существенность влияния того или иного фактора на рассматриваемый признак, или многофакторного в случае изучения влияния на него комбинации факторов.

- Они должны быть количественно измеримы. Если необходимо включить в модель качественный фактор, не имеющий количественного измерения, то ему нужно придать количественную определенность.

- Каждый фактор должен быть достаточно тесно связан с результатом (т.е. коэффициент парной линейной корреляции между фактором и результатом должен быть существенным).

- Факторы не должны быть сильно коррелированы друг с другом, тем более находиться в строгой функциональной связи (т.е. они не должны быть интеркоррелированы). Разновидностью интеркоррелированности факторов является мультиколлинеарность - тесная линейная связь между факторами.

Пример . Постройте регрессионную модель с 2-мя объясняющими переменными (множественная регрессия). Определите теоретическое уравнение множественной регрессии. Оцените адекватность построенной модели.

Решение.

К исходной матрице X добавим единичный столбец, получив новую матрицу X

| 1 | 5 | 14.5 |

| 1 | 12 | 18 |

| 1 | 6 | 12 |

| 1 | 7 | 13 |

| 1 | 8 | 14 |

Матрица Y

| 9 |

| 13 |

| 16 |

| 14 |

| 21 |

Транспонируем матрицу X, получаем X T :

| 1 | 1 | 1 | 1 | 1 |

| 5 | 12 | 6 | 7 | 8 |

| 14.5 | 18 | 12 | 13 | 14 |

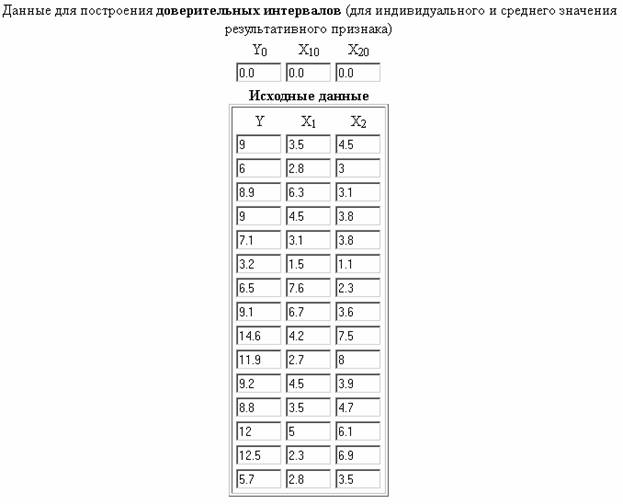

| Год | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | 12 | 13 | 14 | 15 |

| X1 | 3,5 | 2,8 | 6,3 | 4,5 | 3,1 | 1,5 | 7,6 | 6,7 | 4,2 | 2,7 | 4,5 | 3,5 | 5,0 | 2,3 | 2,8 |

| X2 | 4,5 | 3,0 | 3,1 | 3,8 | 3,8 | 1,1 | 2,3 | 3,6 | 7,5 | 8,0 | 3,9 | 4,7 | 6,1 | 6,9 | 3,5 |

| Y | 9,0 | 6,0 | 8,9 | 9,0 | 7,1 | 3,2 | 6,5 | 9,1 | 14,6 | 11,9 | 9,2 | 8,8 | 12,0 | 12,5 | 5,7 |

Постройте уравнение линейной регрессии прироста заработной платы от производительности труда и уровня инфляции. Проверьте качество построенного уравнения регрессии с надежностью 0,95. Проведите проверку наличия в модели автокорреляции на уровне значимости 0,05.

Решение. Подготовим данные для вставки из MS Excel (как транспонировать таблицу для сервиса см. Задание №2) .

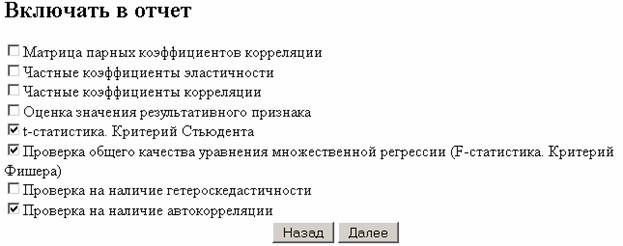

Включаем в отчет: Проверка общего качества уравнения множественной регрессии (F-статистика. Критерий Фишера, Проверка на наличие автокорреляции),

Качество построенного уравнения регрессии проверяется с помощью критерия Фишера (п. 6 отчета).

Пример №3 .

В таблице представлены данные о ВВП, объемах потребления и инвестициях некоторых стран.

| ВВП | 16331,97 | 16763,35 | 17492,22 | 18473,83 | 19187,64 | 20066,25 | 21281,78 | 22326,86 | 23125,90 |

| Потребление в текущих ценах | 771,92 | 814,28 | 735,60 | 788,54 | 853,62 | 900,39 | 999,55 | 1076,37 | 1117,51 |

| Инвестиции в текущих ценах | 176,64 | 173,15 | 151,96 | 171,62 | 192,26 | 198,71 | 227,17 | 259,07 | 259,85 |

- Средние значения величин;

- Дисперсии величин;

- Среднеквадратические отклонения величин;

- Ковариацию ВВП и потребления, ковариацию ВВП и инвестиций;

- Коэффициент корреляции ВВП и потребления, ковариацию ВВП и инвестиций;

- Коэффициент частной корреляции ВВП и потребления, коэффициент частной корреляции ВВП и инвестиций;

- Построить уравнение регрессии для зависимости ВВП от потребления. Определить коэффициент детерминации и сделать вывод о качестве полученного уравнения регрессии. С помощью t -теста проверить гипотезу H0: β = 0 для пятипроцентного уровня значимости и сделать вывод о значимости полученного коэффициента. Построить девяностопятипроцентный доверительный интервал для коэффициента регрессии b . С помощью F -теста проверить полученное уравнение регрессии на значимость. Провести t -тест для коэффициента корреляции.

- Построить уравнение множественной регрессии для зависимости ВВП от потребления и инвестиций. Определить коэффициент детерминации и сделать вывод о качестве полученного уравнения регрессии. С помощью t -теста проверить гипотезы H0: β1 = 0, H0: β2 = 0 для пятипроцентного уровня значимости и сделать вывод о значимости полученных коэффициентов. Построить девяностопятипроцентный доверительный интервал для коэффициентов регрессии b 1, b 2. С помощью F -теста проверить полученное уравнение регрессии на значимость. Провести t -тест для коэффициента корреляции.

- Построить уравнение множественной регрессии. При этом признак-результат и один из факторов остаются теми же, что и в первом задании. Выберите дополнительно еще один фактор из приложения 1 (границы наблюдения должны совпадать с границами наблюдения признака-результата, соответствующего Вашему варианту). При выборе фактора нужно руководствоваться его экономическим содержанием или другими подходами. Пояснить смысл параметров уравнения.

- Рассчитать частные коэффициенты эластичности. Сделать вывод.

- Определить стандартизованные коэффициенты регрессии (b-коэффициенты). Сделать вывод.

- Определить парные и частные коэффициенты корреляции, а также множественный коэффициент корреляции; сделать выводы.

- Оценить значимость параметров уравнения регрессии с помощью t-критерия Стьюдента, а также значимость уравнения регрессии в целом с помощью общего F-критерия Фишера. Предложить окончательную модель (уравнение регрессии). Сделать выводы.

Умножаем матрицы, (X T X)

Находим определитель det(X T X) T = 139940.08

Находим обратную матрицу (X T X) -1

Найдем оценку ковариационной матрицы вектора k = σ*(X T X) -1

Дисперсии параметров модели определяются соотношением S 2 i = Kii, т.е. это элементы, лежащие на главной диагонали

С целью расширения возможностей содержательного анализа модели регрессии используются частные коэффициенты эластичности, которые определяются по формуле

Связь между признаком Y факторами X сильная

Частные коэффициенты (или индексы) корреляции, измеряющие влияние на у фактора хi при неизменном уровне других факторов определяются по стандартной формуле линейного коэффициента корреляции - последовательно берутся пары yx1,yx2. , x1x2, x1x3.. и так далее и для каждой пары находится коэффициент корреляции

Коэффициент детерминации

R 2 = 0.97 2 = 0.95, т.е. в 95% случаев изменения х приводят к изменению y. Другими словами - точность подбора уравнения регрессии - высокая

Значимость коэффициента корреляции

По таблице Стьюдента находим Tтабл: Tтабл (n-m-1;a) = (17;0.05) = 1.74

Поскольку Tнабл Fkp, то коэффициент детерминации статистически значим и уравнение регрессии статистически надежно

Построение парной регрессионной модели

1) Рассчитайте корреляцию между, как минимум, тремя экономическими показателями из статистических данных по выборке не менее 15 наблюдений (из Интернета, печатных источников или Вашего предприятия). Интерпретируйте полученные данные.

2) Осуществите выбор зависимой (объясняемой) и объясняющей переменной для построения парной регрессионной модели. Дайте графическое изображение регрессионной зависимости. Определите теоретическое уравнение парной регрессии. Оцените адекватность построенной модели (интерпретируйте R-квадрат, показатели t-статистики, F-статистики).

3) Постройте регрессионную модель с 2-мя объясняющими переменными (множественная регрессия). Определите теоретическое уравнение множественной регрессии. Оцените адекватность построенной модели. Сравните адекватность модели с парной регрессией.

4) Проверьте любую из построенных моделей (парной или множественной регрессии) на отсутствие автокорреляции.

Рекомендации к решению контрольной работы.

Статистические данные по экономике можно получить на странице Россия в цифрах.

После определения зависимой и объясняющих переменных можно воспользоваться сервисом Множественная регрессия. Регрессионную модель с 2-мя объясняющими переменными можно построить используя матричный метод нахождения параметров уравнения регрессии или метод Крамера для нахождения параметров уравнения регрессии.

Пример №3 . Исследуется зависимость размера дивидендов y акций группы компаний от доходности акций x1, дохода компании x2 и объема инвестиций в расширение и модернизацию производства x3. Исходные данные представлены выборкой объема n=50.

Тема II. Множественная линейная регрессия

1. Постройте выборочную множественную линейную регрессию показателя на все указанные факторы. Запишите полученное уравнение, дайте ему экономическую интерпретацию.

2. Определите коэффициент детерминации, дайте ему интерпретацию. Вычислите среднюю абсолютную ошибку аппроксимации и дайте ей интерпретацию.

3. Проверьте статистическую значимость каждого из коэффициентов и всего уравнения в целом.

4. Постройте диаграмму остатков.

5. Постройте доверительные интервалы коэффициентов. Для статистически значимых коэффициентов дайте интерпретации доверительных интервалов.

6. Постройте точечный прогноз значения показателя y при значениях факторов, на 50% превышающих их средние значения.

7. Постройте доверительный интервал прогноза, дайте ему экономическую интерпретацию.

8. Постройте матрицу коэффициентов выборочной корреляции между показателем и факторами. Сделайте вывод о наличии проблемы мультиколлинеарности.

9. Оцените полученные результаты — сделайте выводы о качестве построенной модели, влиянии рассматриваемых факторов на показатель.

, (1)

где y – зависимая переменная (результативный признак);

- независимые переменные (факторы).

Такого рода уравнение может использоваться при изучении потребления. Тогда коэффициенты - частные производные потребления y по соответствующим факторам : в предположении, что все остальные постоянны.

Множественная регрессия – один из наиболее распространенных методов в эконометрике. Основная цель множественной регрессии – построить модель с большим числом факторов, определив при этом влияние каждого из них в отдельности, а также совокупное их воздействие на моделируемый показатель.

Построение уравнения множественной регрессии начинается с решения вопроса о спецификации модели. Она включает в себя два круга вопросов:

- выбор вида уравнения регрессии.

Включение в уравнение множественной регрессии того или иного набора факторов связано, прежде всего, с представлением исследователя о природе взаимосвязи моделируемого показателя с другими экономическими явлениями. Факторы, включаемые во множественную регрессию, должны отвечать следующим требованиям:

1. Они должны быть количественно измеримы. Если необходимо включить в модель качественный фактор, не имеющий количественного измерения, то ему нужно придать количественную определенность. Например, в модели стоимости объектов недвижимости учитывается место нахождения недвижимости; районы могут быть проранжированы.

2. Факторы не должны быть интеркоррелированы и тем более находиться в точной функциональной связи.

Если между факторами существует высокая корреляция, то нельзя определить их изолированное влияние на результативный показатель и параметры уравнения регрессии оказываются неинтерпретируемыми. Так, в уравнении предполагается, что факторы независимы друг от друга, т.е. . Тогда можно говорить, что параметр измеряет силу влияния фактора на результат y при неизменном значении фактора . Если же , то с изменением фактора , не может оставаться неизменным. Отсюда и нельзя интерпретировать как показатели раздельного влияния и на y.

Пример. Рассмотрим регрессию себестоимости единицы продукции y (руб.) от заработной платы работника x (руб.) и производительности его труда z (единиц в час) . Коэффициент регрессии при переменной z показывает, что с ростом производительности труда на 1 ед. себестоимость единицы продукции снижается в среднем на 10 руб. при постоянном уровне оплаты труда. Вместе с тем параметр при x нельзя интерпретировать как снижение себестоимости единицы продукции за счет роста заработной платы. Отрицательное значение коэффициента регрессии при переменной x в данном случае обусловлено высокой корреляцией между x и z ( ). Поэтому роста заработной платы при неизменности производительности труда (если не брать во внимание проблемы инфляции) быть не может.

Считается, что две переменные явно коллинеарны, т.е. находятся между собой в линейной зависимости, если . Наибольшие трудности в использовании аппарата множественной регрессии возникают при наличии мультиколлинеарности факторов, когда более чем два фактора связаны между собой линейной зависимостью, т.е. имеет место совокупное воздействие факторов друг на друга. В результате вариация в исходных данных перестает быть полностью независимой, и нельзя оценить воздействие каждого фактора в отдельности.

Включение в модель мультиколлинеарных факторов нежелательно в силу следующих последствий:

1. параметры линейной регрессии теряют экономический смысл;

2. оценки параметров ненадежны, что делает модель непригодной для анализа и прогнозирования.

Для оценки мультиколлинеарности факторов может использоваться определитель матрицы парных коэффициентов корреляции между факторами. Если бы факторы не коррелировали между собой, то матрица парных коэффициентов корреляции между факторами была бы единичной матрицей, поскольку все недиагональные элементы были бы равны нулю.

Так, для включающего три объясняющих переменных уравнения матрица коэффициентов корреляции между факторами имела бы определитель, равный единице.

, т.к. .

Если же, наоборот, между факторами существует полная линейная зависимость и все коэффициенты корреляции равны единице, то определитель такой матрицы равен нулю: .

Чем ближе к нулю определитель матрицы межфакторной корреляции, тем сильнее мультиколлинеарность факторов и ненадежнее результаты множественной регрессии. И, наоборот, чем ближе к единице определитель матрицы, тем меньше мультиколлинеарность факторов.

Проверка мультиколлинеарности факторов может быть проведена методом испытания гипотезы о независимости переменных H0: . Доказано, что величина

имеет приближенное распределение с степенями свободы. Если фактическое значение превосходит табличное (критическое) , то гипотеза H0 отклоняется. Это означает, что , недиагональные ненулевые коэффициенты корреляции указывают на коллинеарность факторов. Мультиколлинеарность считается доказанной.

Как и в парной зависимости, возможны разные виды уравнений множественной регрессии: линейные и нелинейные. Ввиду четкой интерпретации параметров наиболее широко используются линейная и степенная функции.

В линейной множественной регрессии параметры при x называются коэффициентами "чистой" регрессии. Они характеризуют среднее изменение результата с изменением соответствующего фактора на единицу при неизменном значении других факторов, закрепленных на среднем уровне.

Пример. Предположим, что зависимость расходов на продукты питания по совокупности семей характеризуется следующим уравнением:

,

где y – расходы семьи за месяц на продукты питания, тыс. руб.;

- месячный доход на одного члена семьи, тыс. руб.;

- размер семьи, человек.

Анализ данного уравнения позволяет сделать вывод: с ростом дохода на одного члена семьи на 1 тыс. рублей расходы на питание возрастут в среднем на 350 рублей при том же среднем размере семьи. Иными словами, 35% дополнительных семейных расходов тратится на питание. Увеличение размера семьи при тех же ее доходах предполагает дополнительный рост расходов на питание на 730 рублей.

Параметр a не подлежит экономической интерпретации.

В степенной функции

(2)

коэффициенты являются коэффициентами эластичности. Они показывают, на сколько процентов изменяется в среднем результат с изменением соответствующего фактора на 1% при неизменности действия других факторов. Этот вид уравнения регрессии получил наибольшее распространение в производственных функциях, в исследованиях спроса и потребления.

Пример. Предположим, что при исследовании спроса на мясо получено уравнение ,

где y – количество спрашиваемого мяса;

- цена;

- доход.

Следовательно, рост цен на 1% при том же доходе вызывает снижение спроса в среднем на 2,63%. Увеличение дохода на 1% обусловливает при неизменных ценах рост спроса на 1,11%.

Возможны и другие линеаризуемые функции для построения уравнения множественной регрессии:

; (3)

, (4)

которая используется при обратных связях признаков.

Стандартные компьютерные программы обработки регрессионного анализа позволяют перебирать различные функции и выбирать ту из них, для которой остаточная дисперсия и ошибка аппроксимации минимальны, а коэффициент детерминации максимален.

Для оценки параметров уравнения множественной регрессии применяют метод наименьших квадратов (МНК). Для линейных и нелинейных уравнений, приводимых к линейным, строится следующая система нормальных уравнений, решение которой позволяет получить оценки параметров регрессии:

СЛАД 9

. (5)

Для ее решения может быть применен метод определителей

, (6)

где Δ – определитель матрицы;

- частные определители, которые получаются путем замены соответствующего столбца матрицы данными левой части системы.

При этом определитель системы

. (7)

СЛАД 10

Другой вид уравнений множественной регрессии – уравнение регрессии в стандартизованном масштабе

, (8)

где - стандартизованные переменные:

, , (9)

для которых среднее значение равно нулю , а среднее квадратическое отклонение равно единице ;

β – стандартизованные коэффициенты регрессии.

К уравнению множественной регрессии в стандартизованном масштабе применим МНК. Стандартизованные β – коэффициенты определяются из следующей системы уравнений:

СЛАД 11

(10)

Стандартизованные коэффициенты регрессии показывают, на сколько сигм изменится в среднем результат, если соответствующий фактор изменится на одну сигму при неизменном среднем уровне других факторов.

Стандартизованные коэффициенты сравнимы между собой. Сравнивая их друг с другом, можно ранжировать факторы по силе их воздействия на результат. В этом основное достоинство стандартизованных коэффициентов регрессии в отличие от коэффициентов "чистой" регрессии, которые несравнимы между собой.

Пример. Пусть функция издержек производства y (тыс. руб.) характеризуется уравнением вида ,

где - основные производственные фонды (ОПФ) (тыс. руб.);

- численность занятых в производстве (чел.).

Анализируя его, видим, что при той же занятости дополнительный рост стоимости ОПФ на 1 тыс. руб. влечет за собой увеличение затрат в среднем на 1,2 тыс. руб., а увеличение численности занятых на одного человека способствует при той же технической оснащенности предприятий росту затрат в среднем на 1,1 тыс. руб.

Однако это не означает, что фактор оказывает более сильное влияние на издержки производства по сравнению с фактором . Такое сравнение возможно, если обратиться к уравнению регрессии в стандартизованном масштабе. Предположим, оно выглядит так: . Это означает, что с ростом фактора на одну сигму при неизменной численности занятых затраты на продукцию увеличиваются в среднем на 0,5 сигмы. Так как (0,5

Что способствует осуществлению желаний? Стопроцентная, непоколебимая уверенность в своем.

Множественная линейная регрессия (MLR), также известная просто как множественная регрессия, – это статистический метод, который использует несколько независимых переменных для прогнозирования результата переменной ответа. Цель множественной линейной регрессии (MLR) – смоделировать линейную связь между независимыми (независимыми) переменными и ответной (зависимой) переменной.

По сути, множественная регрессия – это расширение обычной регрессии методом наименьших квадратов (МНК), которая включает более одной независимой переменной.

Формула и расчет множественной линейной регрессии

где для i=n наблюдений:

yi=зависимая переменная

xi=объясняющие переменные

β0=y-интерцепт (постоянный член)

βp=коэффициенты наклона для каждой объясняющей переменной

ϵ=член ошибки модели (также известный как остатки)

Основные выводы

- Множественная линейная регрессия (МЛР), также известная как множественная регрессия, – это статистический метод, который использует несколько объясняющих переменных для прогнозирования результата переменной ответа.

- Множественная регрессия является расширением линейной (OLS) регрессии, в которой используется только одна объясняющая переменная.

- MLR широко используется в эконометрике и финансовом анализе.

О чем может рассказать множественная линейная регрессия (MLR)

Простая линейная регрессия – это функция, которая позволяет аналитику или статистику делать прогнозы относительно одной переменной на основе информации, которая известна о другой переменной. Линейная регрессия может быть использована только при наличии двух непрерывных переменных – независимой переменной и зависимой переменной. Независимая переменная – это параметр, который используется для расчета зависимой переменной или результата. Модель множественной регрессии распространяется на несколько объясняющих переменных.

Модель множественной регрессии основана на следующих предположениях:

Между зависимыми переменными и независимыми переменными существует линейная связь.

Независимые переменные не слишком сильно коррелируют друг с другом.

Наблюдения yi выбираются независимо и случайно из популяции.

Остатки должны быть нормально распределены со средним значением 0 и дисперсией σ.

Коэффициент детерминации (R-квадрат) – это статистическая метрика, которая используется для измерения того, насколько вариация результата может быть объяснена вариацией независимых переменных. R2 всегда увеличивается по мере добавления большего количества предикторов в модель MLR, даже если эти предикторы могут быть не связаны с переменной исхода.

Таким образом, R2 сам по себе не может быть использован для определения того, какие предикторы следует включить в модель, а какие исключить. R2 может быть только между 0 и 1, где 0 означает, что результат не может быть предсказан ни одной из независимых переменных, а 1 означает, что результат может быть безошибочно предсказан по независимым переменным.1

При интерпретации результатов множественной регрессии бета-коэффициенты действительны при постоянстве всех остальных переменных (“при прочих равных”). Результаты множественной регрессии могут быть представлены горизонтально в виде уравнения или вертикально в виде таблицы.2

Пример использования множественной линейной регрессии (MLR)

Например, аналитик может захотеть узнать, как движение рынка влияет на цену ExxonMobil (XOM). В этом случае линейное уравнение будет содержать значение индекса S&P 500 в качестве независимой переменной, или предиктора, и цену XOM в качестве зависимой переменной.

В действительности существует множество факторов, которые предсказывают исход события. Например, движение цены ExxonMobil зависит не только от общих показателей рынка. Другие факторы, такие как цена на нефть, процентные ставки и движение цен на нефтяные фьючерсы, могут влиять на цену XOM и цены акций других нефтяных компаний. Чтобы понять взаимосвязь, в которой присутствует более двух переменных, используется множественная линейная регрессия.

Множественная линейная регрессия (MLR) используется для определения математической взаимосвязи между рядом случайных переменных. Другими словами, MLR изучает, как несколько независимых переменных связаны с одной зависимой переменной. После определения того, что каждый из независимых факторов предсказывает зависимую переменную, информация о нескольких переменных может быть использована для создания точного прогноза об уровне их влияния на итоговую переменную. Модель создает зависимость в виде прямой (линейной) линии, которая наилучшим образом аппроксимирует все отдельные точки данных.3

Обращаясь к уравнению MLR, приведенному выше, в нашем примере:

yi = зависимая переменная – цена XOM

xi1 = процентные ставки

xi2 = цена на нефть

xi3 = значение индекса S&P 500

xi4 = цена нефтяных фьючерсов

B0 = y-интерцепт в нулевой момент времени

B1 = коэффициент регрессии, измеряющий изменение зависимой переменной на единицу при изменении xi1 – изменение цены XOM при изменении процентных ставок

B2 = коэффициент, измеряющий изменение зависимой переменной на единицу при изменении xi2 – изменение цены XOM при изменении цен на нефть

Оценки по методу наименьших квадратов, B0, B1, B2…Bp, обычно рассчитываются с помощью статистического программного обеспечения. В регрессионную модель можно включить любое количество переменных, в которой каждая независимая переменная обозначается номером – 1,2, 3, 4…p. Модель множественной регрессии позволяет аналитику предсказать результат на основе информации, полученной от нескольких объясняющих переменных.

Тем не менее, модель не всегда идеально точна, поскольку каждая точка данных может незначительно отличаться от результата, предсказанного моделью. Остаточное значение E, которое представляет собой разницу между фактическим и прогнозируемым результатом, включается в модель для учета таких незначительных изменений.

Предположим, что мы запустили нашу регрессионную модель цены XOM через программу статистических вычислений, которая выдает такой результат:

Аналитик интерпретирует этот результат так: если другие переменные остаются неизменными, то цена XOM увеличится на 7,8%, если цена на нефть на рынках вырастет на 1%. Модель также показывает, что цена XOM снизится на 1,5% после повышения процентных ставок на 1%. R2 показывает, что 86,5% изменений в цене акций Exxon Mobil можно объяснить изменениями в процентной ставке, цене на нефть, нефтяных фьючерсах и индексе S&P 500.

Разница между линейной и множественной регрессией

Обычная линейная квадратичная регрессия (OLS) сравнивает реакцию зависимой переменной на изменение некоторых объясняющих переменных. Однако редко бывает так, что зависимая переменная объясняется только одной переменной. В этом случае аналитик использует множественную регрессию, которая пытается объяснить зависимую переменную с помощью более чем одной независимой переменной. Множественная регрессия может быть линейной и нелинейной.

Множественная регрессия основана на предположении, что между зависимой и независимой переменными существует линейная связь. Также предполагается отсутствие значительной корреляции между независимыми переменными.

Читайте также: