Доклад про новые компьютеры

Обновлено: 08.05.2024

История создания компьютеров пятого поколения начинает свой отсчет с 1982 года, когда в Японии приняли программу разработки соответствующих ЭВМ. Ученые планировали к 1991 году разработать новую технику, ориентированную на обработку знаний. Предыдущие поколения электронных вычислительных устройств были направлены на хранение и обработку данных.

Согласно замыслу разработчиков, элементной базой компьютеров рассматриваемого периода должны были стать устройства, созданные на основе сверхбольших интегральных схем с компонентами искусственного интеллекта. Это позволило бы избежать необходимости писать программы для ЭВМ. Разработчики стремились к тому, чтобы компьютер выполнял функции по объяснению человека.

В ЭВМ пятого поколения количество выполняемых за секунду операций должно достигать сотен миллиардов.

Осторожно! Если преподаватель обнаружит плагиат в работе, не избежать крупных проблем (вплоть до отчисления). Если нет возможности написать самому, закажите тут.

Параллельно с японскими инженерами работали ученые из США, Великобритании и ряда европейских стран, в том числе СССР. Устройства, разрабатываемые в этих государствах, были ориентированы на параллельную обработку информации. Тем не менее проекты нельзя отнести к пятому поколению компьютеров, потому что речь не шла об интеграции множества процессоров.

Достоинства и недостатки

К плюсам ЭВМ пятого поколения следует отнести следующие характеристики:

- интеллектуальность, позволяющая устранить барьер между пользователем и устройством;

- высокая производительность;

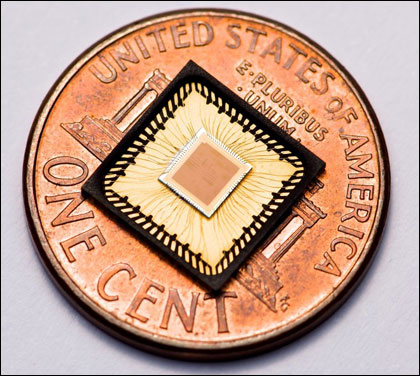

- небольшие размеры;

- доступность;

- объем памяти в сотни мегабайт.

Минус один – устройство еще не изобретено.

Чем обусловлено появление

Главной задачей при создании компьютеров будущего являлось создание искусственного интеллекта. Однако японский проект не оправдал себя. Несмотря на это, разработки ученых стали основой современных гаджетов:

На каких элементах построены, устройство, структурная схема

Разработчики видят перспективы в идее создания оптических компьютеров. Она заключается в том, чтобы использовать для вычислений фотоны, генерируемые лазерами и диодами. По сравнению с электронами, фотоны достигают более высоких скоростей.

Мысли о создании фотонного устройства стали реальны в 1976 году, когда ученые США провели опыт с оптической метастабильностью. Выяснилось, что для подобного рода приборов необходим полупроводник с двусторонним спектром – прозрачным и непрозрачным. Кроме того, материал должен обладать резко нелинейной оптической характеристикой. Эти особенности позволяют увеличить скорость микросхем до триллиона операций в секунду.

Попытка создания искусственного интеллекта

Единого определения, для чего нужен искусственный интеллект не существует. Каждый автор предлагает свои задачи. Выделяют два направления в развитии рассматриваемого явления:

- вероятность приближения искусственного интеллекта к человеческим возможностям;

- изобретение искусственного разума на основе созданных систем искусственного интеллекта для решения глобальных проблем человечества.

Сегодня в разработке искусственного интеллекта задействованы различные подходы, но ни один из них не привел к созданию искусственного разума в реальности. Однако, стоит отметить наиболее удачные примеры разработок в данной области:

Deep Blue — победитель в шахматном матче против чемпиона мира по шахматам Гарри Каспарова.

MYCIN — экспертная система, способная с точностью доктора определять заболевания человека.

Предел Мура

До начала 1980-х годов компьютеры воспринимались обществом и специалистами исключительно как вычислительные машины — громоздкие, дорогие и требовательные. Например, директор IBM Томас Уотсон как-то заявил, что компьютеры всегда будут штучным продуктом, а Кен Олсон, президент корпорации DEC, уверенно прогнозировал, что на персональные компьютеры никогда не будет спроса. Переломным стал август 1981 года, когда IBM выпустила на рынок серийную модель компьютера PC. Хотя самая дешёвая версия стоила больше полутора тысяч долларов, до конца года было продано 136 тысяч экземпляров. Персональные компьютеры оказались востребованы не только учёными и инженерами, но и обычными пользователями.

Первая универсальная вычислительная машина ENIAC, построенная в 1946 году, весила 27 тонн и использовала в качестве элементной базы вакуумные лампы

Первый настольный компьютер, завоевавший мировой рынок, — IBM PC 5150

Первый вариант смартфона под названием Simon выпустила компания IBM

Персональные компьютеры быстро завоевали мир, поскольку оказалось, что они могут использоваться почти в любой сфере. Через десять лет после появления первой массовой модели PC начали распространятся электронные сети, связывающие компьютеры друг с другом, — родилась Всемирная паутина. Параллельное внедрение средств сотовой связи создало предпосылки для появления смартфонов — мобильных телефонов с начинкой и программным обеспечением как у полноценного компьютера. Первое такое устройство называлось Simon, и на рынок его выпустила всё та же IBM в 1994 году.

В 1965 году Гордон Мур, один из основателей компании Intel, обнаружил определённую закономерность в развитии микросхем, на основании чего позднее сформулировал эмпирический закон, названный его именем: удвоение числа транзисторов на кристалле интегральной микросхемы при сохранении стоимости происходит каждые два года.

Гордон Мур из Intel открыл, что каждые два года происходит удвоение вычислительной мощности процессоров при сохранении стоимости их производства

Однако недавно сам Мур признал, что закон скоро перестанет действовать, поскольку технология приближается к физическому пределу, который нереально преодолеть на полупроводниковой базе. Например, при производстве нынешнего поколения процессоров Tiger Lake используется технология с размером транзисторов 10 нанометров; следующее поколение Meteor Lake, которое предполагают внедрить в 2022 году, будет основано на технологии с разрешением 7 нанометров. И удвоение числа транзисторов после этого, скорее всего, недостижимо, ведь размер транзистора не может быть меньше нескольких десятков атомов (размер атома кремния — 0,2 нанометра). Подсчитано, что даже если удастся создать транзистор, состоящий из одного электрона, то действие закона всё равно закончится — в 2036 году.

Персональные компьютеры будут уменьшаться.

Но этому есть предел

Получается, что в течение ещё двух десятков лет возможно появление более миниатюрных и производительных компьютеров, чем раньше, но предел уже виден, и пора начинать поиск альтернативных путей развития.

Будни фотоники

Одна из возможных альтернатив элементной базы для компьютеров — применение лазеров для передачи и обработки информации. В связи с этим внимание специалистов всё сильнее привлекает фотоника — аналог электроники, где вместо электронов используются фотоны, излучаемые лазерами.

Фотоника нашла применение в производстве оптоволоконных кабелей

Фотоника развивается по нескольким направлениям. Самые молодые из них, оптоинформатика и радиофотоника, призваны заменить существующие компьютерные и сетевые технологии. Чтобы показать преимущества, которые даёт фотоника в этой области, достаточно упомянуть, что созданный в Московском государственном университете сверхбыстрый фотонный переключатель позволяет поднять скорость передачи информации по оптоволоконному кабелю до нескольких сотен терабит в секунду (предел для современных кабелей — сто терабит в секунду).

Внедрение фотонных коммуникаций позволит, помимо прочего, вдвое снизить энергозатраты и, соответственно, стоимость систем хранения данных. Например, в США дата-центры уже потребляют 2% от всей производимой в стране энергии, поэтому экономия при переходе на новую технологию будет существенной. Перейти с электроники на фотонику планируют компании, располагающие крупнейшими дата-центрами в мире: Amazon, Apple, Facebook и Google.

Фотонные коммуникации станут новой элементной базой для компьютеров будущего

Прототип интегральной платы для оптического компьютера

Мозговой процессор

Внедрение нейрокомпьютерных интерфейсов началось с опытов на шимпанзе

Без сомнения, внедрение нейрокомпьютерных интерфейсов изменит наш мир сильнее, чем некогда — появление персональных компьютеров. Новая технология найдёт применение в военном деле и сфере безопасности, в науке и космонавтике, в медицине и образовании, в маркетинге и развлечениях. Согласно прогнозам футурологов, в ближайшем будущем сформируется и начнёт полноценно функционировать мозго-сеть (brainet, брейнет), соединяющая посредством нейроинтерфейсов мозги людей, высших животных и интеллектуальные программы-агенты в мощнейший органический компьютер, где будет происходить обмен знаниями, включая подсознательный опыт.

Нейрокомпьютерным интерфейсом можно пользоваться без хирургического вмешательства

В будущем нейрокомпьютерные интерфейсы будут выглядеть намного элегантнее

Возможно, предложенный прогноз слишком оптимистичен и воцарение мозго-сетей будет выглядеть как-то по-другому. Однако не приходится сомневаться: симбиоз человека с компьютером становится всё теснее, и когда-нибудь количество перейдёт в качество, породив принципиально новый вид обработки информации.

Троичный компьютер

Сетунь и её разработчики

Квантовый прорыв

Простейший, но далеко не простой квантовый компьютер Orion

Вышеописанная концепция легла в основу экспериментальных квантовых процессоров канадской компании D-Wave Systems. Начав работу в 2007 году, компания прошла путь от прототипа, содержащего 16 кубитов (модель Orion), до чипов с 2000 кубитов (модель D-Wave 2000Q). Свои прототипы квантовых процессоров представили IBM, Intel, Google, Гарвардский университет и Объединённый квантовый институт в Мэриленде. У нас аналогичные проекты ведут сотрудники Российского квантового центра, Института физики твёрдого тела и МГТУ имени Баумана.

Инженеры IBM представили свою версию квантового компьютера с чипом на 20 кубитов

Инженеры Intel изготовили квантовый процессор на 50 кубитов

Появление полноценного квантового компьютера, способного решать задачи любой сложности, не за горами. Говоря о перспективах, учёные обычно приводят следующий наглядный пример. Чтобы получить доступ к зашифрованной банковской карте, нужно разложить на два простых множителя число длиной в сотни цифр. Самому мощному суперкомпьютеру Sunway TaihuLight, проводящему квадриллионы операций в секунду, на это потребуется более 15 миллиардов лет — больше, чем возраст Вселенной! А квантовому компьютеру понадобится всего несколько часов.

Современный квантовый компьютер кажется гигантским. Как и обычные компьютеры полвека назад

С помощью квантовой вычислительной техники учёные смогут мгновенно расшифровывать геном, точно предсказывать погоду и климатические изменения, определять оптимальную аэродинамику для автомобилей, самолётов и ракет, обрабатывать колоссальные массивы данных, выявляя закономерности в кажущемся хаосе. Футурологи полагают, что именно через квантовый компьютер лежит самый прямой путь к созданию искусственного интеллекта.

Современные компьютеры работают все медленнее, не справляясь с задачами, которые ставит перед ними человек. Ученые уже разрабатывают вероятностные процессоры, молекулярные, биологические, оптические и квантовые компьютеры, которые придут устаревшим машинам на смену.

Главную роль в устройстве компьютера играют электроны. Оседая в ячейках памяти и регистрах процессора, они формируют информацию, с которой работает пользователь. Но скорость электронов конечна и не очень велика. И время, которое необходимо электрону для прохождения по системе, становится решающей преградой в дальнейшем повышении производительности. Выход можно найти либо в уменьшении размеров систем, либо в новом подходе к их устройству. И поскольку бесконечно уменьшать размеры нельзя, в ход идут новые алгоритмы работы и попытки заменить электроны другими частицами.

Новые алгоритмы для старых электронов

Для задач, связанных с вычислением вероятностей, инженеры американской компании Lyric Semiconductor предлагают использовать процессоры, основанные на принципах байесовской вероятности. Они могут применяться в поисковых системах, системах финансового моделирования и биржевого прогнозирования, обработки биологических и медицинских данных. Такой подход позволяет распределить нагрузку между узлами системы, увеличить производительность и сократить время выполнения поставленных задач.

Компания Lyric Semiconductor создала первый вероятностный процессор

Принцип распределения нагрузки используют при обработке больших массивов данных. При таком подходе множество компьютеров, связанных между собой, работают как единая система. Например, самый "шустрый" процессор на сегодня имеет пиковую производительность в 24 TFlop/s, в то время как распределенная система научно-исследовательского вычислительного центра МГУ имеет пиковую производительность 420 TFlop/s.

Тем не менее все ближе тот момент, когда кремниевые процессоры не смогут справляться с поставленными задачами, даже с учетом распределения нагрузок и использования архитектур графических и дополнительных процессоров. Выход может быть найден в концептуально новых системах, не ограниченных скоростью электронов.

Компьютеры нового тысячелетия

На данный момент активно ведутся разработки молекулярных, оптических и квантовых устройств, а также ДНК-компьютеров. Сложность разработки таких систем заключается в необходимости перестроения всех основных узлов: центрального процессора, элементов памяти, устройств ввода/вывода.

В основе молекулярных компьютеров лежат бистабильные молекулы, которые могут находится в двух устойчивых термодинамических состояниях. Каждое такое состояние характеризуется своими химическими и физическими свойствами. Переводить молекулы из одного состояния в другое можно с помощью света, тепла, химических агентов, электрических и магнитных полей. По сути, эти молекулы являются транзисторами размером в несколько нанометров.

Благодаря малым размерам бистабильных молекул можно увеличить количество элементов на единицу площади. Другим достоинством молекул является малое время отклика, которое составляет порядка 10 -15 с. Сами бистабильные переключатели управляются световыми, электрическими импульсами или электрохимическими реакциями. Соединяют функциональные элементы нанотрубки или сопряженные полимеры.

Другой тип компьютеров нового поколения также основан на молекулах, но уже молекулах ДНК. Впервые ДНК–вычисления были проведены в 1994 г. Леонардом Эдлеманом (Leonard Adleman), профессором Университета Южной Калифорнии, для решения задачи коммивояжера. В ДНК–компьютерах роль логических вентилей играют подборки цепочек ДНК, которые образуют друг с другом прочные соединения. Для наблюдения состояния всей системы в последовательность внедрялись флуоресцирующие молекулы. При определенных сочетаниях свечения молекул подавляли друг друга, что соответствовало нулю в двоичной системе. Единице же соответствовало усиленное свечение флюоресцентов. Возможно строить последовательности цепочек, в которых выходной сигнал одной цепочки служит входным сигналом другой.

MAYA-II в руках исследователя. Дисплей на заднем плане показывает результат одной из игр в крестики-нолики. ДНК-компьютер (вместо ноликов он играл красными точками), как видим, выиграл у человека (синие точки, иначе — крестики)

Главное достоинство такого компьютера - работоспособность внутри тела человека, что дает возможность, например, осуществлять подачу лекарства там, где это необходимо. Также такие компьютеры позволят моментально производить идентификацию заболеваний в организме.

Еще два варианта компьютера будущего – фотонный и квантовый компьютеры. Первый работает на оптических процессах, и все операции в нем выполняются посредством манипуляции оптическим потоком. Преимущества такого компьютера заключаются в свойствах световых потоков. Скорость их распространения выше, чем у электронов, к тому же взаимодействие световых потоков с нелинейными средами не локализовано, а распределено по всей среде, что дает новые степени свободы (по сравнению с электронными системами) в организации связей и создании параллельных архитектур. Производительность оптического процессора может составлять 10 13 - 10 15 операций в секунду. На сегодняшний день есть прототипы оптических процессоров, способные выполнять элементарные операции, но полноценных и готовых к производству компьютеров нет.

Квантовый компьютер основан на законах квантовой механики. Для выполнения операций квантовый компьютер использует не биты, а кубиты – квантовые аналоги битов. В отличие от битов, кубиты могут одновременно находится в нескольких состояниях. Такое свойство кубитов позволяет квантовому компьютеру за единицу времени проводить больше вычислений. Область применения квантового компьютера – переборные задачи с большим числом итераций.

Проблема создания квантового компьютера

Все прототипы компьютеров будущего – ДНК-компьютеры, молекулярные и фотонные - разные грани одного целого - идеи создания полнофункционального квантового компьютера. Все микрочастицы, будь то кванты, атомы или молекулы, могут быть описаны волновой функцией состояния и подчиняются единым законам квантовой механики. Таким образом, работы над каждым типом компьютеров базируются на одном фундаменте. Есть у них и общие проблемы. Необходимо научиться объединять частицы в совокупности и работать как с каждой частицей в отдельности, так и с совокупностью в целом. К сожалению, на сегодняшний день технологии не позволяют производить такие манипуляции. К тому же система управления должна поддерживать масштабируемость системы частиц, благодаря которой можно наращивать мощность компьютера. Решение этой проблемы станет очередным прорывом в науке.

Над созданием квантового компьютера работают в лабораториях всего мира, в том числе и российских. Ведущие научные сотрудники Казанского физико-технического института Сергей Моисеев и Сергей Андрианов прокомментировали текущую ситуацию в этой области. С 2001 года они начали вести работы в области квантовой памяти и на сегодняшний день исследуют новые твердотельные материалы, пригодные для хранения кубитов. Также решается задача длительности хранения информации. Пока что это время составляет всего несколько миллисекунд. На вопрос, почему квантовый компьютер до сих пор не существует, отвечает Сергей Моисеев: "Насколько я себе представляю, дело в том, что сложность этой проблемы была не сразу осознана. После того как был проведен первый цикл исследований, были сформулированы проблемы, в том числе и физические, которые предстояло решить. На данный момент создание квантового компьютера напоминает своего рода современный Манхэттенский проект. Цель - создать квантовый компьютер, оперирующий 1000 кубитами, с возможностью его масштабируемости".

Однако развитие квантового компьютера тормозят не только технические проблемы, но и экономические. Долгое время на решение этой задачи выделялось крайне мало средств, особенно в России. Проект, в случае его успеха, начнет приносить доход спустя длительное время. При этом требуются крупные капиталовложения. Сейчас, когда преимущества квантового компьютера стали очевидны, начали появляться и инвестиции, но их доля относительно других отраслей по-прежнему невелика.

Что же касается ситуации в мире на сегодня, уже есть модель, работающая на двух кубитах. Конечно это не 1000, к которым стремятся ученые, но он уже может найти множители, на которые разлагается число. Потенциал же килокубитного квантового компьютера огромен. Он сможет за минуты просчитывать данные, на которые у нынешних систем уйдут годы, а то и десятилетия. С точки зрения информационной безопасности, как только будет построен квантовый компьютер, все системы защиты данных с открытым ключом рухнут, так как квантовый алгоритм позволяет быстро взломать коды. Самый производительный нынешний компьютер, если и решит эту задачу, то за несколько лет. Сегодня криптозащита держится только по той причине, что квантовый компьютер находится в самом начале своего развития. И 2-3-х кубитов не достаточно для взлома шифров.

Предвидя такое развитие событий, компании задумываются о квантовой криптографии, против которых компьютер нового поколения будет бессилен. Особенность квантовой криптозащиты в том, что при попытке "подслушать" информацию она разрушается по закону неопределенности Гейзенберга. Таким образом, при попытке получить доступ к зашифрованному потоку, информация в нем будет утеряна. Однако не стоит считать неуязвимость квантовой криптозащиты абсолютной, как и в любой системе, в ней есть свои слабые места.

На данный момент в Швейцарии уже действует квантовый интернет, протяженность сети составляет 100 км. Уже три года он связывает Женеву и Цюрих. В основе передачи информации такой сетью лежит квантовая сцепленность – явление при котором квантовые состояния двух или более объектов влияют друг на друга, даже если они разнесены в пространстве. Достоинство сети - в ее безопасности. При попытке "подслушать" трафик сети извне сигнал искажается, что сигнализирует принимающей стороне о попытке перехвата. Для того чтобы проложить такой интернет на больших расстояниях, требуется квантовый репитер, который будет пересылать сигнал. И в Европе уже созданы сообщества по работе над ним.

Сергей Андрианов дополняет: "Ближайшая реализация квантового компьютера – система finger printing в научном мире известная, как метод характеристических признаков. Она будет содержать примерно 20 - 30 кубитов и предназначена для выделения "струны" – последовательности данных, содержащей небольшой бит информации - неких характеристических признаков - из базы данных. И если сравнить эту струну со струной из другой базы, то с определенной долей вероятности можно определить, одинаковые эти базы данных или нет. В течение нескольких ближайших лет фирма HP собирается представить такой компьютер, работающий на квантовых точках". Нити с определенной вероятностью довольно точно описывают исходную базу. И если две выбранные последовательности признаков совпадают, то можно предположить, что и исходные базы данных одинаковы. Например, при сканировании сетчатки глаза в системе контроля доступа можно снимать информацию не обо всей сетчатке, а только определенные параметры. Совокупность таких параметров и будет струной. При последующей идентификации можно снять те же параметры с представленной сетчатки и, если последовательности параметров совпадут, можно предположить, что сетчатки одинаковы, а стало быть - принадлежат одному человеку.

Представление электронно-вычислительной машины (ЭВМ) пятого поколения. Японская модель компьютера, ее замысел и первичные разработки. Необходимость создания ЭВМ и основные цели проекта. Реальность и трудность реализации проекта. Компьютеры и марксизм.

| Рубрика | Программирование, компьютеры и кибернетика |

| Вид | реферат |

| Язык | русский |

| Дата добавления | 09.12.2014 |

| Размер файла | 32,2 K |

Студенты, аспиранты, молодые ученые, использующие базу знаний в своей учебе и работе, будут вам очень благодарны.

ФЕДЕРАЛЬНОЕ АГЕНСТВО ЖЕЛЕЗНОДОРОЖНОГО ТРАНСПОРТА

ФЕДЕРАЛЬНОЕ ГОСУДАРСТВЕННОЕ БЮДЖЕТНОЕ ОБРАЗОВАТЕЛЬНОЕ УЧРЕЖДЕНИЕ ВЫСШЕГО ПРОФЕССИОНАЛЬНОГО ОБРАЗОВАНИЯ

Студентка ГМН 114

1. Определение термина. Что представляет из себя ЭВМ 5-го поколения

2. Японская модель компьютера, её замысел и первичные разработки

3. Необходимость создания. Основные цели проекта

4. Международный резонанс и параллельное создание суперкомпьютера МАРС в СССР

5. Реальность, трудность реализации проекта

6. Оценка проекта

7. Компьютеры и марксизм (будущее)

Список использованных источников

Введение

Любой учебник информатики начинается с перечисления поколений вычислительной техники. ЭВМ первого поколения были основаны на электронных лампах. Их сменили вычислительные машины второго поколения, сделанные из транзисторов. Интегральные микросхемы позволили построить компьютеры третьего, а микропроцессоры -- четвёртого поколения. На этом компьютерная история неожиданно обрывается, а мы зависаем в странной реальности, где ничего не происходит. Прошло три с лишним десятилетия, но пятое поколение так и не наступило, хотя имелись неплохие перспективы.

1. Определение термина. Что представляет из себя ЭВМ 5-го поколения

Переход к компьютерам пятого поколения предполагал переход к новым архитектурам, ориентированным на создание искусственного интеллекта.

ЭВМ 5-го поколения должна была иметь развитую периферийную систему, различать звуковую, зрительную, сенсорную информацию и обрабатывать её по законам деятельности человеческого мозга. Для перехода к таким ЭВМ было определено требование к новой технологической базе и ставились совершенно другие задачи, нежели при разработки всех прежних ЭВМ. Если перед разработчиками ЭВМ с I по IV поколений стояли такие цели, как увеличение производительности в области числовых расчётов, достижение большой ёмкости памяти, то основной задачей разработчиков ЭВМ V поколения является создание искусственного интеллекта машины, развитие "интеллектуализации" компьютеров - устранения барьера между человеком и компьютером. Компьютеры должны были способны воспринимать информацию с рукописного или печатного текста, с бланков, с человеческого голоса, узнавать пользователя по голосу, осуществлять перевод с одного языка на другой. Это позволило бы общаться с ЭВМ всем пользователям, даже тем, кто не обладает специальными знаниями в этой области. ЭВМ должен был стать помощником человека во всех областях.

Основные требования к компьютерам 5-го поколения:

1) Создание развитого человеко-машинного интерфейса (распознавание речи, образов);

2) Развитие логического программирования для создания баз знаний и систем искусственного интеллекта;

3) Создание новых технологий в производстве вычислительной техники;

4) Создание новых архитектур компьютеров и вычислительных комплексов.

Для этого требовалось высокое быстродействие вычислительной системы и большой объем памяти. Универсальные компьютеры производили высокоскоростные вычисления, но не были пригодны для выполнения данных операций сравнения и сортировки больших объемов записей, хранящихся обычно на магнитных дисках. Были созданы специальные логические языки программирования, обеспечивающие наибольшие возможности по сравнению с обычными процедурными языками.

Первые суперкомпьютеры появились уже среди компьютеров второго поколения (1955 - 1964). Они были предназначены для решения сложных задач, требовавших высокой скорости вычислений. Это LARC фирмы UNIVAC, Stretch фирмы IBM и "CDC-6600" фирмы Control Data Corporation, в них были применены методы параллельной обработки (увеличивающие число операций, выполняемых в единицу времени), конвейеризация команд (когда во время выполнения одной команды вторая считывается из памяти и готовится к выполнению). Компьютеры, выполняющие параллельно несколько программ при помощи нескольких микропроцессоров, получили название мультипроцессорных систем.

Отличительной особенностью суперкомпьютеров являются векторные процессоры, оснащенные аппаратурой для параллельного выполнения операций с многомерными цифровыми объектами - векторами и матрицами. В них встроены векторные регистры и параллельный конвейерный механизм обработки.

ЭВМ пятого поколения -- это ЭВМ будущего. Программа разработки, так называемого, пятого поколения ЭВМ была принята в Японии. Предполагалось, что к 1991 г. будут созданы принципиально новые компьютеры, ориентированные на решение задач искусственного интеллекта. С помощью языка Пролог и новшеств в конструкции компьютеров планировалось вплотную подойти к решению одной из основных задач этой ветви компьютерной науки - задачи хранения и обработки знаний. Коротко говоря, для компьютеров пятого поколения не пришлось бы писать программ, а достаточно было бы объяснить на "почти естественном" языке, что от них требуется.

2. Японская модель компьютера, её замысел и первичные обработки

Использование этого термина должно было подчеркнуть, что Япония планирует совершить новый качественный скачок в развитии вычислительной техники.

Главные направления исследований были следующими:

· Технологии логических заключений для обработки знаний.

· Технологии для работы со сверхбольшими базами данных и базами знаний.

· Рабочие станции с высокой производительностью.

· Компьютерные технологии с распределёнными функциями.

· Суперкомпьютеры для научных вычислений.

В 1982 году, в Японии началась разработка супер-эпохального компьютера - Компьютера пятого поколения. Речь шла о компьютере с параллельными процессорами, работающим с данными, хранящимися в обширной базе данных, а не в файловой системе. При этом, доступ к данным должен был осуществляться с помощью языка логического программирования. Предполагалось, что прототип машины будет обладать производительностью между 100 млн и 1 млрд LIPS(логическое заключение в секунду). К тому времени типовые рабочие станции были способны на производительность около 100 тысяч LIPS.

Ход разработок представлялся так, что компьютерный интеллект, набирая мощность, начинает изменять сам себя, и целью было создать такую компьютерную среду, которая сама начнёт производить следующую, причём принципы, на которых будет построен окончательный компьютер, были заранее неизвестны, эти принципы предстояло выработать в процессе эксплуатации начальных компьютеров. Далее, для резкого увеличения производительности, предлагалось постепенно заменять программные решения аппаратными. Эту программу предполагалось реализовать за 10-11 лет, 3 года для начальных исследований и разработок, 4 года для построения отдельных подсистем, и последние 4 года для завершения всей прототипной системы.

Целью всего проекта - было создание компьютера, который мог решать сверхсложные задачи за самые короткие промежутки времени, управлять большими системами и обладать высокоразвитым искусственным интеллектом (вплоть до того, что компьютер должен был писать программы сам для себя). По мнению Японских ученых компьютеры нового поколения должны строиться по принципу совмещения огромного количества процессоров.

В 1992 году стало очевидно - проект Компьютер Пятого Поколения - обречен на провал. В финансовом плане правительство потратило больше чем 50 миллиардов Йен, а цель, поставленная в начале, так и не была достигнута. Рабочие станции компьютера пятого поколения так и не увидели свет в связи с тем, что однопроцессорные компьютеры других фирм обгоняли их по параметрам производительности. К тому же появление общественных сетей (Интернет) рушило всю концепцию первоначального проекта. Основными причинами считается целый ряд факторов. Основные из них - ошибочная оценка тенденций развития компьютеров, отсутствие опыта в разработках подобных технологий, ошибочный выбор языков программирования (изначально был выбран язык Пролог, которые не поддерживал параллельное программирование, что в корне не соответствовало поставленным изначально задачам).

1981 год: начало

пятый поколение японский компьютер

3. Необходимость создания. Основные цели проекта

1. Ограничить ввод текста. Компьютер должен набирать символы под диктовку. Эта проблема особенно остро стояла в Японии, где существовала определенная сложность с набором иероглифов.

2. Автоматический перевод с любого языка на любой другой, что способствовало бы устранению языкового барьера на международной арене. И, конечно же, все это должно осуществляться под диктовку.

3. Поиск смысла в статьях, категоризация и автоматическое реферирование.

4. Также планировалось внедрение многих криптографических, анализаторских, распознавательных функций.

Сама конечная цель ученым представлялась так:

Первичный компьютер под воздействием анализа исполняемых им задач будет сам себя совершенствовать. Причем конечный результат и принципы, которые будут заложены в этот компьютер заранее, неизвестны. Принципы планировалось вырабатывать в процессе первичной работы начальной работы первичных компьютеров.

Таким образом, предлагаемая в проекте ЭВМ пятого поколения технология подготовки прикладных задач к решению на компьютере включает два этапа и представлена на рисунке:

1) программист создает пустую программную оболочку

2) заказчик (конечный пользователь) наполняет оболочку знаниями

Наполненная знаниями конечного пользователя программная оболочка готова к решению тех прикладных задач, правила, решения которых внес в нее конечный пользователь. Таким образом, начинается эксплуатация программного продукта. Предлагаемая технология имеет много серьезных проблем, связанных с представлением и манипулированием знаниями. Тем не менее, с ней связывают прорыв в области проектирования прикладных программных продуктов.

Новые технические возможности вычислительной техники должны были расширить круг решаемых задач и позволить перейти к задачам создания искусственного интеллекта. В качестве одной из необходимых для создания искусственного интеллекта составляющих являются базы знаний (базы данных) по различным направлениям науки и техники. Для создания и использования баз данных требуется высокое быстродействие вычислительной системы и большой объем памяти. Универсальные компьютеры способны производить высокоскоростные вычисления, но не пригодны для выполнения с высокой скоростью операций сравнения и сортировки больших объемов записей, хранящихся обычно на магнитных дисках. Для создания программ, обеспечивающих заполнение, обновление баз данных и работу с ними, были созданы специальные объектно-ориентированные и логические языки программирования, обеспечивающие наибольшие возможности по сравнению с обычными процедурными языками. Структура этих языков требует перехода от традиционной фон-неймановской архитектуры компьютера к архитектурам, учитывающим требования задач создания искусственного интеллекта.

4. Международный резонанс и параллельное создание суперкомпьютера МАРС в СССР

Программы создания ЭВМ 5-го поколения получили большой резонанс в мире промышленно развитых стран и единодушно охарактеризованы мировой научной общественностью как наиболее претенциозными в области вычислительной техники за всю историю ее развития.

В отличие от японцев, задача интеграции огромного числа процессоров не ставилась, речь шла об архитектуре, поддерживающей язык высокого уровня типа Модула-2 и параллельные вычисления. Весь проект базировался на старых инженерно-технических решениях. Поэтому проект нельзя назвать пятым поколением в японской терминологии.

5. Реальность, трудность реализации

Первая проблема заключалась в том, что язык Пролог, выбранный за основу проекта, не поддерживал параллельных вычислений. Пришлось разрабатывать собственный язык, способный работать в мультипроцессорной среде. Это оказалось трудным -- было предложено несколько языков, каждый из которых обладал собственными ограничениями.

Идея саморазвития системы, по которой система сама должна менять свои внутренние правила и параметры, оказалась непродуктивной -- система, переходя через определённую точку, скатывалась в состояние потери надёжности и утраты цельности, резко становилась неадекватной.

Идея широкомасштабной замены программных средств аппаратными оказалась несвоевременной, в дальнейшем развитие компьютерной индустрии пошло по противоположному пути, совершенствуя программные средства при более простых, но стандартных аппаратных. Проект был ограничен категориями мышления 1970-х годов и не смог провести чёткого разграничения функций программной и аппаратной части компьютеров.

6. Оценка проекта

Планы замены программных средств их аппаратными аналогами, был неудачен. Такое виденье у инженеров было в предыдущем поколении компьютеров. Но на сегодняшний день. Ситуация изменилась в корне. Процесс развития информационных технологий пошел по обратному пути. Аппаратное обеспечение упрощалось. Предоставляя универсальность. А все задачи перекладывались на программное обеспечение.

Идеи Японских ученых были не удачными. Изначально был не верно выбран вектор развития компьютеров. Перспектива развития аппаратных средств была недооценена. Возможности в развитии искусственного интеллекта были переоценены. Даная область оказалась сложнее чем рассчитывали. Многие теоретические разработки в данной области так и не нашли своего практического применения. Искусственный интеллект так и не вышел за рамки академических задач. Многие методы так и остались забавой ученных.

Появился графический интерфейс пользователя. Который изначально не был предусмотрен в компьютерах пятого поколения. Появился Интернет, который изменил представления о структуре хранения и обработки информации. Развивались поисковые машины, которые использовали новые методы обработки данных.

Планы замены программных средств их аппаратными аналогами, был неудачен. Такое виденье у инженеров было в предыдущем поколении компьютеров. Но на сегодняшний день. Ситуация изменилась в корне. Процесс развития информационных технологий пошел по обратному пути. Аппаратное обеспечение упрощалось. Предоставляя универсальность. А все задачи перекладывались на программное обеспечение.

Идеи Японских ученых были не удачными. Изначально был не верно выбран вектор развития компьютеров. Перспектива развития аппаратных средств была недооценена. Возможности в развитии искусственного интеллекта были переоценены. Даная область оказалась сложнее чем рассчитывали. Многие теоретические разработки в данной области так и не нашли своего практического применения. Искусственный интеллект так и не вышел за рамки академических задач. Многие методы так и остались забавой ученных.

С любых точек зрения проект можно считать абсолютным провалом. За десять лет на разработки было истрачено более 500 млн $ и программа завершилась, не достигнув цели. Рабочие станции так и не вышли на рынок, потому что однопроцессорные системы других фирм превосходили их по параметрам, программные системы так и не заработали, появление Интернета сделало все идеи проекта безнадёжно устаревшими.

Неудачи проекта объясняются сочетанием целого ряда объективных и субъективных факторов:

• ошибочная оценка тенденций развития компьютеров -- перспективы развития аппаратных средств были катастрофически недооценены, а перспективы искусственного интеллекта - переоценены, многие из планируемых задач искусственного интеллекта так и не нашли эффективного коммерческого решения до сих пор, в то время как мощность компьютеров несоизмеримо выросла;

• ошибочная стратегия, связанная с разделением задач, решаемых программно и аппаратно. Проявилась в стремлении к постепенной замене программных средств аппаратными, что привело к излишнему усложнению аппаратных средств;

• отсутствие опыта и глубинного понимания специфики задач искусственного интеллекта с надеждой на то, что увеличение производительности и неведомые базовые принципы системы приведут к её самоорганизации;

• резко увеличение затратов на коммуникацию между отдельными процессорами, которые почти не улучшает производительности системы;

• низкий общий уровень технологии программирования того времени и диалоговых средств ( ярко выявилось в 1990-е годы);

7. Компьютеры и марксизм (будущее)

Концепции, в которых рассматриваются проблемы, связанные с происхождением, структурой научного знания, его развитием и ролью в общественной жизни, относятся к философии науки. Решаются же они на интуитивном уровне, руководствуясь деловыми потребностями. При этом разработчики вынуждены действовать эмпирически, весьма нерациональным способом проб и ошибок. Пока это, вероятно, единственно возможный путь создания ЭВМ 5-го поколения. При этом на содержательном уровне будут накоплены новые принципиальные решения. Следующее 6-ое поколение ЭВМ (по аналогии с развитием ЭВМ 4-го поколения) будет связано с дальнейшим экстенсивным развитием ЭВМ путем количественного улучшения функциональных характеристик ЭВМ 5-го поколения. Появление следующего 7-го поколения ЭВМ может быть связано уже с новым качественным скачком в развитии ЭВМ 5-го поколения за счет создания теории"естественных мыслительных процессов", освоения содержательного уровня и разработки технических средств, манипулирующих "понятиями" - формализованными образами объективного и субъективного мира. Примером ЭВМ 7-го поколения может быть вычислительная система, заменяющая группу референтов при руководителе высокого ранга.

Уже сейчас компьютеры способны воспринимать информацию с рукописного или печатного текста, с бланков, с человеческого голоса, узнавать пользователя по голосу, осуществлять перевод с одного языка на другой. Это позволяет общаться с компьютерами всем пользователям, даже тем, кто не имеет специальных знаний в этой области.

Многие успехи, которых достиг искусственный интеллект, используют в промышленности и деловом мире. Экспертные системы и нейронные сети эффективно используются для задач классификации (фильтрация СПАМа, категоризация текста и т.д.). Добросовестно служат человеку генетические алгоритмы (используются, например, для оптимизации портфелей в инвестиционной деятельности), робототехника (промышленность, производство, быт - везде она приложила свою кибернетическую руку), а также многоагентные системы. Не дремлют и другие направления искусственного интеллекта, например распределенное представление знаний и решение задач в интернете: благодаря им в ближайшие несколько лет можно ждать революции в целом ряде областей человеческой деятельности.

К сожалению, японский проект ЭВМ пятого поколения повторил трагическую судьбу ранних исследований в области искусственного интеллекта. Более 50-ти миллиардов йен инвестиций были потрачены впустую, проект прекращен, а разработанные устройства по производительности оказались не выше массовых систем того времени.

Список использованных источников

Читайте также: