Музыка и искусственный интеллект возможно ли сотрудничество сочинение

Обновлено: 05.07.2024

Исследования в искусственный интеллект (AI) известно, что повлияло медицинский диагноз, торговля акциями, управление роботом, и несколько других полей. Возможно, менее популярен вклад ИИ в области Музыка. Тем не менее, искусственный интеллект и музыка (AIM) долгое время были общей темой на нескольких конференциях и семинарах, в том числе Международная компьютерная музыкальная конференция, конференция компьютерного общества [1] и Международная совместная конференция по искусственному интеллекту. Фактически, первой Международной конференцией компьютерной музыки была ICMC 1974 года, Университет штата Мичиган, Ист-Лансинг, США. [2] Текущие исследования включают применение ИИ в музыкальная композиция, спектакль, теория и цифровой обработка звука.

Несколько музыкальное программное обеспечение были разработаны программы, использующие ИИ для создания музыки. [3] Как и его приложения в других областях, A.I. в этом случае также моделирует умственные задачи. Важной особенностью является способность A.I. алгоритм обучения на основе полученной информации, такой как технология компьютерного сопровождения, которая способна слушать и следовать за человеком-исполнителем, чтобы он мог работать синхронно. [4] Искусственный интеллект также управляет так называемой технологией интерактивной композиции, при которой компьютер сочиняет музыку в ответ на выступление живого музыканта. Есть несколько других А.И. приложения к музыке, которые охватывают не только состав, производство и исполнение музыки, но также то, как она продается и используется.

Содержание

История

В 1960 году русский исследователь Р. Х. Зарипов опубликовал первую в мире статью об алгоритмическом сочинении музыки с использованием "Урал-1"компьютер. [5]

В 1997 году программа искусственного интеллекта под названием Эксперименты в области музыкального интеллекта (EMI), похоже, превзошел композитора-человека в задаче сочинения музыкального произведения, имитирующего стиль Бах. [7]

Программные приложения

Интерактивные партитуры

Мультимедийные сценарии в интерактивных партитурах представлены временными объектами, временными отношениями и интерактивными объектами. Примерами временных объектов являются звуки, видео и элементы управления освещением. Временные объекты могут запускаться интерактивными объектами (обычно запускаемыми пользователем), а несколько временных объектов могут выполняться одновременно. Временной объект может содержать другие временные объекты: эта иерархия позволяет нам управлять началом или концом временного объекта, управляя началом или концом его родителя. Иерархия присутствует всегда во всех видах музыки: музыкальные произведения часто иерархически иерархичны по движениям, частям, мотивам, тактам и другим сегментам. [8] [9]

Компьютерное сопровождение (Университет Карнеги-Меллона)

ChucK

ChucK - это текстовый кроссплатформенный язык, разработанный в Принстонском университете Ге Вангом и Перри Куком, который обеспечивает синтез, композицию, исполнение и анализ музыки в реальном времени. [11] Он используется SLOrk (Стэнфордский оркестр ноутбуков) [12] и PLOrk (Принстонский оркестр ноутбуков).

MorpheuS

MorpheuS [13] это исследовательский проект Дориен Херреманс и Элейн Чу в Лондонский университет королевы Марии, финансируется проектом Марии Склодовской-Кюри ЕС. Система использует подход к оптимизации, основанный на алгоритме поиска переменной окрестности, чтобы преобразовать существующие части шаблона в новые части с заданным уровнем тонального напряжения, которое динамически изменяется по всей части. Этот подход к оптимизации позволяет интегрировать метод обнаружения паттернов, чтобы обеспечить долгосрочную структуру и повторяющиеся темы в сгенерированной музыке. Произведения MorpheuS исполнялись на концертах как в Стэнфорде, так и в Лондоне.

Об эксперте: Ольга Перепелкина, эксперт в области машинного обучения и нейросетей, преподаватель и автор курса Affective Computing в ВШЭ.

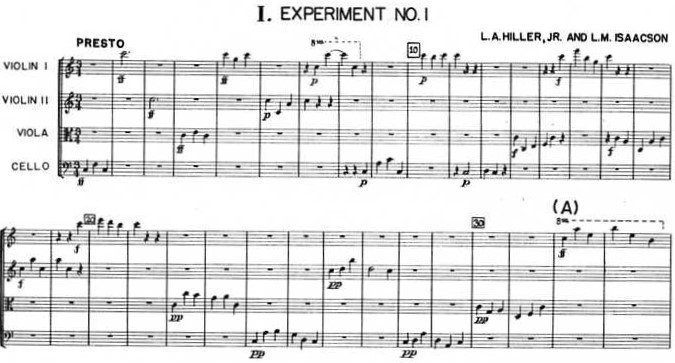

В том же году The Illiac Suite стала первой партитурой, написанной компьютером. Она был названа в честь компьютера ILLIAC I университета штата Иллинойс в США. Это ранний пример алгоритмической композиции, основанной на вероятностном моделировании (цепях Маркова). В области синтеза звука знаменательным событием стал выпуск синтезатора DX 7 компанией Yamaha в 1983 году, использующего модель синтеза на основе частотной модуляции (FM).

Генерация музыки

Когда мы говорим о создании музыки при помощи компьютера, речь может идти как об ассистивной системе или компьютерной среде, помогающей музыкантам (композиторам, аранжировщикам, продюсерам), так и об автономной системе, нацеленной на создание оригинальной музыки. В обоих типах систем могут участвовать нейросетевые алгоритмы и глубокое обучение.

Мы также можем говорить о разных этапах создания музыки, где искусственный интеллект встраивается в процесс и помогает нам: сочинение, аранжировка, оркестровка и т.д. Когда человек сочиняет музыку, он редко создает новое произведение с нуля. Он повторно использует или адаптирует (сознательно или бессознательно) музыкальные элементы, которые слышал ранее, а также руководствуется принципами и рекомендациями из теории музыки. Так и компьютерный помощник может включаться на различных этапах создания произведения, чтобы инициировать, предлагать или дополнять композитора-человека.

Генерация нот

Традиционным подходом является создание музыки в символической форме. Результатом процесса генерации может быть музыкальная партитура, последовательность событий MIDI (распространенный стандарт цифровой звукозаписи), простая мелодия, последовательность аккордов, текстовое представление или какое-либо другое представление более высокого уровня. То есть искусственный интеллект создает символическую форму, по которой затем можно сыграть произведение.

Генерация аудио

Но символический подход не позволяет создать нюансы человеческого голоса и различные характеристики тембра, динамики и выразительности музыкального произведения. Другой способ — это создавать музыку напрямую в виде аудиосигнала. Сложность этого подхода в том, что последовательность, которую мы в таком случае пытаемся создать — очень длинная. Например, для песни в несколько минут в хорошем студийном качестве это будет десятки миллионов значений.

В апреле 2020 года, компания OpenAI выпустила Jukebox, — нейросеть, которая генерирует музыку в различных жанрах. Она может сгенерировать даже элементарный голос, а также различные музыкальные инструменты. Jukebox создает аудиосигнал напрямую, минуя символьное представление. Такие музыкальные модели имеют гораздо большую емкость и сложность, чем их символьные аналоги, что подразумевает более высокие вычислительные требования для обучения модели.

Как творят нейросети?

Для обучения модели Jukebox использовал базу данных из 1,2 млн песен (600 тыс. из которых на английском языке), которая включала как сами композиции, так и тексты песен и метаданные — исполнителя, жанр и ключевые слова.

Музыкальный тест Тьюринга

Как понять, что музыкальное произведение, созданное машиной, действительно достойно нашего внимания? Для проверки работы систем искусственного интеллекта был придуман тест Тьюринга. Его идея заключается в том, что человек взаимодействует с компьютерной программой и с другим человеком. Мы задаем вопросы программе и человеку и пытаемся определить, с кем же мы разговариваем. Тест считается пройден программой, если мы не можем отличить программу от человека.

В области создания аудио успехи пока не столь впечатляющие. Несмотря на то, что Jukebox представляет собой смелый шаг вперед в плане качества музыки, длины аудио и способности настроиться на исполнителя или определенный жанр, различия между искусственной музыкой и произведениями, созданными людьми, все еще заметны. Так, в мелодиях от Jukebox хоть и есть традиционные аккорды и даже впечатляющие соло, мы не слышим крупные музыкальные структуры, такие как повторяющиеся припевы. Также в искусственных произведениях слышны шумы, связанные со способом работы моделей. Скорость генерации музыки также пока еще невысока — для полного рендеринга одной минуты звука с помощью Jukebox требуется около девяти часов, поэтому их пока нельзя использовать в интерактивных приложениях.

А как же лирика?

Сейчас спою

Музыку мы создавать научились, стихи для нее писать — тоже, а как же быть с человеческим голосом? Могут ли нейросети петь вместо нас?

Генерация реалистичного человеческого голоса нужна не только для пения, но и во многих системах — от call-центров до личных голосовых помощников. Еще в 2016 году компания DeepMind выпустила алгоритм WaveNet, который создает очень реалистичный голос по заданному тексту (Text-To-Speech). Технология доступна для двух языков — английского и китайского.

В апреле 2020 года в ByteDance AI Lab (лаборатории компании, создавшей знаменитый TikTok) создали алгоритм ByteSing. Эта система на основе нейросетевых автокодировщиков позволяет генерировать очень реалистичное пение на китайском языке.

Большинство разработчиков современных алгоритмов генерации музыки, стихов и пения отмечают, что их системы являются ассистивными. Они не претендуют на полноценную замену человеческого творчества, а, напротив, призваны помочь человеческой музе. Человек не перестанет творить по мере развития алгоритмов и программ, но будет использовать их в своей деятельности. Очень вероятно, что в будущем великие шедевры будут созданы людьми и искусственным интеллектом совместно.

Умение создавать музыку без возможности услышать её привычным способом – уникальная способность, которая требует от человека дополнительных навыков и усилий. Истории известны единицы композиторов, потерявших слух на каком-то этапе своей жизни, и, пожалуй, самым известным среди них является Бетховен. Однако в нашей статье речь пойдёт не о музыкальных гениях среди людей, а о современных технологиях, которые, возможно, уже в ближайшем будущем перевернут все принятые правила написания текстов и музыки и откроют новую эру в искусстве.

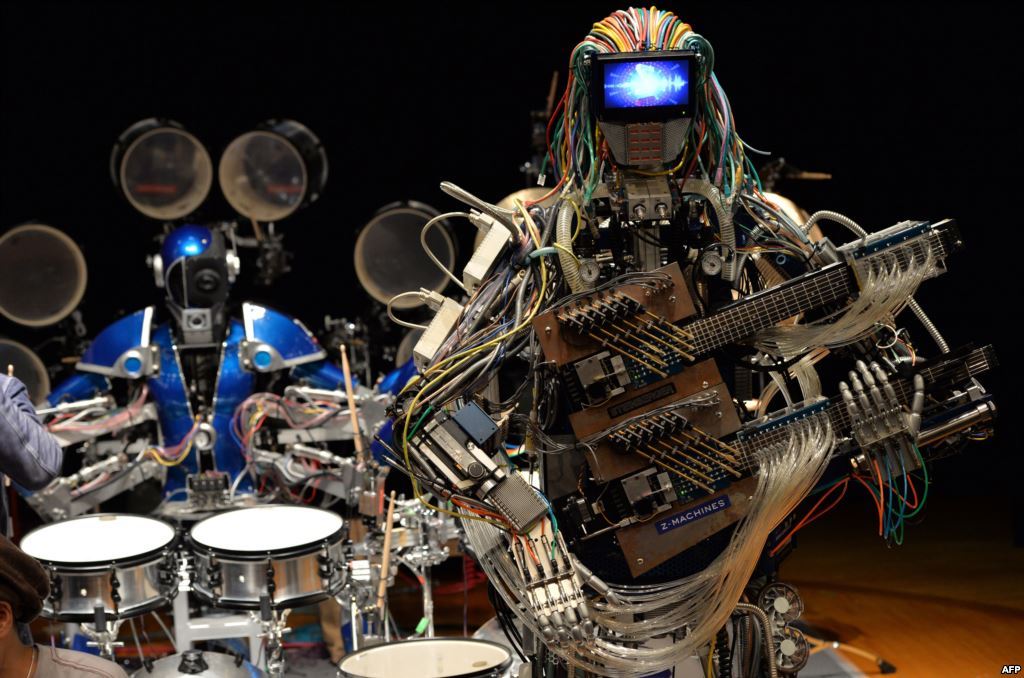

Зачастую создание новой композиции – процесс, в котором принимают участие несколько человек, и музыка рождается в результате тесного сотрудничества и слияния идей. С развитием компьютерных технологий, в особенности искусственного интеллекта, люди всё чаще обращаются к машинам за помощью в генерировании мелодий и текстов. Эксперты уверены, что подобные тенденции могут быть началом революции в музыкальной сфере.

История музыки компьютерных технологий

Courtesy of the University of Illinois Archives

Впервые искусственный интеллект применили для создания музыки в 1987 году. Дэвид Коуп, бывший профессор музыки в Калифорнийском университете в Санта-Крузе, создал умную машину, получившую имя ЭМИ (EMI, Experiments in Musical Intelligence). Анализируя отрывки произведений определённого жанра, она могла генерировать уникальные структурированные композиции в рамках этого жанра. Всего ЭМИ создала более тысячи произведений на основе творчества 39 композиторов, которые представляли разные музыкальные стили. Коуп рассказал, что поначалу эта музыка вызывала у слушателей шок и даже страх от осознания того, что она была написана машиной, но постепенно реакция стала более позитивной.

Использование искусственного интеллекта – это естественное развитие степени интеграции технологий в индустрию музыки. Например, многодорожечная запись значительно упростила жизнь музыкантам: появилась возможность отдельные части композиции записывать последовательно, чтобы в итоге объединить их в общую звуковую картину. В 90-х Дэвид Боуи совместно с Тайем Робертсом разработал программу The Verbasizer, которая генерировала случайные предложения – они служили вдохновением для написания текстов. Современным музыкантам прекрасно знакомы виртуальные интерфейсы музыкальных инструментов вроде Midi, а исполнители не гнушаются обрабатывать свой вокал с помощью автотюна.

Reeps One performs on stage at the Drum

Команда дочерней компании Google DeepMind решила развивать подобный концепт ещё дольше в рамках нового проекта WaveNet. Специалисты планируют создать ряд аудио моделей, на основе которых ИИ сможет подражать человеческому голосу. Таким образом ИИ сможет не просто сочинять музыку, но и исполнять собственные произведения.

На другой стороне музыкального спектра группа Dadabots в лице Си Джея Карра и Зака Зуковски использует ИИ, чтобы создавать новые композиции в стиле блэк-метал. Программа работает на основе уже знакомого нам метода: анализируя уже существующие записи блэк-метал композиций, искусственный интеллект генерирует новые гибридные комбинации, а Си Джей и Зак сочетают полученные звуки на свой вкус. Подобные технологии находятся только на ранней стадии развития, но Карр и Зуковски уверены, что следующие поколения программ ИИ будут гораздо проще в применении, а их работа будет больше соответствовать пожеланиям слушателей.

Новые технологии способны значительно упростить жизнь начинающих музыкантов и режиссёров, программы искусственного интеллекта могут сэкономить их время и деньги, ускоряя процесс обнаружения новых талантов. Например, британская компания Instrumental разработала собственную программу, которая обрабатывает новые видео- и аудиозаписи исполнителей-аматеров на нескольких социальных платформах (Spotify, YouTube, Instagram и т.п.) и определяет, кто из них имеет наибольший потенциал. Впоследствии компания предлагает некоторым из них контракты и поддерживает в дальнейшем развитии.

Такое тесное сотрудничество людей и машин в скором будущем сотрёт границы между авторами и потребителями продукта. Человечество уже находится на пороге эры гипер-персонализации, когда клиенты ожидают от услуг полного соответствия их предпочтениям. Например, Apple Music, Deezer и Spotify уже используют технологии ИИ, чтобы предлагать слушателям новую музыку, которая бы им наверняка понравилась. Разработчики Google Play пошли ещё дальше: приложение анализирует информацию вроде местоположения пользователя, его увлечений и даже погоды, чтобы в нужный момент предложить подходящую песню. Некоторые устройства, например, смарт-колонка Echo от Amazon оснащена функцией DeepMusic, которая позволяет пользователям генерировать собственные треки и сразу же проигрывать их.

Вполне естественно, что подобные перспективы развития музыки будущего вызывают опасения среди артистов, которые не желают уступать собственную аудиторию машинам. Многие люди уверены, что искусственный интеллект, каких бы уровней развития он не достиг, просто не сможет понять такие тонкие вещи как человеческий разум и отношения между людьми, которые, как правило, и вдохновляют нас на творчество. Музыка была спутником человечества на протяжении десятков тысяч лет и оценить её силу может только человек. Вспоминая то, как близкие отношения с Джоном Ленноном содействовали их взаимопониманию при написании новых песен, Пол Маккартни говорил, что никакие технологии не смогут повторить успех произведений, созданных под влиянием искренних человеческих эмоций.

Нам же остаётся только ждать и наблюдать, как сложится путь эволюции музыки в будущем, ведь, как пели The Beatles: tomorrow never knows.

Содержание

2019: Warner Music заключила первый в истории контракт с исполнителем-алгоритмом Endel

Endel разработан одноименным стартапом, сооснователем и исполнительным директором которого выступает игровой журналист россиянин Олег Ставицкий. По утверждению разработчиков алгоритма, Endel адаптируется к настроению пользователя и помогает ему в зависимости от поставленных задач — музыка нейросети помогает заниматься спортом, работать, засыпать или медитировать. При этом ИИ сам определяет, что требуется человеку в данный момент, анализируя множество параметров: время суток, геолокацию, погоду за окном, пульс и частоту биения сердца человека.

На пересечении двух растущих индустрий

Ожидается [1] , что в мировом масштабе доход компаний от использования искусственного интеллекта составит $1,2 трлн по итогам 2018 года, что на 70 процентов больше по сравнению с 2017 годом, а в 2022 году, по прогнозам, эти выгоды достигнут $3,9 трлн. И такой быстрый рост уже далеко ни для кого не тайна: искусственный интеллект можно назвать определяющей технологией 21-го века. Искусственный интеллект отличается от традиционных программ анализа данных своей способностью учиться распознавать шаблоны с помощью алгоритмов машинного обучения, а затем принимать автономные решения на основе этих шаблонов, будучи явно не запрограммированным на это.

В то же время, мировой рынок программного обеспечения для производства музыки, по прогнозам [2] , вырастет до $6,26 млрд к концу 2022 года. Ключевым фактором, который будет стимулировать рост индустрии, является растущий спрос на цифровой аудио-контент во всем мире. Аудио-контент, в свою очередь, набирает популярность в связи с недавно начавшимся ростом [3] потоковых (стриминговых) сервисов. Это приводит к увеличению числа исполнителей и музыкальных продюсеров, создающих музыкальный контент, что, в конечном итоге, увеличивает спрос на программное обеспечение для сочинения музыки. Алгоритмы ИИ уже несколько лет используются для определения музыкального вкуса и настройки персональных рекомендаций на потоковых сервисах, и на фоне всплеска исследований и инвестиций в технологию искусственного интеллекта в целом, произошел шквал активности [4] вокруг предмета сочинения музыки с помощью этой технологии. И по прогнозам [5] , ИИ сильно повлияет на процесс создания музыкального контента.

Примеры использования: крупные компании

NSynth Super (Google)

NSynth Super [6] является частью продолжающегося эксперимента под именем Magenta [7] : исследовательского проекта в Google, который "изучает, как технология машинного обучения может помочь деятелям искусства творить по-новому" и взглянуть на творческий процесс с другого ракурса.

Различные звуковые эффекты [8] , изменяющие частоту и амплитуду звука, электрические музыкальные инструменты [9] — всё это примеры других звучаний, созданных с помощью технологий. Теперь в список таких технологий можно включить и машинное обучение, потому что прогресс в этой области открывает нетрадиционные возможности для генерации необычного звучания.

Основываясь на прошлых исследованиях в этой области, Magenta создала NSynth (Neural Synthesizer (прим. Нейронный Синтезатор)) — алгоритм машинного обучения, который использует глубокую нейронную сеть для изучения различных характеристик звука, а затем создает совершенно другое звучание на их основе. По словам разработчиков [10] , вместо того, чтобы комбинировать или смешивать звуки, NSynth синтезирует звук, используя акустические качества оригинальных звуков. Благодаря этому можно получить звук, который является и звучанием флейты, и звучанием ситара, — всем сразу.

С момента релиза алгоритма NSynth, Magenta продолжала экспериментировать с различными музыкальными интерфейсами и инструментами, чтобы сделать вывод алгоритма NSynth более понятным для обывателя и воспроизводимым. В рамках этого исследования они создали NSynth Super в сотрудничестве с Google Creative Lab. Это экспериментальный инструмент с открытым исходным кодом, который дает музыкантам возможность создавать музыку, используя новые звуки, генерируемые алгоритмом NSynth из 4-х различных базовых исходных звуков. Затем прототипом опыта (на фото выше) поделились с небольшим сообществом музыкантов, чтобы лучше понять, как они могут использовать его в своем творческом процессе. Например, можно посмотреть [11] , как лондонский музыкальный продюсер Гектор Плиммер исследует звуки, сгенерированные NSynth Super.

Звуки, сгенерированные NSynth Super

Как пишут разработчики на своем сайте, "используя NSynth Super, музыканты имеют возможность исследовать более 100 000 новых звуков, сгенерированных с помощью алгоритма NSynth".

Flow Machines (Sony)

Flow Machines [12] , (прим. дословный перевод — Потоковые Машины) — это научно-исследовательский проект, целью которого является расширение границ креативности человека в музыке.

Чтобы написать песню с помощью Flow Machines Composer, сначала нужно задать стиль мелодии, а затем внутри системы происходит следующее [13] : алгоритм получает выборку песен с похожим стилем, запускает аналитическую модель, известную как цепь Маркова, которая идентифицирует шаблоны в этих выборках, а затем имитирует и изменяет их, чтобы создать свою собственную оригинальную композицию.

Далее компьютер вычисляет вероятность определенных аккордовых прогрессий [14] , мелодических связей и ритмических рисунков [15] , и использует эти вероятности для создания правдоподобных и звучащих удачно (с точки зрения музыки) вариаций.

А вот на следующем этапе сочинения, система требует вмешательства человека. Пользователь может сохранить понравившуюся часть получившейся мелодии, и отказаться от остального, а затем снова запустить программу в ожидании следующих удачных сгенерированных вариаций. И так можно делать до тех пор, пока не появится мелодия и последовательность аккордов, которыми вы будете довольны.

В сентябре 2016-го года Flow Machines представили свету свой сингл "Daddy's Car" — это достаточно оживленная поп-песня, основанная на выборке мелодий Beatles [16] .

Сингл "Daddy's Car"

Примеры использования: стартапы

AIVA - "Genesis" Symphonic Fantasy in A minor, Op. 21

Запущенный в январе 2017 года, австралийский стартап Popgun, как сообщается [23] , использует глубокое обучение для создания музыкального искусственного интеллекта, который сможет "дополнять" исполнителей в режиме реального времени.

Проектом Popgun стал искусственный интеллект Alice, который может предсказать, что музыкант будет играть дальше, подыгрывать ему, и даже немного импровизировать на музыкальную тему партитуры музыканта-человека.

Всему этому Alice научилась не сразу, а постепенно: лучше всего это отобразит видео [24] , которое показывает эволюцию технологии с января 2017 года по июль 2018 года. Видео начинается с того как искусственный интеллект Alice демонстрирует свои навыки прогнозирования: музыкант играет короткие мелодии на фортепиано, и Alice отвечает тем, что по ее предположению музыкант будет играть дальше.

Искусственный интеллект Alice может "дополнять" исполнителей в режиме реального времени

К августу 2017 года Alice была способна на импровизацию: т.е сначала она прослушивала последовательность нот, сыгранную человеком, а затем изменяла её, но при этом сохраняла главную музыкальную тему. К концу года Alice могла в различных стилях создавать оригинальные фортепианные композиции без участия человека.

На январь 2019 года Popgun имеет искусственный интеллект (или, лучше сказать, группу искусственных интеллектов), который может подыграть человеку на пианино, на басу или на барабанах (или на всем сразу). Если же мелодия снабжена человеческим вокалом, то разработанный алгоритм может сочинять подходящую инструментальную партию, а также сводить несколько музыкальных отрывков в один и производить финальную обработку звучания.

Будущее искусственного интеллекта для сочинения музыки

Большой проблемой для искусственного интеллекта является понимание творческих и художественных решений (однако же иногда это является проблемой и для экспертов в области музыки). Кроме того, машины по-прежнему не обладают неуловимым творческим началом, являющимся жизненно необходимым для создания искусства. В целом, ИИ-эксперты согласны, что искусственный интеллект никогда не сможет заменить человека на поприще создания музыки, но, как упоминалось выше, сможет значительно изменить весь процесс.

2017: Выход альбома Тэрин Саузерн I AM AI в соавторстве с ИИ

Проект Amper – искусственный интеллект, результат совместной работы технических специалистов и профессиональных музыкантов. Он способен писать, исполнять и продюсировать музыку. Ампер – первый в истории искусственный интеллект, выпустивший собственный музыкальный альбом.

Ампер является уникальным в своем роде. ИИ, генерирующие музыку, существовали и до него, однако ранние модели работали по определенному алгоритму и итоговый продукт требовал серьезной переделки человеком, вплоть до изменения аккордов и целых частей мелодии, прежде чем мог считаться полноценным музыкальным произведением.

Ампер же не нуждается в помощи, когда создает собственные треки – он самостоятельно подбирает необходимые звуки и выстраивает структуры аккордов. Обрабатывающему полученную в итоге мелодию человеку остается только подкорректировать ритм и стилистику – все остальное Ампер делает сам всего за несколько секунд.

2016: Google запускает Magenta для создания музыки и видео нейронными сетями

В мае 2016 года компания Google даже запустила специальный проект Magenta, основная задача которого заключается в изучении креативных возможностей нейронной сети. Ученые планируют осваивать премудрости творческого процесса постепенно: сначала будет разработан алгоритм для создания музыкальных произведений. Затем настанет очередь видео и изобразительного искусства. Данные о результатах работы планируется размещать в открытом доступе на GitHub.

Буквально через пару недель после открытия Magneta, была запущена программа по импорту музыкальных файлов MIDI-формата в систему TensorFlow с целью обучить искусственный интеллект созданию музыки. Однако пока результаты работы программы не столь удачны (хотя справедливости ради нужно сказать, что прошло еще не так много времени).

Читайте также: