Сообщение по информатике на тему количество информации

Обновлено: 05.07.2024

Понимая информацию как один из основных стратегических ресурсов, без которого невозможна деловая, управленческая, вообще любая социально значимая деятельность, необходимо уметь оценивать ее как с качественной, так и с количественной стороны. На этом пути существуют большие проблемы из-за нематериальной природы этого ресурса и субъективности восприятия конкретной информации различными индивидуумами человеческого общества. С этой точки зрения классификация информации является важнейшим средством создания систем хранения и поиска информации, без которых сегодня невозможно эффективное функционирование информационного обеспечения управления.

Целью работы является рассмотрение видов информации, областей применения и подходов к ее количественной оценке. Для этого нужно рассмотреть следующие задачи и вопросы. Первой задачей является изучение общих понятий по данной теме. Рассмотрение конкретных способов оценки количества информации – вторая задача.

Что такое информация и ее классификация

Термин "информация" происходит от латинского слова "informatio", что означает сведения, разъяснения, изложение. Несмотря на широкое распространение этого термина, понятие информации является одним из самых дискуссионных в науке. В настоящее время наука пытается найти общие свойства и закономерности, присущие многогранному понятию информация, но пока это понятие во многом остается интуитивным и получает различные смысловые наполнения в различных отраслях человеческой деятельности:

· в кибернетике под информацией понимает ту часть знаний, которая используется для ориентирования, активного действия, управления, т.е. в целях сохранения, совершенствования, развития системы (Н. Винер).

Клод Шеннон, американский учёный, заложивший основы теории информации — науки, изучающей процессы, связанные с передачей, приёмом, преобразованием и хранением информации, — рассматривает информацию как снятую неопределенность наших знаний о чем-то.

Применительно к информации как к объекту классификации выделенные классы называют информационными объектами. С этой точки зрения классификация информации является важнейшим средством создания систем хранения и поиска информации, без которых сегодня невозможно эффективное функционирование информационного обеспечения управления. Классификация носит всеобщий характер вследствие той роли, которую она играет как инструмент научного познания, прогнозирования и управления. Одновременно классификация выполняет функцию объективного отражения и фиксации результатов этого познания. при этом характер классификационной схемы, состав признаков классификации и глубина классификации определяется теми практическими целями, для реализации которых используется классификация, типом объектов классификации, а также условиями, в которых классификация будет использоваться.

1.2 Виды информации

Основные виды информации по ее форме представления, способам ее кодирования и хранения, что имеет наибольшее значение для информатики, это:

1. Графическая или изобразительная — первый вид, для которого был реализован способ хранения информации об окружающем мире в виде наскальных рисунков, а позднее в виде картин, фотографий, схем, чертежей на бумаге, холсте, мраморе и др. материалах, изображающих картины реального мира;

2. Звуковая — мир вокруг нас полон звуков и задача их хранения и тиражирования была решена с изобретение звукозаписывающих устройств в 1877 г. ее разновидностью является музыкальная информация — для этого вида был изобретен способ кодирования с использованием специальных символов, что делает возможным хранение ее аналогично графической информации;

3. Текстовая — способ кодирования речи человека специальными символами — буквами, причем разные народы имеют разные языки и используют различные наборы букв для отображения речи; особенно большое значение этот способ приобрел после изобретения бумаги и книгопечатания;

4. Числовая — количественная мера объектов и их свойств в окружающем мире; особенно большое значение приобрела с развитием торговли, экономики и денежного обмена; аналогично текстовой информации для ее отображения используется метод кодирования специальными символами — цифрами, причем системы кодирования (счисления) могут быть разными;

1.3 Виды подходов к оценке количества информации

(РИСУНОК 1)

При всем многообразии подходов к определению понятия информации, с позиции измерения информации нас будут интересовать два из них: определение К. Шеннона, применяемое в математической теории информации (содержательный подход), и определение А. Н. Колмогорова, применяемое в отраслях информатики, связанных с использованием компьютеров (алфавитный подход). (рисунок 1)

1.4 Содержательный подход

Содержательный подход к измерению информации.

Для человека информация — это знания человека. Рассмотрим вопрос с этой точки зрения.

Проще всего определить объем информации в том случае, когда все результаты события могут быть реализованы с равной вероятностью. В этом случае формула Хартли используется для расчета информации.

Причем обычно значение N известно, а I приходится подбирать, что не совсем удобно. Поэтому те, кто знает математику получше, предпочитают преобразовать данную формулу так, чтобы сразу выразить искомую величину I в явном виде: I = log2 N

В более сложной ситуации, когда исход события ожидается с различной степенью достоверности, требуются более сложные вычисления с использованием формулы Шеннона.

Формула Шеннона: I = - ( p1log2 p1 + p2 log2 p2 + . . . + pN log2 pN),

Легко заметить, что если вероятности p1, . pN равны, то каждая из них равна 1 / N, и формула Шеннона превращается в формулу Хартли.

1.5 Алфавитный подход

Алфавитный подход используется для измерения количества информации в тексте, представленном в виде последовательности символов некоторого алфавита. Такой подход не связан с содержанием текста. Количество информации в этом случае называется информационным объемом текста, который пропорционален размеру текста — количеству символов, составляющих текст. Иногда данный подход к измерению информации называют объемным подходом.

Каждый символ текста несет определенное количество информации. Его называют информационным весом символа. Поэтому информационный объем текста равен сумме информационных весов всех символов, составляющих текст.

Если допустить, что все символы алфавита встречаются в тексте с одинаковой частотой (равновероятно), то количество информации, которое несет каждый символ, вычисляется по формуле Хартли:

Алфавит - множество используемых символов в языке.

Мощность алфавита (N) - количество символов, используемых в алфавите.

i=log2N , где N - мощность алфавита.

Формула Хартли задает связь между количеством возможных событий N и количеством информации i :

Заключение

Память носителя информации имеет некоторую физическую ёмкость, в которой она способна накапливать образы, и количество накопленной в памяти информации, характеризуется в итоге именно разнообразием заполнения этой ёмкости. Для объектов неживой природы это разнообразие их истории, для живых организмов это разнообразие их опыта.

Разнообразие необходимо при передаче информации. Нельзя нарисовать белым по белому, одного состояния недостаточно. Если ячейка памяти способна находиться только в одном (исходном) состоянии и не способна изменять свое состояние под внешним воздействием, это значит, что она не способна воспринимать и запоминать информацию. Информационная емкость такой ячейки равна 0.

Информационная ёмкость одной ячейки памяти, способной находиться в двух различных состояниях, принята за единицу измерения количества информации - 1 бит.

1 бит (bit - сокращение от англ. binary digit - двоичное число) - единица измерения информационной емкости и количества информации, а также и еще одной величины – информационной энтропии, с которой мы познакомимся позже. Бит, одна из самых безусловных единиц измерения. Если единицу измерения длины можно было положить произвольной: локоть, фут, метр, то единица измерения информации не могла быть по сути никакой другой.

Количество информации мы будем обозначать символом I, вероятность обозначается символом P. Напомним, что суммарная вероятность полной группы событий равна 1.

2.Неопределенность, количество информации и энтропия

Основоположник теории информации Клод Шеннон определил информацию, как снятую неопределенность. Точнее сказать, получение информации - необходимое условие для снятия неопределенности. Неопределенность возникает в ситуации выбора. Задача, которая решается в ходе снятия неопределенности – уменьшение количества рассматриваемых вариантов (уменьшение разнообразия), и в итоге выбор одного соответствующего ситуации варианта из числа возможных. Снятие неопределенности дает возможность принимать обоснованные решения и действовать. В этом управляющая роль информации.

Ситуация максимальной неопределенности предполагает наличие нескольких равновероятных альтернатив (вариантов), т.е. ни один из вариантов не является более предпочтительным. Причем, чем больше равновероятных вариантов наблюдается, тем больше неопределенность, тем сложнее сделать однозначный выбор и тем больше информации требуется для этого получить. Для N вариантов эта ситуация описывается следующим распределением вероятностей: .

Минимальная неопределенность равна 0, т.е. эта ситуация полной определенности, означающая что выбор сделан, и вся необходимая информация получена. Распределение вероятностей для ситуации полной определенности выглядит так: .

Величина, характеризующая количество неопределенности в теории информации обозначается символом H и имеет название энтропия, точнее информационная энтропия.

Энтропия (H) – мера неопределенности, выраженная в битах. Так же энтропию можно рассматривать как меру равномерности распределения случайной величины.

|

| Рис. 1. Поведение энтропии для случая двух альтернатив. |

На рисунке 1. показано поведение энтропии для случая двух альтернатив, при изменении соотношения их вероятностей (p, (1-p)).

Максимального значения энтропия достигает в данном случае тогда, когда обе вероятности равны между собой и равны ½, нулевое значение энтропии соответствует случаям (p0 =0, p1 =1) и (p0 =1, p1 =0).

|

| Рис. 2. Связь между энтропией и количеством информации. |

Количество информации I и энтропия H характеризуют одну и ту же ситуацию, но с качественно противоположенных сторон. I – это количество информации, которое требуется для снятия неопределенности H. По определению Леона Бриллюэна информация есть отрицательная энтропия (негэнтропия).

Когда неопределенность снята полностью, количество полученной информации I равно изначально существовавшей неопределенности H.

При частичном снятии неопределенности, полученное количество информации и оставшаяся неснятой неопределенность составляют в сумме исходную неопределенность. Ht + It = H.

По этой причине, формулы, которые будут представлены ниже для расчета энтропии H являются и формулами для расчета количества информации I, т.е. когда речь идет о полном снятии неопределенности, H в них может заменяться на I.

3.Формула Шеннона

В общем случае, энтропия H и количество получаемой в результате снятия неопределенности информации I зависят от исходного количества рассматриваемых вариантов N и априорных вероятностей реализации каждого из них P: 0 , p1 , …pN -1 >, т.е. H=F(N, P). Расчет энтропии в этом случае производится по формуле Шеннона, предложенной им в 1948 году в статье "Математическая теория связи".

В частном случае, когда все варианты равновероятны, остается зависимость только от количества рассматриваемых вариантов, т.е. H=F(N). В этом случае формула Шеннона значительно упрощается и совпадает с формулой Хартли, которая впервые была предложена американским инженером Ральфом Хартли в 1928 году, т.е. на 20 лет раньше.

Формула Шеннона имеет следующий вид:

(1)

Рис. 3. Нахождение логарифма b по основанию a - это нахождение степени, в которую нужно возвести a, чтобы получить b.

Напомним, что такое логарифм.

Логарифм по основанию 2 называется двоичным:

Логарифм по основанию 10 –называется десятичным:

log10 (100)=2 => 10 2 =100

Основные свойства логарифма:

1. log(1)=0, т.к. любое число в нулевой степени дает 1;

Знак минус в формуле (1) не означает, что энтропия – отрицательная величина. Объясняется это тем, что pi £1 по определению, а логарифм числа меньшего единицы - величина отрицательная. По свойству логарифма , поэтому эту формулу можно записать и во втором варианте, без минуса перед знаком суммы.

интерпретируется как частное количество информации, получаемое в случае реализации i-ого варианта. Энтропия в формуле Шеннона является средней характеристикой – математическим ожиданием распределения случайной величины 0 , I1, … IN -1 >.

Пример расчета энтропии по формуле Шеннона. Пусть в некотором учреждении состав работников распределяется так: ¾ - женщины, ¼ - мужчины. Тогда неопределенность, например, относительно того, кого вы встретите первым, зайдя в учреждение, будет рассчитана рядом действий, показанных в таблице 1.

| pi | 1/pi | Ii =log2 (1/pi ), бит | pi *log2 (1/pi ), бит | |

| Ж | 3/4 | 4/3 | log2 (4/3)=0,42 | 3/4 * 0,42=0,31 |

| М | 1/4 | 4/1 | log2 (4)=2 | 1/4 * 2=0,5 |

| å | 1 | H=0,81 бит |

Если же априори известно, что мужчин и женщин в учреждении поровну (два равновероятных варианта), то при расчете по той же формуле мы должны получить неопределенность в 1 бит. Проверка этого предположения проведена в таблице 2.

| pi | 1/pi | Ii =log2 (1/pi ), бит | pi *log2 (1/pi ), бит | |

| Ж | 1/2 | 2 | log2 (2)=1 | 1/2 * 1=1/2 |

| М | 1/2 | 2 | log2 (2)=1 | 1/2 * 1=1/2 |

| å | 1 | H=1 бит |

4.Формула Хартли

Формула Хартли – частный случай формулы Шеннона для равновероятных альтернатив.

Подставив в формулу (1) вместо pi его (в равновероятном случае не зависящее от i) значение , получим:

,

таким образом, формула Хартли выглядит очень просто:

(2)

Из нее явно следует, что чем больше количество альтернатив (N), тем больше неопределенность (H). Эти величины связаны в формуле (2) не линейно, а через двоичный логарифм. Логарифмирование по основанию 2 и приводит количество вариантов к единицам измерения информации – битам.

Энтропия будет являться целым числом лишь в том случае, если N является степенью числа 2, т.е. если N принадлежит ряду:

Рис. 3. Зависимось энтропии от количества равновероятных вариантов выбора (равнозначных альтернатив).

Для решения обратных задач, когда известна неопределенность (H) или полученное в результате ее снятия количество информации (I) и нужно определить какое количество равновероятных альтернатив соответствует возникновению этой неопределенности, используют обратную формулу Хартли, которая выводится в соответствии с определением логарифма и выглядит еще проще:

(3)

Например, если известно, что в результате определения того, что интересующий нас Коля Иванов живет на втором этаже, было получено 3 бита информации, то количество этажей в доме можно определить по формуле (3), как N=2 3 =8 этажей.

Если же вопрос стоит так: “в доме 8 этажей, какое количество информации мы получили, узнав, что интересующий нас Коля Иванов живет на втором этаже?”, нужно воспользоваться формулой (2): I=log2 (8)=3 бита.

До сих пор были приведены формулы для расчета энтропии (неопределенности) H, указывая, что H в них можно заменять на I, потому что количество информации, получаемое при полном снятии неопределенности некоторой ситуации, количественно равно начальной энтропии этой ситуации.

(4)

Для равновероятного случая, используя для расчета энтропии формулу Хартли, получим:

(5)

Второе равенство выводится на основании свойств логарифма. Таким образом, в равновероятном случае I зависит от того, во сколько раз изменилось количество рассматриваемых вариантов выбора (рассматриваемое разнообразие).

Исходя из (5) можно вывести следующее:

Если , то - неопределенности не изменилась, следовательно, информации получено не было.

Рассмотрим в качестве примера опыт с колодой из 36 карт.

Рис. 4. Иллюстрация к опыту с колодой из 36-ти карт.

Вариант A. “Это карта красной масти”.

I=log2 (36/18)=log2 (2)=1 бит (красных карт в колоде половина, неопределенность уменьшилась в 2 раза).

Вариант B. “Это карта пиковой масти”.

I=log2 (36/9)=log2 (4)=2 бита (пиковые карты составляют четверть колоды, неопределенность уменьшилась в 4 раза).

Вариант С. “Это одна из старших карт: валет, дама, король или туз”.

I=log2 (36)–log2 (16)=5,17-4=1,17 бита (неопределенность уменьшилась больше чем в два раза, поэтому полученное количество информации больше одного бита).

Вариант D. “Это одна карта из колоды".

Вариант D. “Это дама пик".

I=log2 (36/1)=log2 (36)=5,17 бит (неопределенность полностью снята).

Список использованной литературы

5. Петрович Н. Т. Люди и биты. Информационный взрыв: что он несет. М.: Знание, 1986.

Содержимое работы - 1 файл

Доклад по информатике 1.doc

Муниципальное образовательное учреждение Перевозская средняя общеобразовательная школа

Количество информации.

Бит. Для количественного выражения любой величины необходимо сначала определить единицу измерения. Так, для измерения длины в качестве единицы выбран метр, для измерения массы - килограмм и т. д. Аналогично, для определения количества информации необходимо ввести единицу измерения.

Производные единицы измерения количества информации.

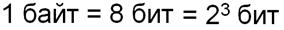

Минимальной единицей измерения количества информации является бит, а следующей по величине единицей - байт, причем:

1 байт = 8 битов = 2 3 битов.

В информатике система образования кратных единиц измерения несколько отличается от принятых в большинстве наук. Традиционные метрические системы единиц, например Международная система единиц СИ, в качестве множителей кратных единиц используют коэффициент 10 n , где n = 3, 6, 9 и т. д., что соответствует десятичным приставкам "Кило" (10 3 ), "Мега" (10 6 ), "Гига" (10 9 ) и т. д. В компьютере информация кодируется с помощью двоичной знаковой системы, и поэтому в кратных единицах измерения количества информации используется коэффициент 2 n Так, кратные байту единицы измерения количества информации вводятся следующим образом:

- 1 килобайт (Кбайт) = 2 10 байт = 1024 байт;

- 1 мегабайт (Мбайт) = 2 10 Кбайт = 1024 Кбайт;

- 1 гигабайт (Гбайт) = 2 10 Мбайт = 1024 Мбайт.

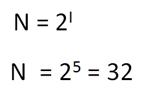

Таким образом, количество экзаменационных билетов равно 32.

Определение количества информации.

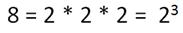

Разложим стоящее в левой части уравнения число 8 на сомножители и представим его в степенной форме:

8 = 2 × 2 × 2 = 2 3 .

Алфавитный подход к определению количества информации.

Информационная емкость знака.

С помощью этой формулы можно, например, определить количество информации, которое несет знак в двоичной знаковой системе:

N = 2 => 2 = 2 I => 2 1 = 2 I => I=1 бит.

Таким образом, в двоичной знаковой системе знак несет 1 бит информации. Интересно, что сама единица измерения количества информации "бит" (bit) получила свое название ОТ английского словосочетания "Binary digiT" - "двоичная цифра".

- Информационная емкость знака двоичной знаковой системы составляет1 бит.

С помощью формулы (1.1) определим количество информации, которое несет буква русского алфавита:

N = 32 => 32 = 2 I => 2 5 = 2 I => I=5 битов.

Таким образом, буква русского алфавита несет 5 битов информации (при алфавитном подходе к измерению количества информации). Количество информации, которое несет знак, зависит от вероятности его получения. Если получатель заранее точно знает, какой знак придет, то полученное количество информации будет равно 0. Наоборот, чем менее вероятно получение знака, тем больше его информационная емкость. В русской письменной речи частота использования букв в тексте различна, так в среднем на 1000 знаков осмысленного текста приходится 200 букв "а" и в сто раз меньшее количество буквы "ф" (всего 2). Таким образом, с точки зрения теории информации, информационная емкость знаков русского алфавита различна (у буквы "а" она наименьшая, а у буквы "ф" - наибольшая).

Так, каждая цифра двоичного компьютерного кода несет информацию в 1 бит. Следовательно, две цифры несут информацию в 2 бита, три цифры - в 3 бита и т. д. Количество информации в битах равно количеству цифр двоичного компьютерного кода (табл. 1.1).

Таблица. Количество информации, которое несет двоичный компьютерный код

Человек всегда стремится к количественному измерению различных величин. Получая ту или иную информацию, мы понимаем, что не всегда ее бывает достаточно для того, чтобы решить какие-либо проблемы. На этом уроке будет рассмотрен содержательный подход, который позволяет оценить количество информации с точки зрения уменьшения неопределенности наших знаний об объекте. Также учащиеся познакомятся с единицами измерения информации и научатся вычислять количество информации с точки зрения содержательного подхода.

В данный момент вы не можете посмотреть или раздать видеоурок ученикам

Чтобы получить доступ к этому и другим видеоурокам комплекта, вам нужно добавить его в личный кабинет, приобретя в каталоге.

Получите невероятные возможности

Конспект урока "Количество информации"

Процесс познания приводит к накоплению информации (знаний), то есть к уменьшению неопределенности знания.

Измерить объём накопленных знаний нельзя, а вот оценить уменьшение незнания можно, если известно количество возможных вариантов исхода.

- формула Хартли,

где N - количество вариантов исхода;

В своей деятельности человек постоянно использует различные единицы измерения. Например, время измеряется в секундах, минутах, часах; расстояние - в метрах, километрах; температура - в градусах и т.д.

Для измерения количества информации тоже существуют свои единицы. Минимальную единицу количества информации называют битом.

Давайте рассмотрим примеры:

1. При бросании монеты возможны два варианта исхода (орёл или решка). Заранее не известен результат, мы имеем некоторую неопределённость. После падения монеты виден один вариант вместо двух (неопределённость исчезла).

Следующей по величине единицей является байт. Байт - это единица измерения количества информации, состоящая из восьми последовательных и взаимосвязанных битов.

Т.к. в компьютере информация кодируется с помощью двоичной знаковой системы, поэтому в кратных единицах измерения количества информации используется коэффициент 2 n .

Существуют кратные байту единицы измерения количества информации:

1 килобайт (Кбайт) = 2 10 байтов = 1024 байтов;

1 мегабайт (Мбайт) = 2 10 Кбайт = 1024 Кбайт;

1 гигабайт (Гбайт) = 2 10 Мбайт = 1024 Мбайт.

В этих единицах измеряются объемы памяти компьютера, размеры файлов.

Таким образом, количество экзаменационных билетов равно 32.

Разложим стоящее в левой части уравнения число 8 на сомножители и представим его в степенной форме:

Итак, мы получили:

Как и любую другую физическую величину, информацию можно измерить. Существуют разные подходы к измерению информации. Один из таких подходов рассматривается в курсе информатики за 7 класс.

Что такое измерение информации

Алфавитный подход к измерению информации

Вес отдельного знака зависит от их количества в алфавите. Число символов алфавита называют мощностью (N). Например, мощность алфавита английского языка по числу символов равно 26, русского языка 33. Но на самом деле, при написании текста используются и прописные и строчные буквы, а также знаки препинания, пробелы и специальные невидимые символы, обозначающие конец абзаца и перевод к новой строке. Поэтому имеют дело с мощностью 128 или в расширенной версии 256 символов.

Рис. 1. Таблица символов – латиница.

Бит, байт и другие единицы измерения

Восемь бит образуют байт.

Рис. 2. Портрет Вернера Бухгольца.

На практике величина объема информации выражает в более крупных единицах: килобайтах, терабайтах, мегабайтах.

Следует запомнить, что килобайт равен 1024 байта, а не 1000. Как, например, 1 километр равен 1000 метрам. Эта разница получается за счет того, 1 байт равен 8 битам, а не 10.

Для того, чтобы легче запомнить единицы измерения, следует воспользоваться таблицей степени двойки.

Таблица степеней двойки

Показатель степени

Значение

Рис. 3. Единицы измерения информации.

То есть, 2 3 = 8 – это 1 байт, состоящий из 8 бит, 2 10 = 1024 это 1 килобайт, 2 20 = 1048576 представляет собой 1 мегабайт, 2 30 = 1 гигабайт, 2 40 = 1 терабайт.

Определение количества информации

Вес символа (i) и мощность алфавита (N) связаны между собой соотношением: 2 i = N.

Что мы узнали?

Читайте также: