Теория информации клода шеннона обзорный доклад

Обновлено: 16.05.2024

Важные разделы теории информации Шеннона включают:

- кодирования информации ;

- количественная мера избыточности текста;

- на сжатие данных ;

- криптография .

В более общем смысле теория информации - это теория, направленная на количественную оценку и уточнение понятия информационного содержания, присутствующего в наборе данных. Таким образом, существует другая теория информации: алгоритмическая теория информации , созданная Колмогоровым , Соломоновым и Чайтиным в начале 1960- х годов .

Резюме

Информация по Шеннону, концепция математической физики

Информация - это новое физическое понятие, возникшее в технологической сфере. Теоретическая концепция информации была введена в результате теоретических исследований телекоммуникационных систем . Происхождение этого исследования восходит к исследованиям , проведенных в конце XIX E века, в физике и математике Больцмана и Маркова на понятии вероятности наступления события и возможности измерения этой вероятности. Совсем недавно, перед Второй мировой войной , наиболее важный вклад был сделан благодаря сотрудничеству математиков и инженеров по телекоммуникациям , которые были вынуждены рассмотреть теоретические свойства любой сигнальной системы, используемой живыми или техническими существами для целей связи .

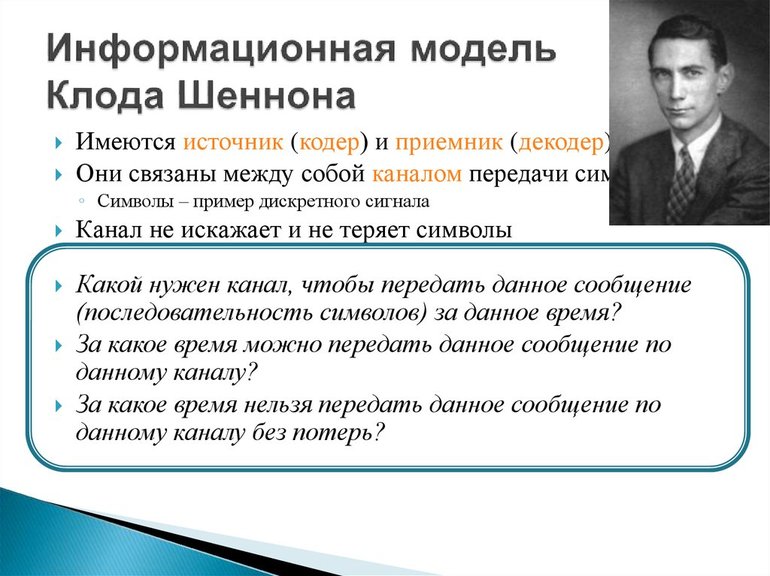

Следуя работе Хартли (1928), Шеннон (1948) определяет информацию как измеримую величину, если не наблюдаемую - потому что никто никогда не видел информацию - и это становится основой теории коммуникации, которую он развивает вместе с Уорреном Уивером .

Для Шеннон информация по сути случайна. Случайное событие по определению является неопределенным. Эта неопределенность принимается за меру информации. Таким образом, информация будет определяться только ее вероятностью ( I = - log p ). Таким образом, информация - это мера неопределенности, рассчитанная на основе вероятности события. Поэтому Шеннон перепутал понятие информации и измерения неопределенности. Следует отметить, что в этом определении информация является синонимом измерения неопределенности. Таким образом, чем неопределеннее информация, тем она интереснее, а определенное событие не содержит никакой информации. Таким образом, в теории информации Шеннона речь идет о вероятностных рассуждениях, а не чистой логике.

Физический статус теории информации

Очень быстро в области гуманитарных наук появились многочисленные приложения теории информации Шеннона: разработанные математические модели позволили определить определенные концепции, обычно используемые в структурно-лингвистическом анализе, в то же время они выявили ограничения, присущие этому типу анализа. и побудили к новым исследованиям (в области машинного перевода и психолингвистики). Пока развивалось новое научное направление: кибернетика .

Однако главной характеристикой теории Шеннона является то, что она придает понятию информации (как определено этой теорией) самостоятельный физический статус. В самом деле, информация приобретает фундаментальные характеристики любой организованной физической реальности: предоставленная самой себе, она может развиваться только в направлении своей дезорганизации, то есть увеличения энтропии ; фактически, информация в своих преобразованиях (кодировании, передаче, декодировании и т. д.) подвергается необратимому и возрастающему эффекту деградации. Поэтому Шеннон определяет как энтропию информации меру H ( H = - K log p ). Удивительно, но уравнение, с помощью которого Шеннон определяет энтропию информации, совпадает с точностью до мультипликативного множителя с уравнением Больцмана-Гиббса, определяющим энтропию S в термодинамике ( S = - K log p ). Этот важный эпизод получил множество комментариев.

Некоторые, например Куффигналь, утверждали, что совпадение бессмысленно: применение функции Шеннона к термодинамике и информации было бы совпадением применения той же математической формулы, не более того. Конечно, может быть встреча двух вероятностных уравнений из разных вселенных.

Развитие математической теории информации

Математическая теория информации возникла в результате работы Рональда Эйлмера Фишера . Этот статистик формально определяет информацию как равную среднему значению квадрата частной производной ( δ ) натурального логарифма изучаемого закона вероятности .

Другие математические модели формально дополнили и расширили определение информации .

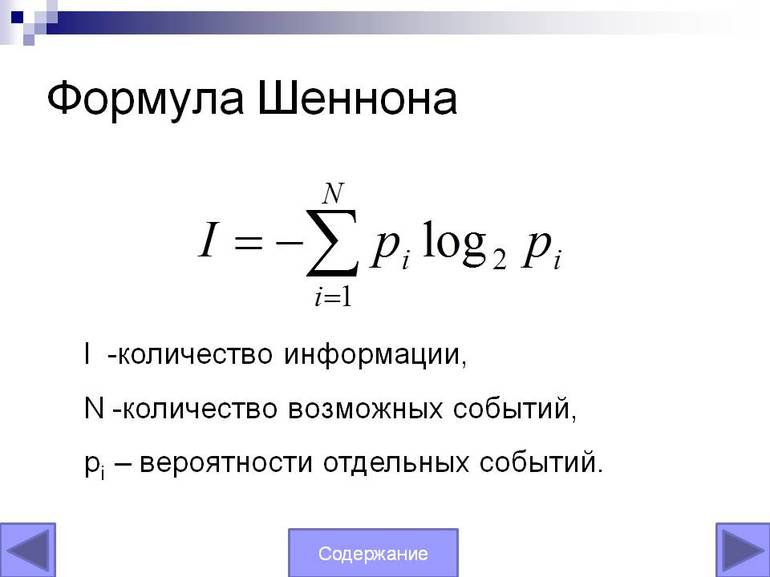

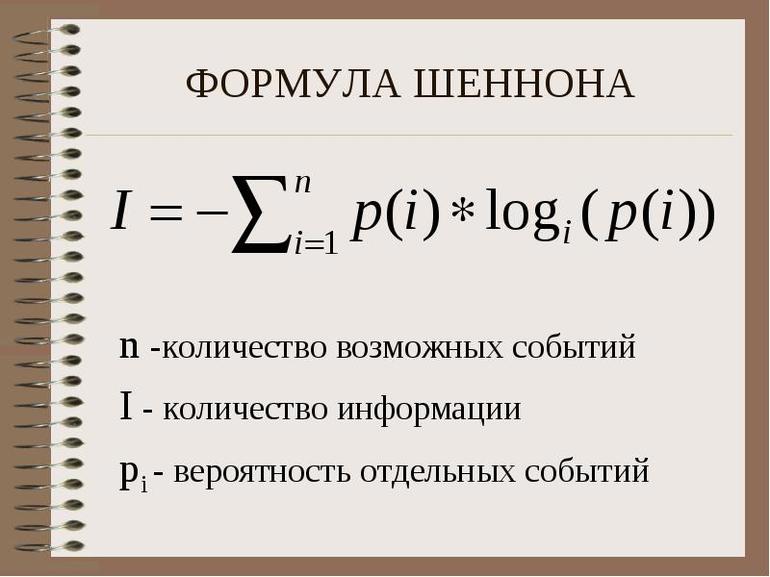

Для источника X, содержащего n символов, символа x i, имеющего вероятность появления p i = P ( X = x i ) , энтропия H источника X определяется как:

Изначально используется натуральный логарифм . Он будет заменен для удобства логарифмом с основанием 2, соответствующим части информации, которая является битом . Соображения максимальной энтропии ( MAXENT ) позволят байесовскому выводу рационально определить априорные распределения .

В информационных науках выходят из направления из данных на основе вопросов корреляции , по энтропии и обучения (см интеллектуального анализа данных ). В информационных технологиях , тем временем, обеспокоены тем, как проектировать, внедрять и внедрять решения для удовлетворения выявленных потребностей.

Примеры информации

An информация средства, из множества событий, одного или нескольких возможных событий.

Первый пример

Либо источник, который может производить целые напряжения от 1 до 10 вольт, либо приемник, который будет измерять это напряжение. Перед тем, как электрический ток будет отправлен источником, приемник не имеет представления о напряжении, которое будет доставлено источником. С другой стороны, как только ток излучается и принимается, неопределенность излучаемого тока уменьшается. Теория информации считает, что приемник имеет неопределенность 10 состояний.

Второй пример

В библиотеке имеется большое количество книг, журналов, книг и словарей. Мы ищем полный курс по теории информации. Во-первых, логично, что мы не найдем этот файл в произведениях искусства или литературы; поэтому мы только что получили информацию, которая сократит время нашего исследования. Мы указали, что нам также нужен полный курс, поэтому мы не найдем его в журнале или в словаре. Мы получили дополнительную информацию (ищем книгу), которая еще больше сократит время исследования.

Информационное содержание и контекст

Измерение количества информации

Количество информации: элементарный случай

Рассмотрим N пронумерованные коробки от 1 до N . Человек А случайно спрятал объект в одном из этих ящиков. Человек B должен найти номер коробки, в которой спрятан объект. Для этого он имеет право задавать вопросы человеку А, на которые он должен ответить, не лгая ДА или НЕТ. Но каждый заданный вопрос представляет собой стоимость, которую должен заплатить человек B (например, один евро). Индивидуум C знает, в каком ящике спрятан объект. У него есть возможность продать эту информацию физическому лицу B. B примет эту сделку только в том случае, если цена для C будет меньше или равна средней стоимости, которую B должен был бы потратить, чтобы найти коробку, задав вопросы A. информацию, имеющуюся у Следовательно, C имеет определенную цену. Эта цена представляет количество информации, представленной знанием правого поля: это среднее количество вопросов, которые нужно задать, чтобы идентифицировать это поле. Обозначим его I.

- Если N = 1 , I = 0 .

- Если N = 2 , I = 1 .

- Если N = 4 , I = 2 .

- Если N = 2 k , I = k .

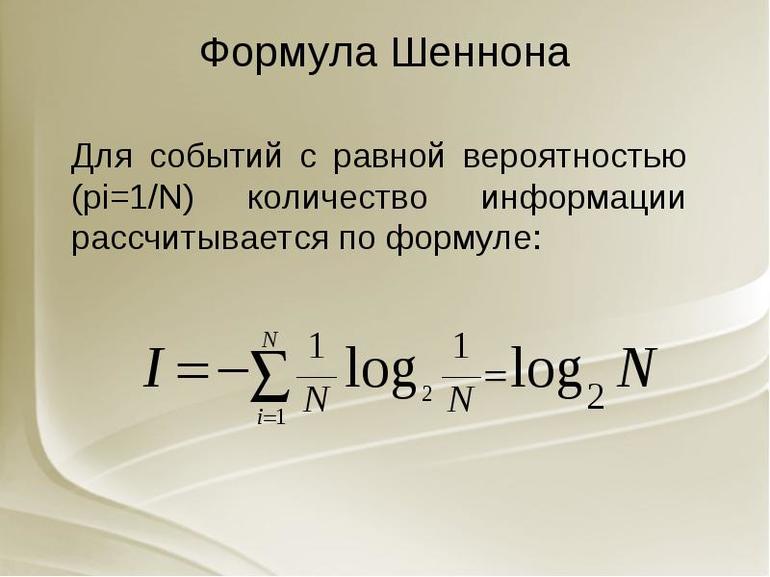

Поэтому мы вынуждены установить I = log 2 ( N ) , но эта конфигурация возникает только в случае N равновероятных событий.

Объем информации, относящейся к событию

Таким образом, мы определяем количество информации как возрастающую функцию от N ⁄ n с помощью:

- N количество возможных событий

- n количество элементов подмножества, ограниченных информацией

Чтобы измерить это количество информации, мы устанавливаем:

Это определение оправдано, потому что нам нужны следующие свойства:

Энтропия, формула Шеннона

Предположим теперь, что коробки разного цвета: n 1 коробок цвета C 1 , n 2 коробок цвета C 2 …, n k коробок цветов C k , причем n 1 + n 2 +… + n k = N. La человек C знает, какого цвета разыскиваемая коробка. Сколько стоит эта информация?

Таким образом, средняя цена информации составляет n 1 / N log N / n 1 + n 2 / N log N / n 2 +… + n k / N log N / n k . В более общем плане, если мы рассматриваем k непересекающихся событий с соответствующими вероятностями p 1 , p 2 . p k с p 1 + p 2 + . + p k = 1, то количество информации, соответствующее этому распределению вероятностей, равно p 1 log 1 / p 1 +… + p k log 1 / p k . Эта величина называется энтропией распределения вероятностей.

с вероятностью, связанной с наступлением события i . п я знак равно нет я НЕТ = > >>

Кодирование информации

Рассмотрим серию символов. Каждый символ может принимать два значения s 1 и s 2 с вероятностями соответственно p 1 = 0,8 и p 2 = 0,2. Количество информации, содержащейся в символе, составляет:

Например, мы группируем символы три на три и кодируем их следующим образом:

| символы для кодирования | вероятность тройки | триплетное кодирование | длина кода |

|---|---|---|---|

| с 1 с 1 с 1 | 0,8 3 = 0,512 | 0 | 1 |

| с 1 с 1 с 2 | 0,8 2 × 0,2 = 0,128 | 100 | 3 |

| с 1 с 2 с 1 | 0,8 2 × 0,2 = 0,128 | 101 | 3 |

| с 2 с 1 с 1 | 0,8 2 × 0,2 = 0,128 | 110 | 3 |

| с 1 с 2 с 2 | 0,2 2 × 0,8 = 0,032 | 11100 | 5 |

| с 2 с 1 с 2 | 0,2 2 × 0,8 = 0,032 | 11101 | 5 |

| с 2 с 2 с 1 | 0,2 2 × 0,8 = 0,032 | 11110 | 5 |

| с 2 с 2 с 2 | 0,2 3 = 0,008 | 11111 | 5 |

НЕТ 3 ( 0 , 512 + 3 × 0 , 128 × 3 + 3 × 0 , 032 × 5 + 0 , 008 × 5 ) знак равно 0 , 728 НЕТ (0,512 + 3 \ раз 0,128 \ раз 3 + 3 \ раз 0,032 \ раз 5 + 0,008 \ раз 5) = 0,728N>

Пределы этой теории

Теория информации Шеннона всегда относится к набору данных, семейству строк, характеризуемых очень точным законом распределения. Таким образом, она дает среднее содержание информации , что делает ее вероятностной теорией , особенно хорошо подходящей для контекста передачи данных, и в этом контексте эта теория дала важные результаты. Однако он не может количественно оценить информационное содержание цепи, взятой изолированно, например, цепи ДНК , в то время как алгоритмическая теория информации в некоторой степени способна. Но у этой последней теории также есть свои ограничения. Вот почему мы не должны считать, что понятие информации полностью охвачено теорией информации Шеннона или алгоритмической теорией информации, но что это понятие требует множества формальных моделей, чтобы выразить себя.

Таким образом, иногда кажется, что информация Фишера заменяет информацию Шеннона с выгодой, поскольку она является локальной, а не глобальной количественной оценкой информации, содержащейся в распределении. Однако эти две концепции связаны и в различных приложениях могут приводить к одним и тем же результатам.

Информационная теория

Обработка информации — важная техническая задача, чем, например, преобразование энергии из одной формы в другую. Важнейшим шагом в развитии теории информации стала работа Клода Шеннона (1948). Логарифмическое измерение количества данных было первоначальной теорией, и прикладными задачами по коммуникации в 1928 году. Наиболее известным является вероятностный подход к измерению информации, на основе которого представлен широкий раздел количественной теории.

Отличительная черта вероятностного подхода от комбинаторного состоит в том, что новые предположения об относительной занятости любой системы в разных состояниях и общего количества элементов не учитываются. Ряд информации взят из отсутствия неопределённости в выборе различных возможностей. В основе такого подхода лежат энтропийные и вероятностные множества.

Основная теорема Шеннона о кодировании

Важный практический вопрос при обработке информации — какова мощность системы передачи данных. Можно получить определённый ответ, используя уравнение Шеннона. Оно позволяет точно понять информационную пропускную способность любого сигнального канала. Формула Шеннона в информатике: I = — (p1log2 p1 + p2 log2 p2 +. + pN log2 pN)

Не существует метода кодирования, который бы позволял передавать со скоростью, превышающей vzm, и с произвольно низкой вероятностью ошибки. Другими словами, если поток информации: H '(Z) = vz * H (Z) C он не существует.

Это приводит к замечательному выводу:

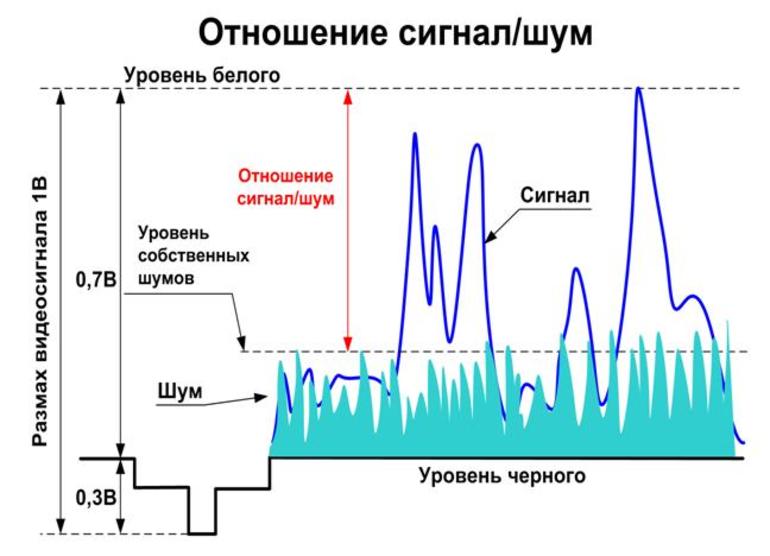

- Сигнал, который эффективно передаёт информацию, будет меняться и непредсказуем.

- Эффективный сигнал очень похож на случайный шум.

Передача сигналов

Это означает:

Определённое уравнение

Сигнал и шум не коррелированны, то есть они не связаны каким-либо образом, который позволит предсказать один из них. Суммарная мощность, получаемая при объединении этих некоррелированных ИС, по-видимому, случайно изменяющихся величин, задаётся.

Поскольку сигнал и шум статистически аналогичны, их комбинация будет иметь то же значение форм-фактора, что и сам сигнал или шум. Потому можно ожидать, что комбинированный сигнал и шум, как правило, будут ограничены диапазоном напряжения.

Стоит рассмотреть теперь разделение этого диапазона на полосы одинакового размера. (т. е. каждая из этих полос будет охватывать ИС.) Чтобы предоставить другую метку для каждой полосы, нужны символы или цифры. Поэтому всегда можно указать, какую полосу занимает уровень напряжения в любой момент с точки зрения B-разрядного двоичного числа. По сути, этот процесс является ещё одним способом описания того, что происходит, когда берут цифровые образцы с B-разрядным аналоговым преобразователем, работающим в общем диапазоне.

Нет никакого реального смысла в выборе значения, которое настолько велико. Это потому что шум кубика будет просто иметь тенденцию рандомизировать фактическое напряжение на эту сумму, делая любые дополнительные биты бессмысленными. В результате максимальное количество битов информации, которую можно получить относительно уровня в любой момент, будет определено.

Уравнение Шеннона может использовать:

- Максимально возможную скорость передачи информации по заданному каналу или системе.

- Передачу данных определяется полосой пропускания, уровнем сигнала и шума.

- Поэтому ИС называется законом информационной пропускной способности канала.

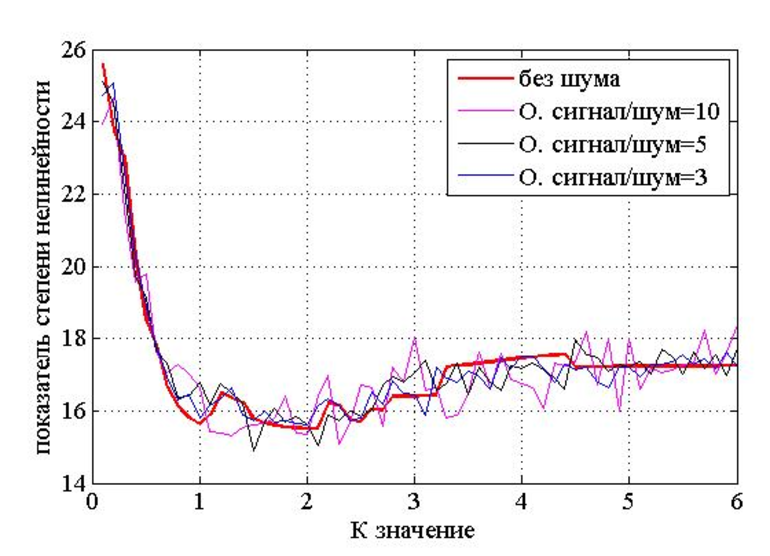

При передаче информации некоторые параметры используемых сигналов могут приобретать случайный символ в канале связи, например, из-за многолучевого распространения радиоволн, гетеродинирующих сигналов. В результате амплитуда и начальная фаза данных являются случайными. Согласно статистической теории связи, эти особенности сигналов необходимы для их оптимальной обработки, они определяют как структуру приёмника, так и качество связи.

Помехи разложения всегда присутствуют в границе любого реального сигнала. Однако, если их уровень настолько мал, что вероятность искажения практически равна нулю, можно условно предположить, что все сигналы передаются неискажёнными.

В этом случае средний объём информации, переносимой одним символом, можно считать расчётным: J (Z; Y) = Хапр (Z) — Хапест (Z) = Хапр (Y). Поскольку функция H (Y) = H (Z) и H (Y / Z) = 0, а индекс max = Hmax (Y) — максимальная энтропия источника класса сигнала, возникающая в результате распределения символов Y: p (y1) = p (y2) = … = p (ym) = 1 / My, т. е. Hmax (Y) = logaMy.

Следовательно, главная дискретная ширина полосы таблицы без информации о помехах в единицу времени равна: Cy = Vy • max = Vy • Hmax (Y) = Vy • logaMy или записываться Ck = Vk • logaMy. Где буква Mk — должно быть максимально возможное количество уровней, разрешённых для передачи по этому каналу (конечно, может обозначаться Mk = My).

Согласно теореме, метод кодирования онлайн, который может использоваться и позволяет:

- с данными согласно уравнению H (x) ≤ C — передать всю информацию, сгенерированную источником с ограниченным размером буфера калькулятора;

- в случае H (x)> C такого способа кодирования не существует, поскольку требуется буфер, объём которого определяется избыточной производительностью источника по ширине полосы канала, умноженной на время передачи.

Вероятностный подход к определению вычисления объёма информации — математический вывод формулы Шеннона не является удовлетворительным для метода оценки роли энтропии, отражения элементов системы и может не применяться. Как общий информатический объект невозможно допустить единый способ измерения и его правила.

Клоду Шеннону потребовалось около десяти лет, чтобы полностью сформулировать свою эпохальную теорию информации.

Сначала, в аспирантуре, он вынашивал идею подвести общую базу под множество информационных технологий своего времени (таких как телефон, радио, телевидение).

Однако только в 1948 году он опубликовал Математическую Теорию Связи.

Правда, это был не единственный его крупный вклад в науку. Еще будучи студентом MIT (Массачусетский технологический институт), в свои скромные 21, он опубликовал работу, которую многие считают, пожалуй, наиболее важной магистерской диссертацией века.

Для обычного человека значение ее невелико. Нельзя сказать, что имя Шеннона у всех на устах. Но, если бы не работа Шеннона, то никакого компьютера в современном понимании могло не появиться. Шеннон оказал колоссальное влияние не только на информатику, но и на физику, и на инженерию.

Одной из малозаметных основ его гениальности, проявлявшейся таким образом, был его подход к решению задач. Он не просто формулировал вопрос, а затем искал ответ на него, но методологически разрабатывал процесс, помогавший рассмотреть суть за очевидным.

Его задачи отличались от большинства из тех, с которыми нам, вероятно, доводилось иметь дело, но его шаблоны и принципы рассуждения до некоторой степени поддавались генерализации и, освоив такое обобщение, мы и сами можем научиться мыслить проницательнее.

Любая задача имеет очертания и форму. Для решения задач первым делом нужно научиться их понимать.

Формулируем суть, затем дополняем детали

Любому из нас понятно, как важно получать ответы, но многие в самом деле пренебрегают тем, как важно сформулировать вопрос именно таким образом, чтобы ответ на него действительно нам достался.

Мы быстро перескакиваем от нюанса к нюансу, надеясь, что рано или поздно они сложатся воедино, а не бросаем все силы на развитие интуиции в той дисциплине, которой занимаемся.

Именно здесь Шеннон действовал в точности наоборот. На самом деле, как отмечают его биографы в книге A Mind at Play, он настолько этим увлекался, что некоторые математики-современники считали, будто он недостаточно дотошно подходил к выстраиванию согласованной картины. Естественно, их интересовали детали.

Однако, по мысли Шеннона, увидеть суть исследуемой проблемы и, соответственно, путь к ответу, можно лишь после того, как отсечешь от нее несущественные детали.

Детали важны и полезны. На самом деле, многие детали несравнимо важнее и полезнее, чем кажутся на первый взгляд. Однако ничуть не меньше и бесполезных деталей.

Если не найти суть проблемы, то начинаешь совершенно не с тех деталей, из-за чего добавляются все новые и новые неверные детали, и так пока вы не увязнете.

Начиная отсекать несущественное, вы дисциплинируете себя, и учитесь видеть суть за дымкой несущественного. Именно тогда вы находите те основания, которые искали.

Обнаружить истинные очертания проблемы почти столь же важно, как и последующий ответ.

Источник

В докладе, прочитанном в компании Bell Labs в 1952 году перед современниками, Шеннон подробно остановился на том, как тренирует собственный разум, развивая креативный подход к своим долгосрочным задачам.

Он не только упрощал их, доискиваясь сути, но и предлагал кое-что еще — на первый взгляд, казалось бы, несущественное, но критически важное для нестандартного мышления.

Зачастую, подолгу размышляя над проблемой, мы начинаем мыслить ограниченно и строго придерживаемся единственной траектории. Логическое рассуждение начинается с некоторой точки, далее делаются обоснованные выводы и, если рассуждать правильно, то логика всегда приводит нас к одному и тому же ответу.

Креативное мышление устроено немного иначе. Здесь также улавливаются взаимосвязи, однако, такие суждения не столько логические, сколько интуитивные, позволяющие нам развить новые паттерны мышления.

Один из излюбленных приемов Шеннона заключался в перестраивании задачи и сравнении ее по максимально разным параметрам. Таким образом, он мог ее утрировать, преуменьшать, формулировать иными словами, менять угол рассмотрения и инвертировать.

Суть такого упражнения — попросту добиться более целостного представления о происходящем.

Наш мозг легко зацикливается на тех или иных мыслях, и лучший способ вырваться из такой петли — изменить систему отсчета. Мы не меняем интуитивного представления о проблеме и не отказываемся от выявленной сути, меняем лишь подачу материала.

Например, можно спросить: каким образом лучше всего это решить? Но возможен и такой вопрос: а каков наихудший способ решения? В ответе на оба этих вопроса — знание, и мы должны проанализировать оба варианта.

Проблема может иметь не только разную форму, но и множество очертаний. Разные очертания заключают в себе разные истины.

Умножаем сущность всех вводных данных

Притом, что важно уделять внимание качеству идей, не менее важно, пожалуй, думать о количестве. Нас волнуют не только итоговые цифры, но и то, как мы приходим к этим цифрам.

Для решения задачи необходима хорошая идея. В свою очередь, найти хорошую идею обычно удается лишь после того, как отбросишь множество плохих. Так или иначе, выдавать на-гора все, что приходит в голову — не вариант. Дело не только в этом.

В годы Второй мировой войны Шеннон познакомился с Аланом Тьюрингом, еще одним первопроходцем информатики. Пока Тьюринг был в США, они встречались почти каждый день. Долгие годы они не теряли контакта, оба уважали идеи друг друга и наслаждались компанией друг друга.

Шеннон, рассуждая о том, что же на его взгляд составляет сущность гения, воспользовался аналогией, подсказанной Тьюрингом, и на ее основе вывел одно тонкое наблюдение. По словам самого Шеннона:

Есть такие люди, которым закинешь идею в голову — и на выходе получишь половину новой идеи. Некоторые способны на большее: они выдают по две новые идеи на каждую полученную.

Из скромности он отказывался причислять себя ко второй категории, относя к ней, например, Ньютона. Однако, если присмотреться к ситуации, то понятно, что у нас в игре. Речь не только о количестве.

Любые исходные данные в основе своей несут истину, которая не заметна при поверхностном рассмотрении. Истина — это основа для множества разнообразных решений множества разных задач.

Полагаю, Шеннон догадался, что генерация хороших идей требует умножать сущность каждых данных. Плохие идеи могут появляться, если вы неправильно уловили суть, но, чем лучше вы ее очерчиваете, тем плодотворнее будет ваш поиск озарений.

Удвоение отдачи от ваших идей — это первый шаг, но по-настоящему важно схватывать их суть.

Все, что нужно знать

Значительная часть жизни — будь то в работе, в отношениях с людьми, в заботе о себе — сводится к выявлению проблемы и умению к ней подступиться так, чтобы затем она миновала.

Возможно, Клод Шеннон был гением-одиночкой, обладал уникальным разумом, но его метод вполне доступен для любого из нас. Сила его была именно в этом методе и умении его применять.

Умение хорошо решать задачи — плод как критического, так и творческого мышления. Наилучший способ их скомбинировать — вооружиться методом, который позволит максимально выгодно использовать и то, и другое.

Паттерны мышления формируют наш разум. Цель — выработать для этого правильные паттерны.

О переводчике

Перевод статьи выполнен в Alconost.

Alconost занимается локализацией игр, приложений и сайтов на 70 языков. Переводчики-носители языка, лингвистическое тестирование, облачная платформа с API, непрерывная локализация, менеджеры проектов 24/7, любые форматы строковых ресурсов.

Мы также делаем рекламные и обучающие видеоролики — для сайтов, продающие, имиджевые, рекламные, обучающие, тизеры, эксплейнеры, трейлеры для Google Play и App Store.

Жонглер, отец теории информации и просто гений, который создал бит.

Клод Шеннон — американский ученый, который придумал и заложил основы теории информации. Десятки лет назад он написал работу, благодаря которой у нас есть интернет. Идеи Шеннона — это то, что позволяет нам передавать и хранить данные. Рассказываем, как он жонглировал идеями, почему они до сих пор важны и за что его называют самым веселым ученым поколения.

С чего все началось

В 1937 Шеннон опубликовал магистерские тезисы, которые позднее назвали самой важной магистерской диссертацией в истории. В своей работе он применил Булеву алгебру к схемам коммутации.

В 1941 Шеннон устроился на работу в американскую лабораторию Bell Labs, известную нам тем, что там появились первые разработки в области искусственного интеллекта.

Эта статья стала основой для теории информации.

Первая схема процесса обмена информацией, которую изобразил Шеннон в своей работе в 1948 году. Комментируя схему, ученый объяснил, что каналом коммуникации может быть, например, пучок света, коаксиальный кабель или диапазон радиочастот.

Конспект вебинара Data Scientist в Airbus.

ML-инженер Proxet Дмитрий Войтех — о работе с Giphy.

Вот какая идея была в центре теории Шеннона:

Вероятностный шум усиливает неопределенность, которую предстоит прояснить получателю.

В 1955 Шеннона удостоили медали Стюарта Баллантайна — приза за научные и технические достижения, который выдавал Институт Франклина в Пенсильвании. В 1958 году ученый стал профессором MIT, при этом отказавшись преподавать.

Что еще сделал Клод Шеннон

- Создал теорему жонглирования. Клод Шеннон сам любил жонглировать и построил из деталей конструктора Erector механизм, который жонглировал тремя металлическими шариками.

В начале 1980-х годов Шеннон опубликовал первую формальную математическую теорему жонглирования, сопоставляя продолжительность времени, пока мячи находятся в воздухе, с тем, как долго каждый мяч остается в руке жонглера. Его теорема продемонстрировала важность скорости рук для успешного жонглирования.

В 1993 году Клод Шеннон попал в дом престарелых, а в 2001 умер после длительной борьбы с болезнью Альцгеймера.

Читайте также: